英语原文共 9 页

视觉问答的分层次问题-图像协同注意模型

Jiasen Lu, Jianwei Yang, Dhruv Batra, Devi Parikh

Virginia Tech, Georgia Institute of Technology

摘要

近年来的一些研究提出了视觉问答(VQA)的注意力模型,它们生成空间地图,突出显示图像中与问题相关的区域。在本文中,我们认为除了建模实现“往哪里看”或关注图像外,“要听什么词”或关注问题同样重要。我们提出了一个新的VQA协同注意模型,同时推断图像和问题上的注意力。此外,我们的模型通过一维卷积神经网络(CNN)以分层方式处理问题(并通过协同注意机制同时处理图像)。 我们的模型将VQA数据集的准确率从现有的60.3%提高到60.5%,在COCO-QA数据集上从61.6%提高到63.3%。通过使用ResNet,两者的性能进一步提高到62.1%和65.4%。

1 引言

视觉问答(VQA)[2,6,14,15,27]已成为学术界和工业界著名的多学科研究问题。要正确回答有关图像的视觉问题,机器需要同时理解图像和问题。最近,关于VQA的视觉注意力模型[18,21-23]已被研究出来,其中注意力机制通常生成一个空间地图,突出显示图像中与所要回答的问题相关的区域。

到目前为止,VQA相关文献中的所有注意力模型都集中在识别“往哪里看”或视觉注意的问题上。在本文中,我们认为识别“听哪些词”或关注问题同样重要。考虑问题“how many horses are in this image?”和“how many horses can you see in this image?”,它们具有相同的含义,基本上由前三个单词决定。关注前三个单词的机器对于与问题的意义和答案无关的语言变异更具鲁棒性。受此观察的启发,除了对视觉注意的推理外,我们还致力于对问题的关注。具体来说,我们针对VQA提出了一种新颖的多重注意力模型,它具有以下两个独特的功能:

协同注意:我们提出了一种新的机制,共同推理视觉关注和问题关注,称之为协同注意。与之前仅关注视觉注意的研究不同,我们的模型在图像和问题之间具有自然对称性,在这种情况下,图像用于引导问题的注意力,而问题则用来引导图像的注意力。

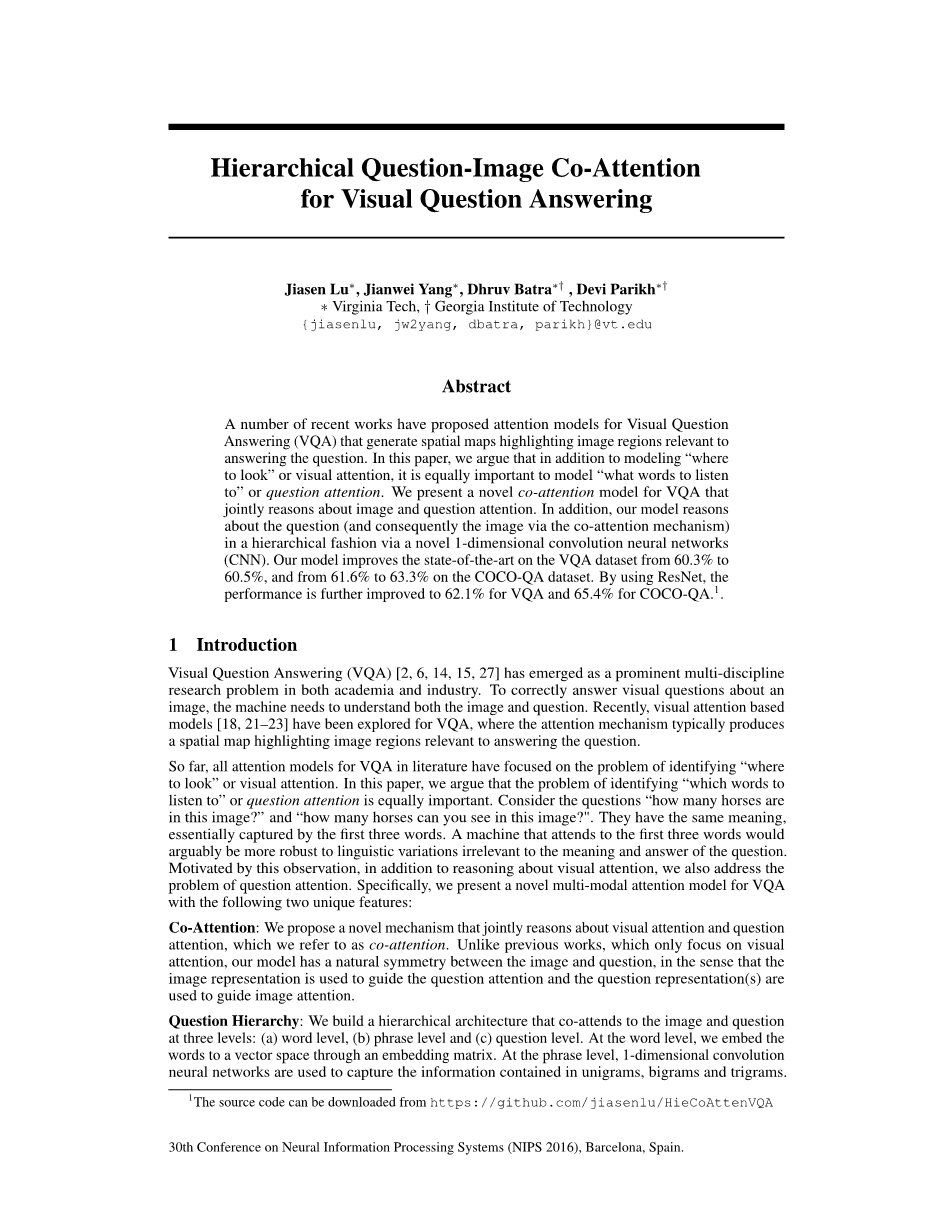

问题分层:我们构建了一个层次结构,在三个层次上协同注意图像和问题:(a)单词层级,(b)短语层级和(c)问题层级。在单词层级,我们通过嵌入矩阵将单词嵌入到向量空间中。在短语层级,用一维卷积神经网络捕获一元、二元、三元词组中包含的信息。

具体来说,我们将单词表示与不同支持的时间过滤器进行卷积,并将各种n元响应组合到一个短语层级的表示中。在问题层级,我们使用循环神经网络对整个问题进行编码。对于这个层次结构中的每个问题表示级别,我们构造问题和图像的协同注意图,然后递归地组合它们,最终预测答案的分布。

总的来说,我们工作的主要贡献是:

bull;我们提出了一种新的VQA协同注意机制,该机制可以协同进行问题引导的视觉注意和图像引导的问题注意。我们用并行和交替的协同注意两种策略来探索这种机制,如3.3节所述;

图1:我们提出的分层协同注意模型的流程图。给定一个问题,我们提取其单词层级,短语层级和问题层级的嵌入。在每个层级,我们都对图像和问题应用协同注意。最终答案的预测基于所有参与协同注意的图像和问题的特征。

bull;我们提出了一个分层结构来表示问题,从而在单词、短语和问题三个不同的层级上构建了图像-问题协同注意图。然后将这些联合的特征从单词层级递归地组合到问题层级,以得到最终的答案预测;

bull;在短语级,我们提出了一种新型的卷积池策略,自适应地选择短语大小,将其表示传递给问题层级的表示;

bull;最后,我们在VQA[2]和COCO-QA[15]两个大数据集上评估了我们提出的模型。我们还进行消融实验来量化模型中不同成分的作用。

2 相关工作

近年来的许多研究[2,6,11,14,15,25]提出了VQA的模型。我们将提出的协同注意机制与文献中其他视觉和语言的注意机制进行了比较和联系。

图像关注。与直接使用深度CNN全连接层的整体图像嵌入(如[2,13 - 15])不同,最近的一些工作探索了VQA的图像关注模型。Zhu等人将空间注意力添加到用于指向和接地QA的标准LSTM模型中。Andreas等人提出了一种由语言分析器和多个神经模块网络组成的组合方案。语言分析器预测应该实例化哪个神经模块网络来回答这个问题。其他一些文献则以叠加的方式多次进行图像关注。在[23]中,作者提出了一个叠加注意力网络,它运行多个跳数来逐步推断出答案。为了从问题中获取细粒度信息,Xu等人[22]提出了一种多跳图像关注方案。它首先将单词与第一跳中的图像块对齐,然后在第二跳中指向整个获取图像注意图的问题。在[18]中,作者生成带有对象建议的图像区域,然后选择与问题和答案选项相关的区域。Xiong等人[21]用一个新的输入融合模块增强了动态记忆网络,并从一个基于注意力的GRU中检索答案。在同时进行的工作中,[5]收集了“人类注意图”,用于评估由VQA的注意力模型生成的注意图。所有这些方法都仅建模解决视觉注意力,而不考虑问题注意力。此外,[22,23]依次对注意力进行建模,即后期注意力建立在前期注意力的基础上,容易导致错误差的传播。相反,我们在三个层次上独立地进行协同注意。

语言关注。虽然在VQA中还没有对问题注意力的研究,但是在自然语言处理(NLP)领域中已经有一些相关的工作对问题注意力进行了建模。为了克服长句翻译的困难,Bahdanau等人[3]提出RNNSearch来学习输入句子的对齐。在[8]中,作者提出了一个注意力模型来克服文本阅读和理解中固定宽度隐藏向量带来的瓶颈。在[16]中提出了一种更细粒度的注意力机制。作者运用逐字神经注意力机制对两句话中隐含的意义进行了推理。[24]的作者也着力于对句子对建模,他们提出了一种基于注意力的二元CNN,用于在两个CNN层次结构之间协同执行注意力。在他们的工作中,提出并评价了三种注意力方案。在[17]中,作者提出了一种双向注意机制,将成对的输入投射到公共表示空间中。

3 方法

我们首先介绍本文中使用的符号。为了便于理解,我们对完整模型进行分部描述。首先,我们在第3.2节中介绍分层问题表示,然后在第3.3节中提出联合注意力机制。最后,第3.4节展示了如何递归地组合问题和图像特征并输出答案。

3.1 符号

给定一个含有T个单词的问题,它由表示,其中是第t个单词的特征向量。我们分别用, 和表示t状态的单词嵌入、短语嵌入和问题嵌入。图像的特征用表示,其中是空间位置n处的特征向量。每个层级中图像和问题的协同注意特征表示为和,其中。不同模块或层中的权值表示为,必要时使用适当的上下标。在接下来的论述中,我们省略了偏置项b以避免符号混乱。

3.2 问题分层

对给定的问题单词的独热编码,我们首先将单词嵌入向量空间(端到端学习)得到。为了计算短语特征,我们对单词嵌入向量应用一维卷积。具体地说,在每个词的位置,用一元、二元、三元三种窗口大小的滤波器计算词向量的内积。对于第t个单词,窗口大小s的卷积输出如下:

, (1)

其中是权重向量。将单词级特征适当填充0后,再输入到二元卷积和三元卷积中,以保持卷积后序列的长度。给出卷积结果后,我们对各个位置的不同n元对象应用最大池化来获得短语级特征

, (2)

我们的池化方法与之前的工作[9]不同,它在每个时间步长都自适应地选择不同的元特征,同时保持原始的序列长度和顺序。我们使用LSTM在最大池之后对序列进行编码。对应的问题层级特征是t时刻的LSTM隐藏向量。我们对问题的层次表示如图3(a)所示。

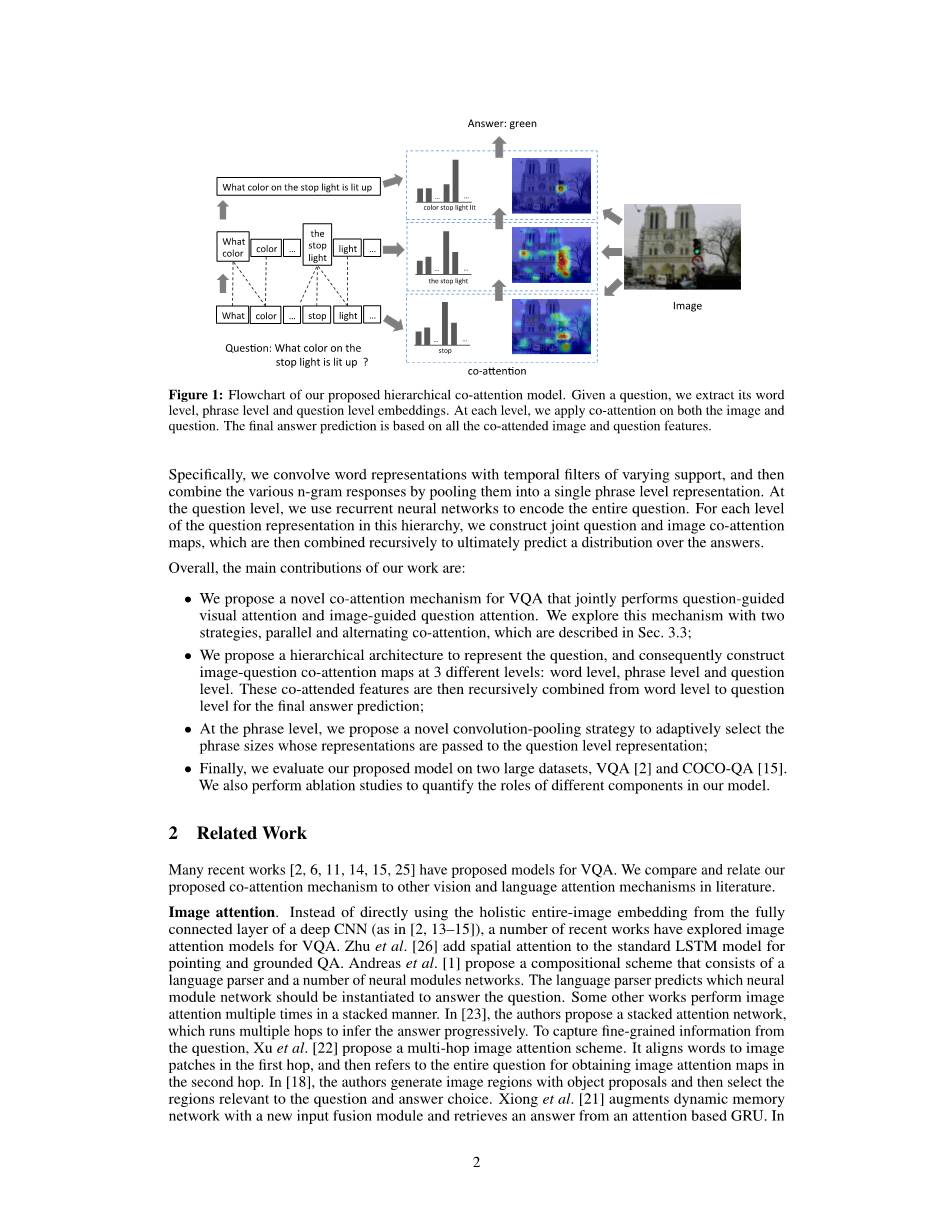

3.3 协同注意

我们提出了两种协同注意机制,它们在生成图像和问题注意图的顺序上有所不同。第一种机制我们称之为并行协同注意,同时产生图像和问题注意力。第二种为交替协同注意,在生成图像和问题注意之间依次交替。参见图2。这些协同注意机制在问题层次结构的所有三个层次上执行。

图2:(a)并行协同注意机制;(b)交替协同注意机制

并行协同注意。并行协同注意同时兼顾图像与问题。与[22]相似,我们通过计算图像和问题特征在所有图像位置和问题位置上的相似性来连接图像和问题。具体来说,对于给定的图像特征图和问题表示,计算关联矩阵

(3)

其中包含权重。在计算了关联矩阵之后,计算图像(或问题)注意力的一种可能方法是简单地最大化其他形态位置上的关联度,即 和。我们没有选择最大激活,而是发现,如果我们将这个关联矩阵作为一个特征,并通过以下步骤学习预测图像和问题注意图,那么性能会得到改善:

(4)

其中,是权重参数。和分别为各图像区域和单词的注意概率。关联矩阵将问题注意空间转换为图像注意空间(反之亦然)。基于上述注意力权重,将图像和问题注意力向量由图像特征和问题特征的加权和计算,即

, (5)

在层次结构的每一个层级中执行并行协同注意,得到和其中。

交替协同注意。在这种注意力机制中,我们依次交替生成图像和问题注意。简而言之,这包括三个步骤(如图2b所示):1)将问题总结为单个向量;2)基于关注图像;3)根据图像特征再关注问题。

具体地说,我们定义一个关注操作,将图像(或问题)的特征和由问题(或图像)得到的关注引导作为输入,并输出了图像(或问题)向量。操作可以通过以下步骤表示

(6)

其中是元素均为1的向量。和是参数。是特征的注意力权重。

交替协同注意的过程如图2 (b)所示。第一步,,为0;第二步,,是图像的特征,引导是第一步中中间问题特征;最后,我们使用图像特征作为引导再次关注问题,即,。与并行协同注意类似,交替协同注意也在层次结构的每个层级执行。

图3:(a)分层次问题编码(3.2节);(b)编码预测答案(3.4节)

3.4预测答案的编码

与[2]相同,我们将VQA视为一个分类任务。从三个层级的图像和问题特征来预测答案,使用多层感知器(MLP)递归编码注意力特征,如图3(b)所示。

(7)

其中,,和是权重参数,[·]是两个向量的连接操作,是最终答案的可能性。

4 实验

4.1 数据集

我们在VQA[2]和COCO-QA[15]两个数据集上对所提出的模型进行了评估。

VQA数据集[2]是该问题最大的数据集,包含了Microsoft COCO数据集[12]上的人工标注问答。该数据集包含248,349个训练问题、121,512个验证问题、244,302个测试问题和总共6,141,630对问答。根据回答类型,可以分是否、数字和其他三大类,每个问题都有10个自由答案。我们使用最常见的前1000个答案作为类似于[2]的可能输出。这组答案覆盖了训练 验证答案的86.54%。对于测试,我们在VQA训练 验证集上训练我们

资料编号:[5617]