英语原文共 11 页

- FCN:基于区域的全卷积网络目标检测

摘要

我们提出了基于区域的全卷积网络,以实现准确和有效的目标检测。与先前的基于区域的检测器相比,如快速/快速的R-CNN [6,18],其应用昂贵的每区域子网络数百次,我们的基于区域的检测器是完全卷积的,几乎所有的计算都在整个图像上共享。为了实现这一目标,我们提出位置敏感分数图来解决图像分类中的平移不变性与物体检测中的平移变异之间的两难境地。因此,我们的方法自然会采用完全卷积图像分类器骨干,如最新的残余网络(ResNets)[9],用于对象检测。我们使用101层ResNet在PASCAL VOC数据集上展示竞争结果(例如,2007年的83.6%mAP)。同时,我们的结果是在每张图像170ms的测试时间速度下实现的,比R-CNN更快的速度快2.5-20倍。代码公开发布在:https://github.com/daijifeng001/r-fcn。

1引言

一个流行的用于目标检测的深度网络[8,6,18]可以由感兴趣区域(RoI)池层[6]划分为两个子网络:(i)共享的“完全卷积”子网独立(ii)不共享计算的Roi-wise子网。这种分解[8]历史上是由先驱分类体系结构产生的,例如AlexNet [10]和VGG Nets [23],它们由两个子网络组成 - 一个以空间池层结尾的卷积子网络,后面是几个全连接(fc)层。因此,图像分类网络中的(最后一个)空间池层在对象检测网络中自然地变成了RoI池层[8,6,18]。

但是最近的最先进的图像分类网络,如残留网络(ResNets)[9]和GoogLeNets [24,26],完全是卷积设计2。通过类推,使用所有卷积层在对象检测体系结构中构造共享的卷积子网络似乎是自然的,使得RoI方式的子网络没有隐藏层。然而,正如在这项工作中经验性地研究的那样,这种天真的解决方案的检测精度差得多,与网络的卓越分类精度不相符。为了解决这个问题,在ResNet文件中

[9]更快的R-CNN探测器[18]的RoI池层非自然地插入在两组卷积层之间 - 这产生了更深的RoI方向的子网络,以更低的速度为代价提高了精度,这是由于未共享的-RoI计算。

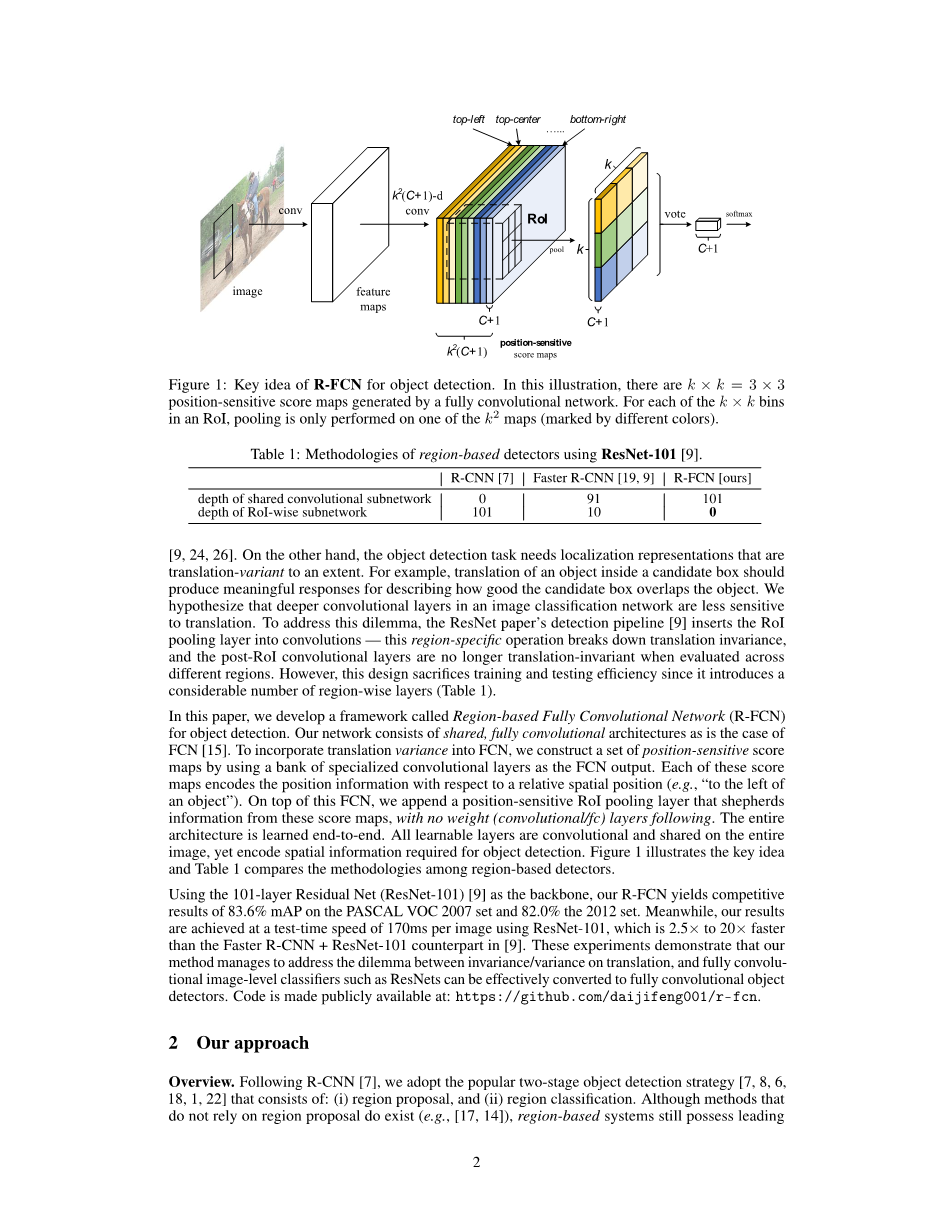

我们认为前面提到的非自然设计是由图像分类的增加平移不变性与对象检测的平移方差的两难问题引起的。一方面,图像级别的分类任务有利于平移不变性 - 图像内物体的移动应该是无差别的。因此,深度(完全)卷积体系结构尽可能翻译不变,这一点可以从ImageNet分类的主要结果中得到证实[9,24,26]。另一方面,物体检测任务需要在一定程度上是翻译变体的本地化表示。例如,在候选框内翻译对象应该产生有意义的响应来描述候选框与对象的重叠程度。我们假设图像分类网络中较深的卷积层对翻译不太敏感。为了解决这个困境,ResNet论文的检测流水线[9]将RoI池层插入卷积 - 这个区域特定的操作打破了平移不变性,而且当RoI后卷积层在不同区域评估时不再是平移不变的。然而,这种设计牺牲了培训和测试效率,因为它引入了大量的区域层面(表1)。

*当李毅在微软研究院实习时,这项工作就完成了。

2只有最后一层是完全连接的,在对物体检测进行微调时将被移除和替换。

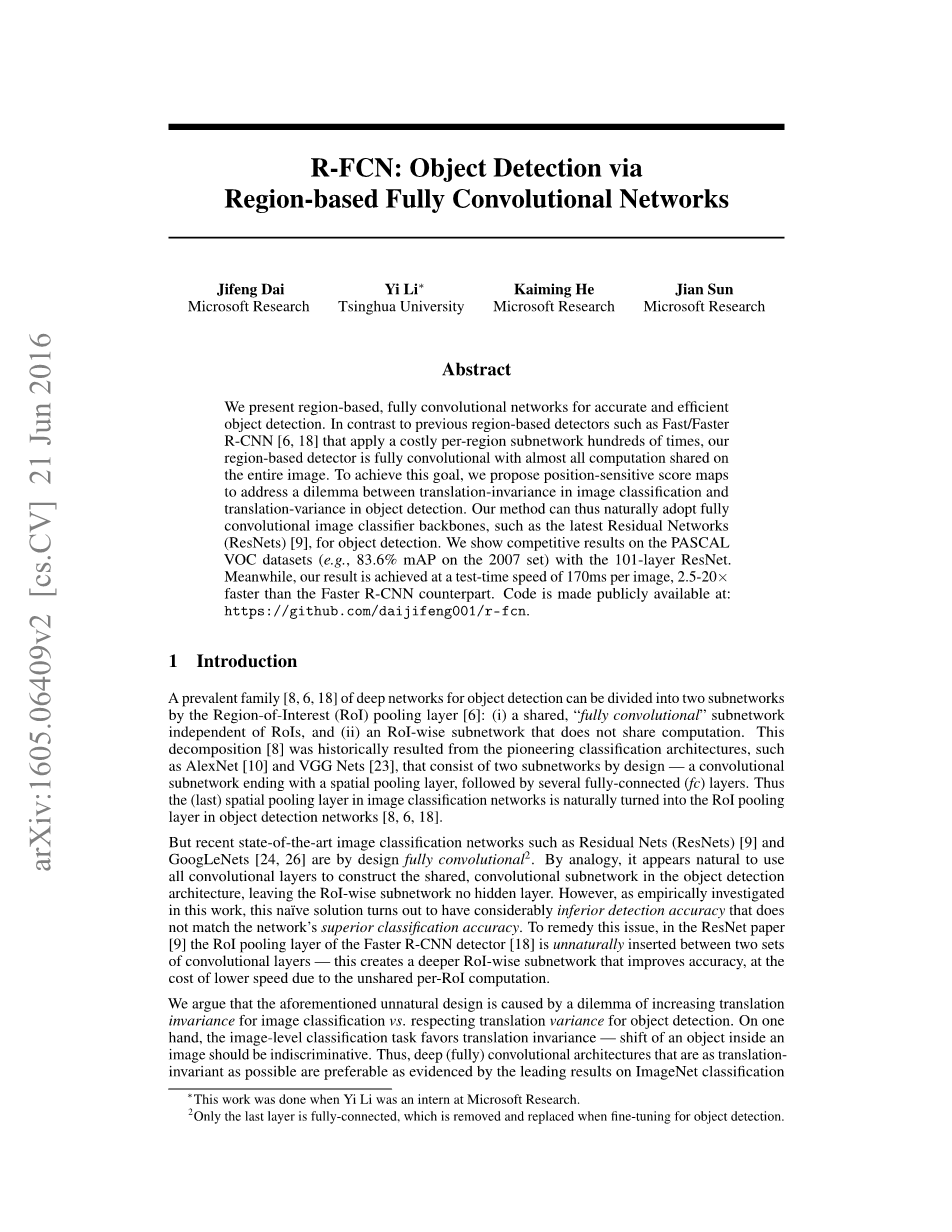

图1:R-FCN用于物体检测的主要思想。在这个例子中,有一个完全卷积网络生成的 位置敏感分数图。对于RoI中的每个箱,池只在地图中的一个上执行(用不同颜色标记)。表1:使用ResNet-101的基于区域的检测器的方法[9]。

在本文中,我们开发了一个称为基于区域的全卷积网络(R-FCN)的框架用于物体检测。我们的网络由共享的完全卷积体系结构组成,就像FCN [15]一样。为了将转换方差并入FCN,我们使用一组专门的卷积层作为FCN输出来构建一组位置敏感分数图。这些分数图中的每一个都相对于相对空间位置(例如,“在对象的左边”)编码位置信息。在这个FCN之上,我们添加了一个位置敏感的RoI池层,它从这些评分图中捕获信息,而后面没有权重(卷积/ fc)层。整个架构是端到端学习的。所有可学习的图层都是卷积的并且在整个图像上共享,但编码对象检测所需的空间信息。图1说明了关键思想,表1比较了基于区域的检测器的方法。

使用101层残留网络(ResNet-101)[9]作为主干网,我们的R-FCN在2007年PASCAL VOC中获得83.6%mAP的竞争结果,2012年达到82.0%。同时,使用ResNet-101,我们的结果是在每个图像170ms的测试时间速度下实现的,比[9]中更快的R-CNN ResNet-101速度快了2.5倍到20倍。这些实验表明,我们的方法设法解决了翻译不变性/方差之间的困境,而完全卷积图像级别的分类器(如ResNet)可以有效地转换为完全卷积对象检测器。代码公开发布在:https://github.com/daijifeng001/r-fcn。

2我们的方法

概述。在R-CNN [7]之后,我们采用了流行的两阶段目标检测策略[7,8,6,18,1,22],它包括:(i)区域提议和(ii)区域分类。尽管不依赖区域提案的方法确实存在(例如[17,14]),但基于区域的系统在几个基准测试中仍然具有领先的准确性[5,13,20]。我们通过区域提议网络(RPN)[18]提取候选区域,它本身就是完全卷积体系结构。在[18]之后,我们分享了RPN和R-FCN之间的特征。图2显示了该系统的概述。

图2:R-FCN的总体架构。地区提案网络(RPN)[18]提出了候选RoI,然后将其应用于得分地图。所有可学习的权重层都是卷积的,并在整个图像上进行计算;每个RoI的计算成本可以忽略不计。

鉴于提案区域(RoIs),R-FCN架构旨在将RoI归类为对象类别和背景。在R-FCN中,所有可学习的权重层都是卷积的,并在整个图像上计算。最后一个卷积层为每个类别生成一组位置敏感分数图,因此具有一个带有C对象类别( 1用于背景)的-通道输出层。分数地图库对应于描述相对位置的空间网格。例如,在中,9个分数地图对对象类别的{左上角,右上角,右上角,...,右下角}进行编码。

R-FCN以一个位置敏感的RoI池层结束。该层聚合最后一个卷积层的输出并为每个RoI生成分数。与[8,6]不同,我们对位置敏感的RoI层进行选择性池化,并且 bin中的每个bin都只从分数图的银行中的一个分数映射进行响应。通过端到端的培训,这个RoI层为最后一个卷积层提供了专门的位置敏感分数图。图1说明了这个想法。图3和图4显示了一个例子。详细介绍如下。

本文中R-FCN的化身基于ResNet-101 [9],但其他网络[10,23]也适用。ResNet-101有100个卷积层,其次是全球平均池和1000级的fc层。我们删除平均共享层和fc层,并仅使用卷积层来计算特征映射。我们使用由[9]的作者发布的ResNet-101,在ImageNet上预先训练过[20]。ResNet-101中的最后一个卷积块是2048-d,我们附加了一个随机初始化的1024-d 1times;1卷积层以减小尺寸(准确地说,这增加了表1中的深度1)。然后我们应用-通道卷积层来生成评分图,如下所述。

位置敏感分数图和位置敏感的RoI池。为了将位置信息明确地编码到每个RoI中,我们用规则网格将每个RoI矩形分成个分箱。对于大小为的RoI矩形,箱的大小为 [8,6]。在我们的方法中,最后的卷积层被构造为为每个类别产生分数图。在第二个分档()中,我们定义了一个位置敏感的RoI池操作,该操作仅在分数地图上进行搜索:

这里是第c个类别中的第n个池中的合并响应,是分数图中的一个分数图,表示RoI的左上角,n是bin,Theta;表示网络的所有可学习参数。料箱跨越和。公式(1)的操作如图1所示,其中颜色表示一对。公式(1)执行平均汇集(正如我们在本文中使用的那样),但最大汇集也可以进行。

位置敏感分数随后对RoI投票。在本文中,我们简单地通过对得分进行平均来投票,为每个RoI产生一个维向量:。然后我们计算跨类别的softmax响应:。它们用于评估训练期间的交叉熵损失和推理期间的RoI排名。

我们以类似的方式进一步解决边界框回归[7,6]。除了上面的-d卷积层以外,我们在边界框回归中附加了一个同胞-d卷积层。位置敏感的RoI池在地图库上执行,为每个RoI生成一个 -d矢量。然后通过平均投票将其聚合成四维矢量。这个4-d向量在[6]中的参数化之后以的形式将边界框参数化。我们注意到为简单起见,我们执行类不可知边界框回归,但类特定的对应(即带有 -d输出层)是适用的。

位置敏感分数图的概念部分受到[3]的启发,该开发将FCN发展为实例级语义分割。我们进一步介绍位置敏感的RoI池层,它可以学习评分图学习对象检测。RoI层之后没有可学习的层,可以实现近乎无成本的区域计算并加速训练和推理。

训练。通过预先计算的区域提案,很容易实现端到端训练R-FCN架构。在[6]之后,我们在每个RoI上定义的损失函数是交叉熵损失和方框回归损失的总和:。这里是RoI的地面实况标签(意味着背景)。是分类的交叉熵损失,是[6]中定义的边界框回归损失,表示地面实况框。是一个指标,如果参数为true,则等于1,否则为0。我们按照[6]设置平衡重量。我们定义了一些积极的例子,因为具有交叉交叉(IoU)的RoIs与至少为0.5的地面实况框重叠,否则为负。

我们的方法很容易在培训期间采用在线硬示例挖掘(OHEM)[22]。我们可忽略的per-RoI计算使得几乎无成本的示例挖掘成为可能。假设每个图像有N个提案,在正向传递中,我们评估所有N个提案的损失。然后,我们按损失对所有RoIs(正面和负面)进行排序,并选择损失最高的B RoIs。反向传播[11]是基于所选示例执行的。由于我们的per-RoI计算可以忽略不计,所以转发时间几乎不受N的影响,与[22]中的OHEM Fast R-CNN相比,这可能使训练时间加倍。我们在下一节的表3中提供全面的时间统计。

我们使用0.0005的重量衰减和0.9的动量。默认情况下,我们使用单尺度训练:调整图像的大小以使比例(图像的较短边)为600像素[6,18]。每个GPU拥有1个图像并选择 RoI作为反向传播。我们使用8个GPU来训练模型(所以有效的最小批量是)。我们使用20k小批量的0.001的学习率和10k小批量的0.0001学习率对R-FCN进行微调。为了使R-FCN与RPN共享特征(图2),我们采用[18]中的4步交替训练3,在训练RPN和训练R-FCN之间交替。

推理。如图2所示,计算RPN和R-FCN之间共享的特征地图(在单一比例为600的图像上)。然后,RPN部分提出RoI,R-FCN部分在其上评估分类明确分数并回归边界框。在推断过程中,我们评估了300个RoIs,正如[18]中的公平比较。作为标准实践,使用阈值0.3 IUU [7]对结果进行非最大抑制(NMS)后处理。

有点和大步。我们的完全卷积体系结构享有FCN广泛用于语义分割的网络修改的好处[15,2]。特别是,我们将ResNet-101的有效步幅从32像素降低到了16像素,从而提高了分数图分辨率。conv4阶段之前和之后的所有图层[9](跨度= 16)不变;第一个conv5模块中的stride = 2操作被修改为stride = 1,并且conv5阶段的所有卷积滤波器都被“孔算法”[15,2](“Algorithmeagrave;trous”[16])修改为弥补减少的步幅。为了进行公平的比较,RPN在conv4阶段之上(与R-FCN共享)计算,如[9]中更快的R-CNN所示,所以RPN不受这种方法的影响。下表显示了R-FCN(,没有硬性示例挖掘)的消融结果。这个诀窍可以提高2.6点的MAP。

尽管联合训练[18]是适用的,但并不是直接进行示例挖掘。

图3:人类的R-FCN()的可视化。

图4:RoI不正确地重叠对象时的可视化。

可视化。在图3和图4中,我们可以看到R-FCN在时学习的位置敏感分数图。预期这些专用地图会在对象的特定相对位置被强烈激活。例如,“顶部中心敏感”分数图大致在物体的顶部中心位置附近呈现高分数。如果候选框与真实对象精确重叠(图3),则RoI中的大多数分组都被强烈激活,并且他们的投票导致高分。相反,如果候选框与正确对象没有正确重叠(图4),则RoI中的一些分组未被激活,并且投票分数较低。

3相关工作

R-CNN [7]已经证明了使用深度网络的区域提案[27,28]的有效性。R-CNN评估裁剪区域和变形区域的卷积网络,计算不在区域间共享(表1)。SPPnet [8],Fast R-CNN [6]和Faster R-CNN [18]是“半协议式”,其中卷积子网络对整个图像执行共享计算,另一个子网络评估各个区域。

已经有可以被认为是“完全卷积”模型的物体检测器。OverFeat [21]通过在共享卷积特征映射上滑动多尺度窗口来检测对象;同样,在Fast R-CNN [6]和[12]中,研究了替代区域建议的滑动窗口。在这些情况下,可以将单一刻度的滑动窗口重新设计为单个卷积层。更快的R-CNN [18]中的RPN组件是一种完全卷积检测器,可以相对于多种尺寸的参考盒(锚)预测边界盒。最初的RPN在[18]中是类不可知论的,但是它的类特定的对应物是适用的(参见[14]),我们在下面进行评估。

表2:使用ResNet-101的完全卷积(或“几乎”完全卷积)策略之间的比较。这张桌子上的所有竞争者都使用这种方法。硬性示例挖掘不进行。

另一个物体探测器家族采用全连接(fc)层来在整个图像上生成整体物体检测结果,如[25,4,17]。

4实验

4.1 PASCAL VOC的实验

我