英语原文共 14 页,剩余内容已隐藏,支付完成后下载完整资料

在没有人类知识的情况下掌握围棋游戏

摘 要

人工智能的一个长期目标是从“白板”开始,在挑战性领域达到超越人类的学习算法。最近,AlphaGo成为第一个在围棋中击败世界冠军的程序。AlphaGo中的树搜索使用深度神经网络评估局面和选定走子。这些神经网络是通过来自人类专家下棋的监督学习和通过从自我对弈中强化学习来训练的。在这里,我们介绍一个完全基于强化学习的算法,无须人类数据、指导或游戏规则以外的领域知识。AlphaGo成为自己的老师:训练一个神经网络,预测AlphaGo自己的走子选择。这个神经网络提高了树搜索的强度,在下一次迭代中产生更高质量的走子选择和更强的自我对弈。从“白板”开始,我们的新程序AlphaGo Zero实现了超人的表现,对之前的程序AlphaGo赢得了100-0的成绩。

在人工智能方面取得了很大的进展,使用了经过训练的监督学习系统来复制人类专家的决策。但是,专家数据往往昂贵,不可靠,或者根本无法使用。即使有可靠的数据,也可能会对以这种方式进行训练的系统的性能施加上限。相比之下,强化学习系统是根据它们自己的经验进行训练的,原则上允许它们超越人类的能力,并在缺乏人类专家的领域工作。最近,通过强化学习训练的深度神经网络,朝着这个目标快速发展。在Atari和3D虚拟环境等电脑游戏中,这些系统已经超越了人类。然而,在人类智力方面最具挑战性的领域 - 比如被广泛认为是人工智能面临的巨大挑战的围棋游戏 - 在广阔的搜索空间中需要精确和复杂的前瞻。完全通用的方法以前在这些领域没有实现人类级别的表现。

AlphaGo是第一个在围棋中实现超人表现的程序。我们称之为AlphaGo Fan的发行版在2015年10月击败了欧洲冠军樊麾。AlphaGo Fan使用了两个深度神经网络:输出走子概率的策略网络和输出局面评估的价值网络。策略网络最初是通过监督学习来训练的,以准确地预测人类专家的走子,并随后通过策略梯度强化学习进行改进。价值网络经过训练,可以预测策略网络与自己下棋的胜利者。一旦训练完成,这些网络与蒙特卡洛树搜索(MCTS)相结合,提供了一个前瞻性搜索,使用策略网络缩小高概率走子的搜索范围,并使用价值网络(与Monte-Carlo 使用快速展开策略rollout)来评估树中的局面。随后的版本,我们称之为AlphaGo Lee,采用了类似的方法(见方法),并在2016年3月击败了赢得18个国际冠军的李世石。

我们的AlphaGo Zero程序在几个重要方面与AlphaGo Fan和AlphaGo Lee 不同。首先,它是完全由自我对弈强化学习训练的,从随机下棋开始,没有任何监督或使用人类的数据。其次,它只使用黑子和白子作为输入特征。第三,它使用单一的神经网络,而不是分别使用策略和价值网络。最后,它使用更简单的树搜索,依靠这个单一的神经网络来评估局面和选择走子,而不需要执行任何rollouts(快速走子)。为了达到这些效果,我们引入了一种新的强化学习算法,在训练迭代中引入了前瞻搜索,从而实现了快速的提升和精确稳定的学习。搜索算法、训练过程和网络结构中的技术差异将在方法中描述。

AlphaGo Zero中的强化学习

我们的新方法使用参数为theta;的深度神经网络。该神经网络将s的位置及其历史的原始板表示作为输入,并输出移动概率和评估值。移动概率p的向量表示选择每个移动a(包括不被应用)的概率,将它表示为。评估值v是一个标量,用来估计当前玩家从位置s获胜的概率。这个神经网络将策略网络和价值网络的角色结合到一个单一的体系结构中。神经网络由许多残留卷积层块组成,具有批量归一化和整流非线性(见方法)。

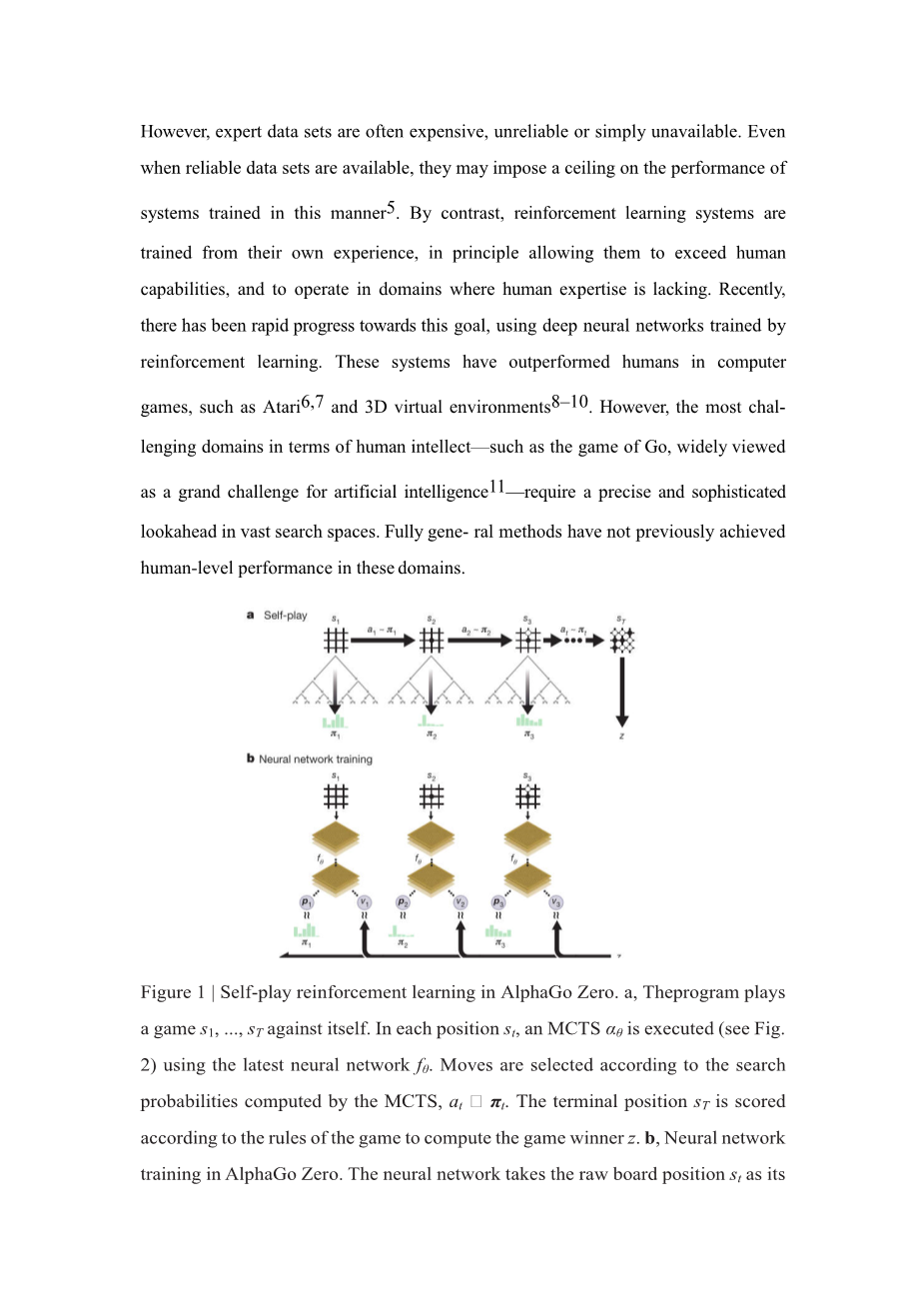

AlphaGo Zero中的神经网络是通过一种新型强化学习算法从自我游戏的游戏中训练出来的。在每个位置s,执行蒙特卡罗树搜索,由神经网络指导。蒙特卡罗搜索输出每次移动的概率pi;。这些搜索概率通常选择比神经网络的原始移动概率p更强的移动;因此,蒙特卡罗搜索可被视为一个强有力的策略改进器。自我对弈 - 使用改进的基于蒙特卡罗搜索的策略来选择每个策略移动,然后使用游戏获胜者z作为价值的样本 - 可以被看作是一个强大的策略评估操作员。我们的强化学习算法的主要思想是在策略迭代过程中重复地使用这些搜索算子:更新神经网络的参数以使移动概率和评估值更接近地匹配改进的搜索概率和自我对弈赢家; 这些新参数被用于下一次自我对弈,以使搜索更加强大。图1显示了自我训练过程。

图1 AlphaGo Zero中的自我强化学习

图1:AlphaGo Zero中的自我对弈强化学习。a,程序自我对弈状态 s1, ..., sT。在每个局面st,使用最新的神经网络执行蒙特卡罗树搜索alpha;theta;(见图2)。根据由蒙特卡罗树搜索计算的概率选择走子,at sim;pi;t。按照游戏规则对棋局结束状态sT进行评分得到游戏获胜者z。b,训练AlphaGo Zero神经网络。神经网络将棋局原始走子状态st作为其输入,将其输入给具有参数theta;的多个卷积层,并且输出表示走子概率分布的向量pt和表示当前玩家在局面st的获胜概率标量值vt。更新神经网络的参数theta;以使策略向量 pt与搜索概率pi;t的相似度最大化,并使得预测的获胜者vt和游戏胜者z之间的误差最小化(参见等式1)。新参数用于下一次迭代的自我对弈a中。

蒙特卡罗树搜索使用神经网络来指导(见图2)其模拟搜索树中的每个边(s, a) 存储先验概率P(s, a),访问计数N(s, a)和动作值Q(s, a)。每个仿真从根状态开始,并且迭代地选择使置信上限 Q(s, a) U(s, a),最大化的移动,其中公式如下:

U(s, a) prop; P(s, a)/(1 N(s, a))

直到遇到叶节点s#39;。这个叶位置被网络扩展和评估一次,以产生先验概率和评估,(P(s′, ·),V(s′)) = ftheta;(s′)。仿真中遍历的每个边(s, a)都会更新,以增加其访问计数N(s, a),并将其动作值更新为这些仿真的平均评估值如下:

Q(s, a) = 1/N(s, a) sum;s ′|s ,a→s ′ V (s′)

其中 s, a→s′表示从位置s开始,模拟最终达到s#39;。

蒙特卡罗树搜索可以被看作是一种自我对弈算法,在给定神经网络参数theta;和根位置s的情况下,计算推荐移动的搜索概率矢量, pi; = alpha;theta;(s),与每次移动的指数访问计数成比例pi;aprop; N(s, a)1/tau;,其中 tau; 是温度参数。

图2:AlphaGo Zero中的蒙特卡洛树搜索。a.每次模拟通过选择具有最大行动价值Q的边加上取决于所存储的先验概率P和该边的访问计数N(每次访问都被增加一次)的上限置信区间U来遍历树。b.展开叶子节点,通过神经网络 (P(s, ·),V(s)) = ftheta;(s)来评估局面s;向量P的值存储在叶子结点扩展的边上。c.更新行动价值Q等于在该行动下的子树中的所有评估值V的均值。d.一旦蒙特卡罗树搜索完成,返回局面s下的落子概率pi;,与N1/tau;,成正比,其中N是从根状态每次移动的访问计数,其中tau;是温度参数。

神经网络通过自我对弈强化学习算法进行训练,该算法使用蒙特卡罗树搜索下每一步棋。首先,神经网络随机初始化权重。在随后的每次迭代 i ge; 1时,生成自我对弈棋局(图1a)。在每个时间步t,使用前一次迭代的神经网络 执行蒙特卡罗树搜索,并且通过对搜索概率进行采样来执行走子。双方都选择跳过或当搜索值低于认输阈值时,或当游戏超过最大长度(棋盘无处走子)时,游戏在步骤T终止;然后对游戏进行评分给出最终奖励 (详见方法)。蒙特卡罗树搜索过程中每个时间步t的数据存储为,其中是当前玩家在步骤t的角度的游戏获胜者。同时(图1b),新的网络参数从上一次自我对弈的所有时间步产生的数据中采样进行训练。调整神经网络以最小化预测胜率v和自我对弈的胜者z之间的误差,并使神经网络走子概率p与搜索概率pi;的相似度最大化。具体而言,参数theta;通过梯度下降分别在均方误差和交叉熵损失之和上的损失函数l进行调整,,(1),其中c是控制L2权重正则化水平的参数(防止过拟合)。

AlphaGo Zero训练的经验分析

我们使用强化学习来训练AlphaGo Zero。从随机下棋开始,没有人为干预,持续训练约3天。在训练过程中,生成了490万个自对弈棋局,每次蒙特卡罗树搜索使用1600次模拟,每次走子花费大约0.4s的思考时间。使用2048个局面的70万个mini-batches训练参数。神经网络包含20个残差块(详见