英语原文共 13 页,剩余内容已隐藏,支付完成后下载完整资料

少样本学习的原型网络

Jake Snell

University of Torontolowast;

Kevin Swersky

Richard S. Zemel

University of Toronto, Vector Institute

arXiv:1703.05175v2 [cs.LG] 19 Jun 2017

摘要

我们针对少样本分类问题提出了原型网络。在该网络中,即使每个未在训练集中出现的新类实例很少,分类器也能学习到其归属类。原型网络可以通过计算样本到每个类的原型之间的距离即学习度量空间来执行分类。与最近的少样本学习方法相比,它们反映了一种更简单的归纳偏差,这种偏差在这种有限的数据体系中是有益的,并且取得了优异的结果。我们提供的分析表明,与最近涉及复杂架构选择和元学习的方法相比,一些简单的设计决策可以产生实质性的改进。 我们进一步将原型网络扩展到零样本学习,并在CU-Birds数据集上实现最先进的结果。

引言

少样本分类[20,16,13]是一项任务,其中必须调整分类器以适应训练中未见的新类,只给出这些类中的每一个的几个例子。有一种简单的方法,例如在新数据上重新训练模型,但是该模型有可能会严重过度拟合。虽然问题非常困难,但已经证明人类有能力进行一次性分类,其中只给出每个新类别的一个例子,具有高度的准确性[16]。

最近有两种方法在少数学习中取得了重大进展。Vinyals等人提出了匹配网络,该网络使用注意力机制而不是标记一组示例(支持集)的学习嵌入来预测未标记点(查询集)的类。匹配网络可以被解释为一种在嵌入空间内应用加权最近邻的分类器。值得注意的是,该模型在训练期间使用称为片段的采样小批量,其中每一片段都旨在通过二次分类和数据点来模仿少数几个任务。片段的使用使得训练问题更加忠实于测试环境,从而改善了泛化。Ravi和Larochelle[22]进一步采用了片段的训练理念,并提出了一种元学习的方法。他们的方法涉及训练LSTM[9]以产生对分类器进行更新,给定一个片段,以便它可以很好地应用到测试集。在这里,LSTM元学习器不是在多个片段中训练单个模型,而是学习为每个片段训练一个自定义模型。

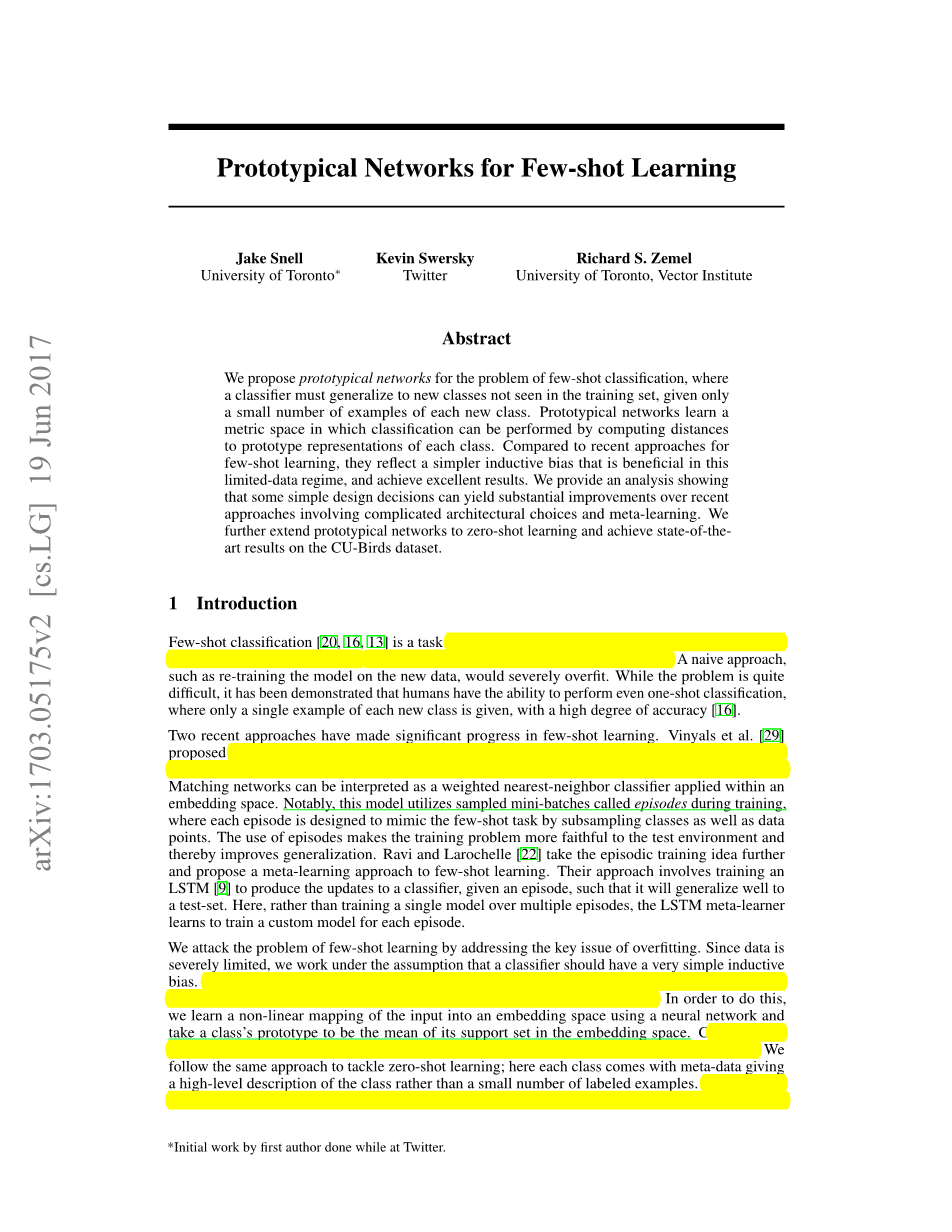

我们通过解决过度拟合的关键问题来解决少样本学习问题。因为数据受到严格限制,所以我们假设分类器应具有非常简单的归纳偏差。我们的方法是原型网络,它是基于嵌入的即同一类的样本都聚集在每个类的原型周围。为了做到这一点,我们使用神经网络将输入非线性映射到嵌入空间,然后将类的原型作为其在嵌入空间中支持集的平均值。然后,通过简单地找到最近的类原型,对嵌入的查询点执行分类。我们采用相同的方法来解决零样本学习问题; 这里的每个类都带有元数据,提供了类的高级描述,而不是少量的标记示例。因此,我们学习将元数据嵌入到共享空间中,以作为每个类的原型。

|

c2 c1 c3 x |

x c2 v1 c1 c3 v3 v2 |

|

(a) Few-shot |

(b) Zero-shot |

图1:在少样本和零样本环境中的原型网络。左边:几个原型被计算为每个类的嵌入支持示例的平均值。右边:通过嵌入类元数据产生零样本原型。在任何一种情况下,嵌入的查询点通过softmax在距离上分类到类原型:。

在几次少样本环境中通过为嵌入式查询点找到最近的类原型来执行分类。

在本文中,我们为少样本和零样本环境制定了原型网络。我们在一次性设置中绘制与匹配网络的连接,并分析模型中使用的基础距离函数。特别地,我们将原型网络与聚类[4]联系起来,以便在使用Bregman散度(例如欧氏距离平方)计算距离时证明使用类均值作为原型。我们从经验上发现距离的选择是至关重要的,因为欧氏距离大大优于更常用的余弦相似度。在几项基准测试任务中,我们实现了最先进的性能。原型网络比最近的元学习算法更简单,更有效,使它们成为少样本和零样本学习中最有吸引力的方法。

原型网络

说明

在少样本分类中,我们给出了一小组支持个类的样本例子,其中每个是一个样本例子的维特征向量,是相应的类标签。表示用类标记的一组样本例子。

模型

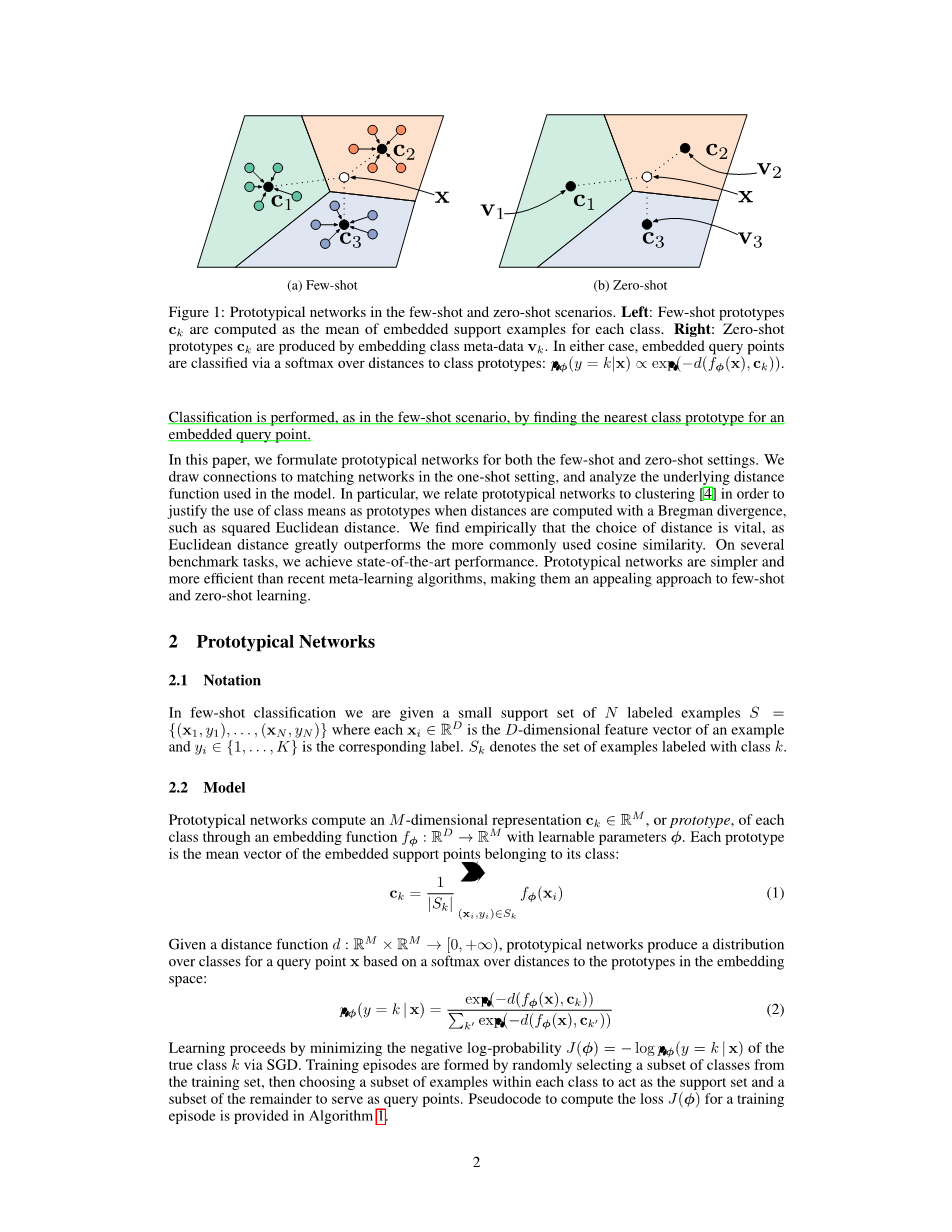

原型网络通过一个具有可学习参数phi;的嵌入函数计算每个类的维原型表示。每个原型是属于其类的嵌入式支持点的平均向量:

|

(1) |

给定距离函数,原型网络基于与嵌入空间中的原型距离的softmax在查询点x的类上产生分布:

|

(2) |

通过最小化经由SGD的正类的负对数概率来进行学习。通过从训练集中随机选择类的子集,然后选择每个类中的示例的子集以充当支持集并且将余数的子集用作查询点来形成训练集。在算法1中提供了用于计算训练集的损失的伪代码。

算法 1 训练原型网络的片段损失计算。是训练集中的示例数,是训练集中的类数,是每片段的类数,是每个类的支持示例数,是每个类的查询示例数。表示从集合中随机均匀选择的一组个元素,无需替换。

输入: 训练集,其中每个。表示包含所有元素的子集,使得。

输出: 随机生成的训练集的损失。

Select class indices for episode

for in do

Select support examples

Select query examples

Compute prototype from support examples

end for

for in do

for in do

end for

end for

作为混合密度估计的原型网络

对于特定类别的距离函数,称为常规Bregman散度[4],原型网络算法等效于在具有指数族密度的支持集上执行混合密度估计。常规Bregman散度定义为:

|

(3) |

其中是勒让德类型的可微分,严格的凸函数。Bregman散度的例子包括平方欧几里德距离和马哈拉诺比斯距离。

可以根据支持集上的硬集群来查看原型计算,每个类具有一个集群,每个支持点分配给其对应的类集群。已经显示[4]对于Bregman分歧,群集代表实现与其指定点的最小距离是群集均值。因此,当使用Bregman散度时,给定支持集标签时,等式(1)中的原型计算产生最优的簇代表。

此外,具有参数和累积量函数的任何正则指数族分布可以用唯一确定的常规Bregman散度来写出[4]。

|

(4) |

现在考虑具有参数的常规指数族混合模型:

|

(5) |

给定,未标记点的聚类分配的推断变为:

|

(6) |

对于每类具有一个簇的等加权混合模型,簇分配推断(6)等效于具有和的查询类预测(2)。在这种情况下,原型网络有效地执行混合密度估计,其中指数族分布由确定。因此,距离的选择指定了关于嵌入空间中的类条件数据分布的建模假设。

重新解释为线性模型

简单分析有助于深入了解学习分类器的本质。当我们使用欧几里德距离时,则等式(2)中的模型等效于具有特定参数化的线性模型[19]。要查看此内容,请在指数中展开术语:

|

(7) |

等式(7)中的第一项相对于类是恒定的,因此它不影响softmax概率。我们可以将剩下的术语写成线性模型,如下所示:

|

(8) |

在这项工作中,我们主要关注平方欧几里德距离(对应于球面高斯密度)。我们的结果表明欧几里德距离是一个有效的选择,尽管它与线性模型等价。我们假设这是因为所有必需的非线性都可以在嵌入函数中学习。实际上,这是现代神经网络分类系统目前使用的方法,例如[14,28]。

与匹配网络的比较

原型网络与少样本学习的匹配网络不同,在一次性场景中具有等效性。匹配网络[29]在给定支持集的情况下产生加权最近邻分类器,而原型网络在使用平方欧几里德距离时产生线性分类器。在一次性学习的情况下,,因为每个类只有一个支持点,匹配网络和原型网络变得相同。

一个自然的问题是,每个类使用多个原型而不是仅使用一个原型是否合理。如果每个类的原型数量固定且大于1,那么这将需要分区方案来进一步聚类类中的支持点。这已由Mensink等人[19]和Rippel等人[25]提出;但是这两种方法都需要一个与权重更新分离的单独分区阶段,而我们的方法很容易用普通的梯度下降方法学习。

Vinyals等人[29]提出了许多扩展,包括解耦支持和查询点的嵌入函数,以及使用考虑每集中特定点的第二级全条件嵌入(FCE)。这些同样可以合并到原型网络中,但是它们增加了可学习参数的数量,并且FCE使用双向LSTM在支持集上强加任意排序。相反,我们表明使用简单的设计选择可以达到相同的性能水平,我们接下来会概述。

设计选择

距离指标 Vinyals等人[29]Ravi和Larochelle[22]使用余弦距离应用匹配网络。然而,对于原型和匹配网络,任何距离都是允许的,我们发现使用平方欧几里德距离可以大大改善两者的结果。我们猜想这主要是由于余弦距离不是Bregman散度,因此2.3节中讨论的混合密度估计的等价性并不成立。

片段构成 构建片段的简单方法,用于Vinyals等人[29]和Ravi、Larochelle [22],是为每个类选择Nc类和NS支持点,以便在测试时匹配预期的情况。也就是说,如果我们期望在测试时执行5向分类和1-shot学习,则训练集可以包括,。然而,我们发现用比测试时更高的或“方式”训练是非常有益的。在我们的实验中,我们在保持的验证集上调整训练。另一个考虑因素是在训练和测试时间是否匹配或“shot”。对于原型网络,我们发现通常最好用相同的“shot”数进行训练和测试。

无样本学习

无样本学习与少样本学习的不同之处在于,我们不是给予一组支持训练点,而是为每个类提供一个类元数据向量。这些可以提前确定,或者可以从例如原始文本中学习[7]。修改原型网络以处理无样本情况很简单:我们只需将定义为元数据向量的单独嵌入。图1显示了与少样本程序相关的原型网络的无样本程序。由于元数据向量和查询点来自不同的输入域,我们发现将原型嵌入固定为单位长度是有用的,但是我们不限制查询嵌入。

表 1: Omniglot的少样本分类精度

5-way Acc. 20-way Acc.

模型 Dist. Fine Tune 1-shot 5-shot 1-shot 5-shot

|

MATCHING NETWORKS [29] |

Cosine |

N |

98.1% |

98.9% |

93.8% |

98.5% |

|

MATCHING NETWORKS 剩余内容已隐藏,支付完成后下载完整资料 |