英语原文共 11 页

参与和互动:视频理解的高阶对象交互

Chih-Yao Ma1, Asim Kadav2, Iain Melvin2, Zsolt Kira3, Ghassan AlRegib1, and Hans Peter Graf2

1佐治亚理工学院,2美国NEC实验室,3佐治亚技术研究所

摘要

人类行为通常涉及场景中几个相互关联的对象之间的复杂交互。然而,现有的细粒度视频理解或视觉关系检测方法通常依赖于单个对象表示或成对对象关系。此外,在数百帧的视频中跨多个对象进行学习交互在计算上是不可行的,并且由于必须对大的组合空间进行建模,因此性能可能会受到影响。在本文中,我们建议有效地学习任意子组之间的高阶交互,以便细粒度的视频理解。我们证明建模对象交互显着提高了动作识别和视频字幕的准确性,同时比传统的成对关系节省了3倍以上的计算量。所提出的方法在两个大规模数据集上得到验证:Kinetics和ActivityNet Captions。即使视频以最大1 FPS采样,我们的SINet和SINet-Caption也能在两个数据集上实现最先进的性能。据我们所知,这是在开放域大规模视频数据集上建模对象交互的第一个工作,我们还模拟了高阶对象交互,以低计算成本提高性能。

1、介绍

视频理解任务(如活动识别和字幕生成)对于监视,视频检索,人类行为理解等各种应用至关重要。最近,视频理解的数据集,如Charades [42],Kinetics [21]和ActivityNet Captions [22]包含各种各样的现实世界的例子,代表了复杂的人与物之间的相互作用,这些相互作用难以用最先进的视频理解方法进行建模[42]。 考虑图1中的示例。要准确预测篝火和煮蛋以及其他类似动作类的烹饪,需要了解细粒度的对象关系和交互。

图1.基于选定的相互关系逐步检测高阶对象交互。 具有相同颜色(加权r,g,b)的ROI指示存在对象间关系,例如, 鸡蛋放在同一个碗里,一只手打破鸡蛋,一碗放在篝火上(相同颜色的相互作用)。 然后,相互关系组共同模拟场景的高阶对象交互(不同颜色之间的交互)。 右图:ROI以其注意权重突出显示高阶交互。 该模型进一步推断了时间的相互作用,并预测在篝火和烹饪鸡蛋上烹饪。 图像由SINet生成(最好以彩色查看)。

例如,一只手打破一个鸡蛋,鸡蛋放在一个碗里,碗放在篝火上,篝火是在营地用木头建造的火等等。尽管最近采用最先进的行动识别方法已经证明相对于UCF101 [45],HMDB51 [23],Sports-1M [20],THUMOS [18],ActivityNet [5]和YouTube-8M [1]等数据集有显着改进,它们通常侧重于代表整体视觉场景(粗粒度)作为与时间池结合的输入序列,例如CRF,LSTM,1D卷积,注意力和NetVLAD [4,29,30,41],或者对整个视频序列使用3D卷积[6,37,46]。这些方法忽略了场景的细粒度细节,并且不推断视频中各种对象之间的交互。另一方面,在视频字幕任务中,尽管先前的方法使用空间或时间注意来选择性地在空间和时间上处理细粒度的视觉内容,但它们也不模拟对象交互。

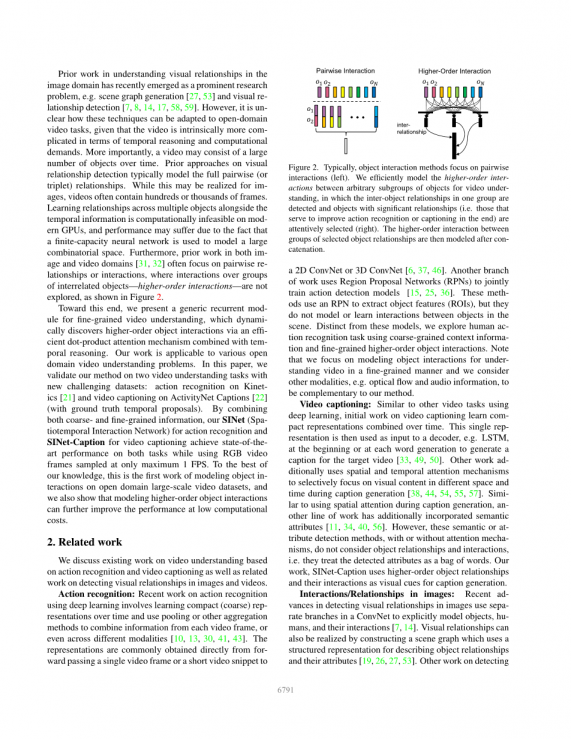

理解图像领域中的视觉关系的先前工作最近已成为一个突出的研究问题,例如,场景图生成[27,53]和视觉关系检测[7,8,14,17,58,59]。然而,目前尚不清楚这些技术如何适应开放域视频任务,因为视频在时间推理和计算需求方面本质上更复杂。更重要的是,视频可能包含随时间变化的大量相互关联的对象。关于视觉关系检测的现有方法通常模拟完整的成对(或三重)关系。虽然这可能是为了实现图像,但视频通常包含数百或数千个帧。在现代信息上学习多个对象旁边的关系在现代GPU上是不可行的,并且由于使用有限容量神经网络来模拟大的组合空间,性能可能会受到影响。此外,图像和视频领域的先前工作[31,32]通常关注成对关系或交互,其中不探讨相互关联对象组之间的相互作用 - 高阶交互 - 如图2所示。

图2.通常,对象交互方法关注成对交互(左)。 我们有效地模拟了用于视频理解的任意子组对象之间的高阶交互,其中检测到一组中的对象间关系和具有显着关系的对象(即用于改善动作识别或字幕的对象)。 精心挑选(右)。 然后,在连接之后对所选对象关系组之间的高阶交互进行建模。

为此,我们提出了一种用于细粒度视频理解的通用循环模块,它通过有效的点积注意机制与时间推理相结合,动态地发现高阶对象的相互作用。我们的工作适用于各种开放领域的视频理解问题。在本文中,我们使用新的具有挑战性的数据集验证了我们对两个视频理解任务的方法:对动力学[21]的动作识别和对ActivityNet Captions [22]的视频字幕(具有基本真实时间提议)。通过结合粗粒度和细粒度信息,我们用于动作识别的SINet(Spa-时空交互网络)和用于视频字幕的SINet-Caption在两个任务上实现了最先进的性能,同时使用仅采样的RGB视频帧最大1 FPS。据我们所知,这是开放域大规模视频数据集上对象交互建模的第一项工作,我们还表明,建模高阶对象交互可以以较低的计算成本进一步提高性能。

2、相关工作

我们讨论了基于动作识别和视频字幕的视频理解方面的现有工作,以及检测图像和视频中视觉关系的相关工作。

行动识别:最近使用深度学习进行行动识别的工作涉及随着时间的推移学习紧凑(粗略)表示,并使用汇集或其他聚合方法来组合来自每个视频帧的信息,甚至跨越不同的模式[10,13,30,41] ,43]。这些表示通常直接从单个视频帧或短视频片段传递到2D ConvNet或3D ConvNet [6,37,46]。另一个工作分支使用区域提议网络(RPN)来联合训练动作检测模型[15,25,36]。这些方法使用RPN来提取对象特征(ROI),但它们对场景中对象之间的交互不进行建模或学习。与这些模型不同,我们使用粗粒度上下文信息和细粒度高阶对象交互来探索人类行为识别任务。请注意,我们专注于以细粒度的方式为理解视频建模对象交互,并且我们考虑其他模态,例如:光流和音频信息,是我们方法的补充。

视频字幕:与使用深度学习的其他视频任务类似,视频字幕的初始工作可以学习随时间推移而结合的紧凑表示。然后将该单个表示用作解码器的输入,例如, LSTM,在开始时或在每个单词生成时生成目标视频的标题[33,49,50]。其他工作通常使用空间和时间注意机制在标题生成期间选择性地关注不同空间和时间的视觉内容[38,44,54,55,57]。类似于在字幕生成期间使用空间注意,另一项工作还包括语义属性[11,34,40,56]。然而,这些语义或属性检测方法,无论是否有注意机制,都不考虑对象关系和交互,即他们将检测到的属性视为一袋词。我们的工作,SINet-Caption使用高阶对象关系及其交互作为字幕生成的视觉提示。

图像中的相互作用/关系:检测图像中视觉关系的最新进展使用ConvNet中的单独分支来明确地模拟对象,人体及其相互作用[7,14]。视觉关系也可以通过构建场景图来实现,该场景图使用结构化表示来描述对象关系及其属性[19,26,27,53]。关于检测视觉关系的其他工作通过配对场景中的不同对象来探索关系[8,17,39,58]。 虽然这些模型可以成功地检测图像的视觉关系,但是具有许多对象的场景可能仅具有几个单独的交互对象。 检测所有单个对象对的所有关系是无效的[59],这使得这些方法对于视频域来说是难以处理的。

视频中的交互/关系:与图像域相比,探索视频理解关系的工作有限。 Ni等人[31]使用概率图形模型来跟踪交互,但他们的模型不足以模拟涉及多个对象的交互。为了解决这个问题,Ni等人[32]建议使用一组LSTM节点来递增地重新定义对象检测。相比之下,Lea等人[24]建议将输入图像分解为特征图中的若干空间单元,然后使用共享的ConvNets捕获对象位置,状态及其关系。然而,由于缺乏适当的数据集,现有的工作集中于室内或烹饪设置,其中人类主体连同被操纵的对象位于图像的中心。此外,这些方法仅处理对象之间的成对关系。然而,人类行为可能很复杂,并且通常涉及高阶对象交互。因此,我们建议专注地建模对象的相互关系,发现大型和开放域视频的高阶交互,以便进行细致的理解。

3、模型

尽管最近在视频理解方面取得了成功,但在以细微的方式理解视频中出现的关系和互动方面进展有限。 要做到这一点,方法必须不仅要了解高维度视频表示,但也能够显式建模场景中对象之间的关系和交互。 为此,我们建议在时空域中利用整体图像上下文(粗略)和高阶对象交互(fi)来进行一般视频理解任务。

在下一节中,我们首先描述SINet on action recognition,然后将其扩展到SINetCaption以进行视频字幕任务。

3.1 行动识别模型

3.1.1粗粒度图像上下文

最近的研究表明,使用LSTM聚合一系列图像表示通常会导致性能受限,因为图像表示可能彼此相似,因此缺乏时间差异[1,21,29]。 如图3所示,我们首先参加关键的图像级表示,通过Scale Dot-Product Attention(SDPAttention)[47]来概括整个视频序列:

(1)

(2)

其中是一组图像特征:是在时间t通过ConvNet编码的图像特征表示,并且t范围从 1,2,...,T为给定的视频长度。是带参数的多层感知器(MLP),是的最后一个完全连接(FC)层的维数, 是投影图像特征矩阵,是 比例因子和 是应用于(投影的)图像表示序列的注意权重。 然后将加权图像表示平均合并以形成视频表示。

图3.用于动作识别的SINet概述。 Coarsegrained:每个视频帧被编码为特征向量。 然后通过时间SDP-Attention将载体序列合并为单个载体表示。细粒度:从RPN获得的每个对象(ROI)在特征向量上编码。 我们使用提出的通用重复高阶交互(HOI)模块检测高阶对象交互。 最后,将粗粒度(图像上下文)和细粒度(高阶对象交互)信息组合起来执行动作预测。

3.1.2细粒度的高阶对象交互

传统的成对对象交互仅考虑每个对象如何与另一个对象交互。我们改为模拟对象的任意子组之间的相互关系,其成员由学习的注意机制决定,如图2所示。注意,这包括成对或三对的对象关系作为一种特殊情况,其中学习注意力只集中在一个单一的物体上。

问题陈述:我们将对象定义为场景中可能用于确定视觉关系和交互的特定区域。 每个对象表示可以直接从RPN获得并进一步编码为对象特征。请注意,我们不会将检测器中的对象类信息编码到特征表示中,因为存在跨域问题,并且我们可能会遗漏一些预训练对象检测器未检测到的对象。此外,我们不知道相应的对象随着时间的推移,因为对于长视频而言,将对象随时间链接可能在计算上是昂贵的。 因此,我们拥有可变长度的对象集,这些对象集驻留在跨越时间的高维空间中。 我们的目标是从时间上有效地检测来自这些丰富但无序的对象表示集的高阶交互。

在最简单的设置中,可以通过各个对象信息的求和操作来表示场景中的对象之间的交互。例如,一种方法是添加可学习的表示并将这些表示投影到高维空间中,其中可以通过简单地总结对象表示来利用对象交互。已经广泛用于图像的另一种方法是通过配对所有可能的候选对象(或主题 - 对象对)[7,8,17,39,58]。然而,这对于视频是不可行的,因为视频通常包含数百或数千帧,并且该对象 - 对象对太大而不能完全表示。逐帧检测对象关系在计算上是昂贵的,并且不使用对象交互的时间推理。

循环高阶交互(HOI):为了克服这些问题,我们提出了一个通用的循环模块,用于检测精细视频理解问题的高阶对象交互,如图4所示。建议的循环模块动态选择重要的候选对象区分人类行为。然后连接这些对象的组合以使用组到组或三组对象来模拟更高阶的交互。

图4.循环高阶交互模块通过可学习的注意机制动态选择具有检测到的对象间关系的组任意对象。 该关注选择模块使用整体图像上下文表示当前组(投影)对象和先前对象交互 ht-1来生成第选择的第权重 。 然后,通过串联和以下LSTM单元对所选对象组之间的高阶交互进行建模。

首先,我们通过MLP投影引入传入对象特征的可学习参数,因为对象特征是从另一个域预训练的,并且可能不一定呈现对动作识别的交互。 然后将投影的对象特征与整体图像内容和先前的对象交互组合以生成K组权重以选择K组对象1.具有相互关系的对象从注意权重中选择,其产生所有候选对象的概率分布。使用来自当前(投影)对象特征,整体图像视觉表示和先前发现的对象交互(参见图4)的输入来计算注意力,其提供具有最大上下文的注意机制。

(3)

其中输入是一组对象:时间的第个对象特征表示。 是具有参数 的MLP,参数是在和时间上在所有对象上共享的可学习的突触权重。 表示当前时间的编码图像特征,并且是LSTM单元的前向输出,其表示之前发现的对象交互。形式上,给定输入序列,LSTM网络计算隐藏的矢量序列。最后,是从提出的注意力模块计算的注意力权重。

图5.注意模块:Dot-product attention和-attention。 两个关注机制都从整个图像表示,当前对象集合以及在时间从LSTM单元计算的先前对象交互获取输入。

Attentive selection module:这里我们讨论注意模块的两种可能选择,如图5所示。Dot-product attention在选择对象时考虑相互关系,而-attention则不考虑。

Dot-product attention:为