英语原文共 4 页,剩余内容已隐藏,支付完成后下载完整资料

自动压缩编码和SVM实现识别手写梵文数字

Ruhi R. Kabra

计算机科学与工程学系

MATSYODARI SHIKSHAN SANSTHA

工程技术学院

加纳,印度

摘要--在机器学习中,数据的表示是非常重要的。更好的表示,分类器会给出更好的结果,压缩自动编码器是用来学习数据的表示的,它能够实现有效的低通滤波。本文使用了压缩自动编码器和SVM分类器实现手写的梵文数字识别,使用自动压缩编码和SVM可以使准确率达到96%。

关键词—自动压缩编码,SVM, 手写数字识别

- 简介

手写字符识别是数字化过程的重要组成部分,因为每个人都有不同的写作风格,所以这是一项具有挑战性的任务。很多研究人员都对印度手写数字和字符笔迹识别做出了贡献,比如梵文,泰米尔语,孟加拉语,坎纳达语等等。梵文字符被用来书写印度语言,如印地语,马拉语,梵语等。在文献调查中发现,大部分的字符识别系统都使用特征提取方法,提取的特征被分类器用于创建模型。

R.Jayadevan等人,最近对离线的梵文笔记识别进行了研究。他们讨论了研究人员使用的统计方法和结构特征提取方法。他们还讨论了各种分类器,如隐马尔可夫模型,支持向量机,模糊模型,MQDF等。论文2,3,4,5,6讨论了手写的梵文数字识别使用特征提取和分类。

理想情况下,机器应该学习特性本身。深度学习是建立在一套算法的基础上用于监督或非监督的特征学习。这些算法用于学习更好的数据表示。最近的工作展示了使用深层架构来实现离线字符识别。Vijayraghavan和Mishra使用卷积神经网络来表达泰米尔字符识别。Arghya Pal等人,他们在iwfhr10数据集上获得了94.4%的准确率,并且使用深度自动编码器开发了在线孟加拉数字识别系统。使用HMM DA SVM的混合系统的准确率成绩为99.18%。Ashok Kumar Pant等人开发了一个新的梵文字符数据集,有92000个图像和46个类。他们使用深度卷积网络,获得了98.47%的准确率。Sagar Dewan和shriniis Chakraborty实现了对泰卢固语字符脱机识别的堆叠自动编码器。堆叠式自动编码器在不受监督的情况下,以贪婪的方式训练。他们的辅音的准确率为95.4%,元音为94.8%。

自动编码器是试图学习一个恒等函数的深层架构。本文讨论了自动编码器在手写体脱机系统中的应用。将原始图像像素作为输入,用于自动编码器的变体学习有效的表示。这里使用收缩自动编码器获得一个超完整的表示。对SVM分类器进行了描述,并对测试数据进行了性能评价。

- 自动编码

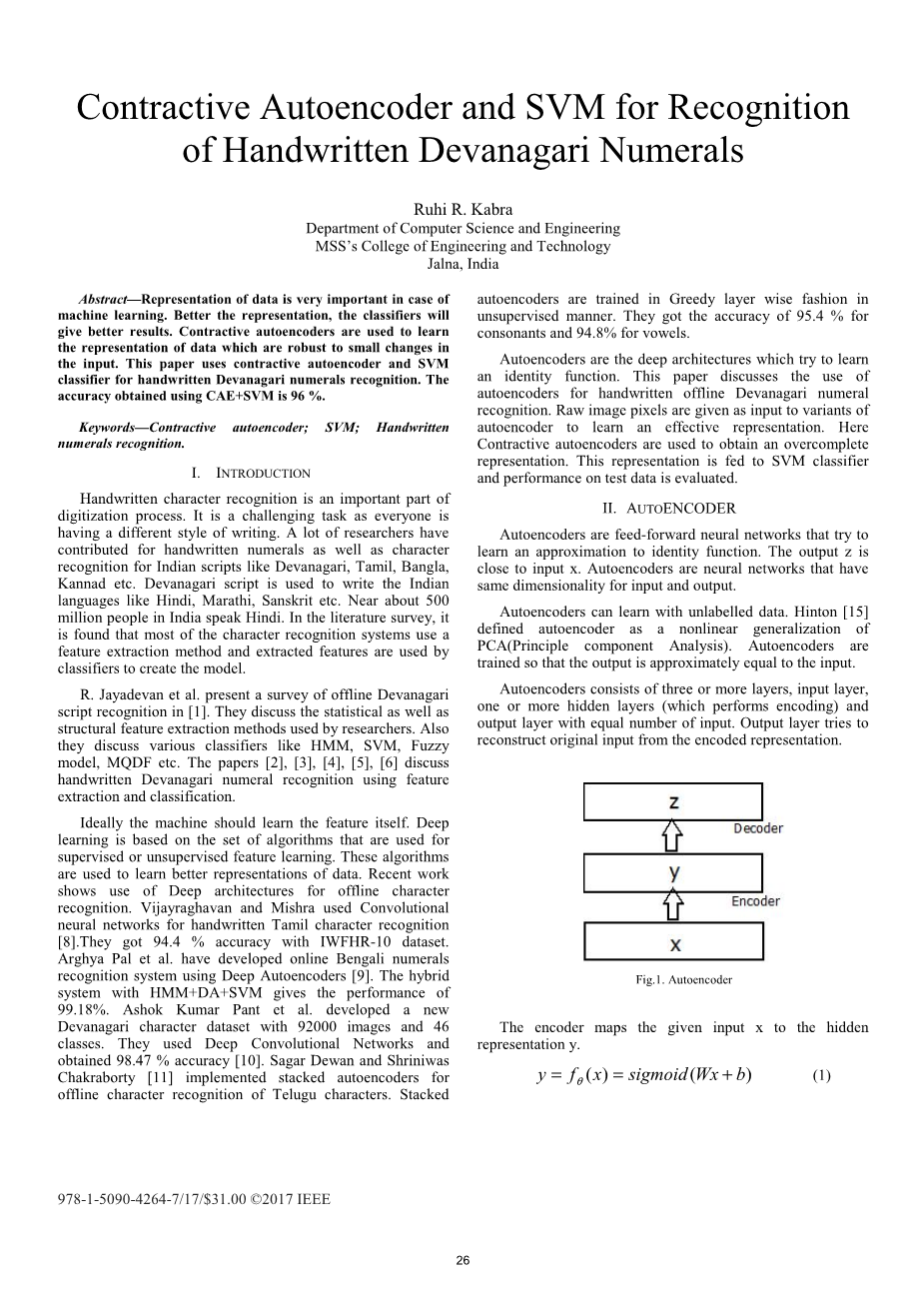

自动编码器是一种前馈神经网络,试图学习近似于恒等函数。输出z接近于输入x。自动编码器是具有相同的输入和输出维数的神经网络。

自动编码器可以学习无标记的数据。Hinton将自动编码器定义为PCA的非线性推广(主成分分析)。自动编码器经过训练,使输出近似等于输入。自动编码器包括三个或多个层,输入层,一个或多个隐藏层(执行编码)和输出层,输入数量相等。输出层试图从编码的表示中重建原始输入。

图1 自动编码器

编码器将给定的输入x映射到隐藏的表达y。

其参数组是theta;= { W, b },其中W是一个权重矩阵和b是一个偏移向量。

通常使用的激活函数是sigmoid。

译码器将隐藏的表示映射到向量z,比如。该映射被称为具有适当参数尺寸的解码器theta;#39; = {Wʹ, bʹ}。

一般来说,z不能被解释为x的精确重构,但是参数可以产生高概率的x。

调整参数,使重构损失最小。L被表示为平方误差损失或交叉熵损失。本文所使用的交叉熵损失表示为

不同的约束应用于自动编码器的架构提供了不同的变体。如果隐藏单元的数量小于输入单元,则自动编码器提供数据的压缩表示。能够表示相同输入的更少的特征被识别出来。

另一方面,如果我们允许隐藏的单位大于输入单元,我们就会得到数据的稀疏表示。稀疏的自动编码器使得很少的神经元活跃(输出接近1),而大多数的神经元是不活跃的(输出接近0)。因此,重构这些被获得的数据的特征是重要的。

使用堆积的自动编码器,多重自动编码器被用来形成多层的层次结构。在每个级别上提取更高级别的特性。最高层的输出层保持不变,但在中等水平下,在预训练后,输出层被移除。贪婪层明智的预训练是在将提取的特征(编码表示)作为输入输入到下一个自动编码器。采用梯度下降法对权重进行优化。

一个去噪的自动编码器(DAE)是经过训练的,它可以从多噪的版本中重建一个纯净的输入。这是一个将初始输入x转化到xn加入一些噪声来完成的过程。这个方法由Vincent提出,以捕获在噪声输入情况下稳定的表示。

- 自动压缩编码:

Rifai等提出的收缩自动编码器,试图找到更可靠的数据表示形式。在自动编码器的经典重构成本函数中加入了一个惩罚项。这个惩罚项帮助从输入中提取的特征在训练示例周围的输入中变得更加稳定。得到了可用于分类器以获得更好的精度的输入的超完整表示。在重构成本中加入的惩罚项是关于输入值的隐含层的雅可比矩阵的Frobenius规范。新的损失函数与收缩速度lambda;

- SVM

由Vapnik引入的SVM是一种机器学习算法,大部分时间用于分类。在这里,样本是由n维空间中的点表示的,算法试图找到最能区分两个给定类的超平面。右超平面是具有最高边缘的(两个类中的数据点的距离)。SVM可以使用内核技巧进行线性和非线性分类。内核函数用于将输入映射到高维特征空间。常用的核是多项式和径向基核。

基本上,SVM是两个类分类器。SVM可以用两种方式用于多类分类,1对多和1对1。在1对多的情况下,每个方法都选择了样本具有最高边际的类。在1对1,大多数分类器选择的类是样本的类。

- 实现详情

- 数据集:

手写的梵文数字数据来自印度统计研究所-Kolkatta。该数据集有18794个梵文数字样本,在训练集和测试集的3760个样本中,分别代表0到9级。数据集有不同分辨率的灰度图像。这些图像在38*38矩阵中归一化。采取了一些预处理步骤。像素强度在0到255之间,在0到1之间是标准化的。使用阈值方法将图像转换为二进制形式。

图2 梵文数字数据

- 模型生成器和分类器

预处理后的图像被加载到numpy数组中。自动编码器是使用Python和Theano库实现的。Theano是一个用于开发深层架构的python库。模型可以在GPU上进行训练。

在这里,通过应用自动编码器(AE)和压缩自动编码器(CAE)算法对训练数据进行数据表示。验证数据用于超参数调优。压缩自动编码器选择的超参数是隐藏层= 3000,学习速率= 0.01,迭代次数= 20。对于压缩自动编码,收缩速率= 0.1。支持向量机与径向基内核用于训练模型C = 10和gamma;= 0.005。LIBSVM工具被用于实现SVM。

- 结果

自动编码器使用随机梯度下降算法进行训练,使重建损失最小。由于压缩自动编码器的存在,由于在压缩自动编码器的情况下产生了输入的鲁棒表达。由自动编码器生成的训练数据的表示,SVM分类器来创建模型。模型的性能是根据测试数据进行的。自动编码器变量和支持向量机的测试数据的准确性如表1所示。

表1 .自动编码器变量 SVM对支持向量机的结果

|

算法 |

准确率 |

|

SVM |

94% |

|

AE SVM |

95% |

|

CAE SVM |

96% |

结果表明,当直接应用于训练数据时,SVM模型与rbf核函数模型的准确率达到94%。但当支持向量机应用于自编码器输出的数据表示时,会得到更好的结果。CAE SVM的最佳结果是96%的准确性。收缩自动编码器捕捉特征的变化,但其他方向是收缩的。CAE SVM的混淆矩阵如表2所示。它显示了带有标签4的类最正确地分类为99.7%的精度。最不准确的是,第3类是85.6%。另一个性能指标是精确和召回。图3a和图3b中所示的类的精确性和召回值百分比如图3所示。

表2.CAE SVM的融合矩阵

|

类别 |

0 |

1 |

2 |

3 |

4 |

5 |

6 |

7 |

8 |

9 |

|

0 |

357 |

1 |

1 |

1 |

0 |

2 |

2 |

5 |

0 |

0 |

|

1 |

0 |

355 |

2 |

6 |

1 |

8 |

0 |

0 |

1 |

5 |

|

2 |

0 |

0 |

365 |

4 |

4 |

1 |

0 |

0 |

0 |

4 |

|

3 |

0 |

0 |

45 |

321 |

9 |

0 |

1 |

0 |

0 |

1 |

|

4 |

0 |

0 |

0 |

0 |

374 |

0 |

1 |

0 |

0 |

0 |

|

5 |

0 |

0 |

10 |

17 |

21 |

330 |

0 |

0 |

0 |

0 |

|

6 |

0 |

0 |

1 |

1 |

0 |

0 |

371 |

0 |

0 |

1 |

|

7 |

0 |

0 |

1 |

0 |

2 |

1 |

4 |

369 |

0 |

1 |

|

8 |

0 |

0 |

2 |

1 |

3 |

1 |

0 |

0 |

370 |

0 |

|

9 |

2 |

0 |

2 |

1 |

0 |

1 |

10 lt;全文共3969字,剩余内容已隐藏,支付完成后下载完整资料 资料编号:[13067],资料为PDF文档或Word文档,PDF文档可免费转换为Word |