英语原文共 9 页,剩余内容已隐藏,支付完成后下载完整资料

基于深度内部学习的“Zero-Shot”超分辨率重建算法

Assaf Shocherlowast; Nadav Cohendagger; Michal Iranilowast;

摘要

在过去的几年中,深度学习在超分辨率(SR)性能方面带来了巨大的飞跃。然而在监督下,这些SR方法被限制在特定的训练数据中,从其高分辨率(HR)对应对象中获取低分辨率(LR)图像是预先确定的(例如,双三次降尺度),没有任何分散的工件(例如,传感器噪声、图像压缩、非理想PSF等)。然而,真实的LR图像很少遵守这些限制,导致SotA(最先进的)方法的SR结果很差。在本文中,我们介绍“Zero-Shot”SR,利用深度学习的力量,但不依赖于之前的训练。我们利用单个图像内信息的内部递归,并在测试时训练一个小的特定于图像的CNN,仅从输入图像本身提取样本。因此,它可以适应每个图像的不同设置。这允许对真实的老照片、有噪声的图像、生物数据和其他采集过程未知或不理想的图像进行SR。在这样的图像上,我们的方法优于基于SotA CNN的SR方法,以及以前的无监督的SR方法。据我们所知,这是第一种基于CNN的无监督SR方法。

1.引言

最近,使用基于深度学习的方法[3,9,8,11,12],单幅图像的超分辨率(SR)的性能得到了巨大的提升。最近的SotA(最先进的)方法[12]超过了以前的非深度SR方法(有监督的[21]或无监督的[4,5,6])的一些dBs -一个巨大的差距!这种性能提升是通过深度和精心设计的CNN获得的,这些CNN在外部数据库上经过了长时间(几天或几周)的详尽训练。

然而,尽管这些外部监督的方法在满足训练条件的数据上表现得非常好,但一旦这些条件不满足,它们的性能就会显著下降。例如,SRCNN通常训练有素的高质量的自然图像,从低分辨率(LR)图像生成与

特定的预定义的缩小内核(通常是一个双三次的内核与抗锯齿MATLAB的默认imresize命令),没有任何令人分心的工件(传感器噪声、非理想PSF、图像压缩等),和一个预定义的SR比例因子(通常times;2times;3times;4;假设两个维度相等)。图2显示了当这些条件不满足时会发生什么,例如,当LR图像是用非理想(非双三次)降尺度核生成的,或包含混叠效果,或仅仅包含传感器噪声或压缩伪影。图1进一步表明,这些都不是人为设计的情况,而是在处理真实LR图像时经常发生的情况——从互联网上下载的图像,用iPhone拍摄的图像,旧的历史图像等。在那些“非理想”的情况下,SotA SR方法往往产生较差的结果。

在本文中,我们介绍“Zero-Shot SR (ZSSR),利用深度学习的力量,而不依赖任何先验图像例子或前培训。我们利用单个图像中信息的内部递归,并在测试时间训练一个小的特定于图像的CNN,仅针对LR输入图像本身提取的例子(即内部监督)。因此,CNN可以适应每个图像的不同设置。这允许在获取过程未知和非理想的真实图像上执行SR(参见图1和图2中的示例结果)。在“非理想”图像上,我们的方法比外部训练的SotA SR方法有很大的优势。

在单个图像的尺度上,小块信息(如小图像补丁)的重复出现被证明是自然图像的一个非常强的特性[4,23]。这形成了许多无监督图像增强方法的基础,包括无监督SR(4、5、6),Blind-SR[14](当降尺度内核是未知的),Blind-Deblurring [15, 1], Blind-Dehazing[2],等等。虽然这种无监督的方法可以利用图像特定

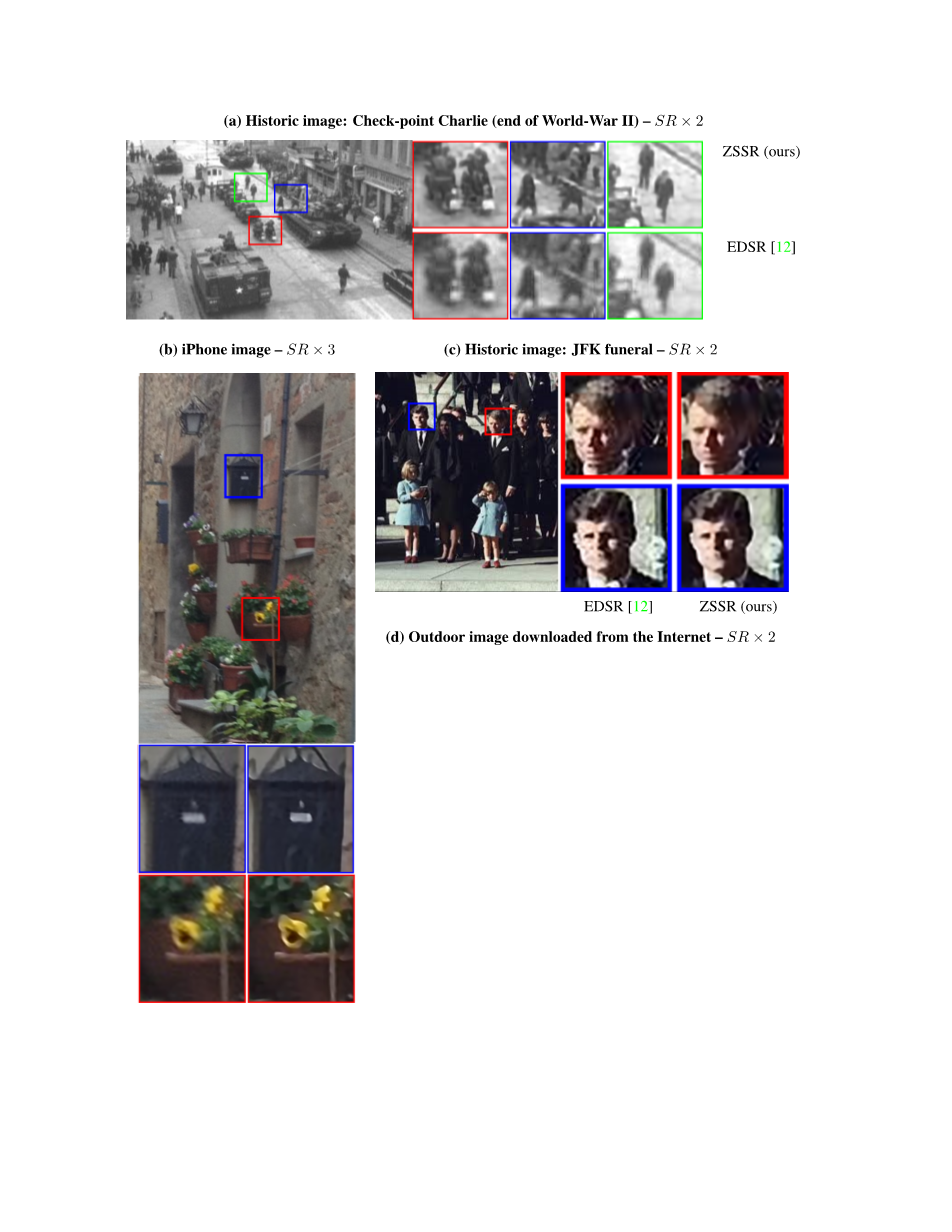

- 历史照片:查理检查站(二战结束) – SR times; 2

ZSSR

EDSR

- iPhone照片 – SR times; 3 (c) 历史照片:肯尼迪的葬礼 – SR times; 2

EDSR [12] ZSSR (ours) EDSR [12] ZSSR (ours)

图 1 真实图像的SR(未知LR采集过程) 现实世界的图像很少服从监督SR方法假设的“理想条件”。例如,有历史意义的老照片(a, c),智能手机拍摄的照片(b),互联网上的随机图片(d)等。由于ZSSR在测试时间对从测试图像中提取的示例进行训练,它在“野外”(即不受约束和未知的设置)中执行SR的性能更好。完整尺寸的图片可以在我们的项目网站上找到。

- 在混叠下的SR:

Ground truth EDSR [12] ZSSR (ours)

(PSNR /SSIM) (21.64 / 0.6641) (25.02 / 0.7658)

- 在未知非理想降尺度核下的SR:

Ground truth EDSR [12] ZSSR (ours)

(PSNR /SSIM) (24.44 / 0.7006) (27.62 / 0.8367)

图 2“非理想”LR图像的SR --一个对照实验。(a)用混叠生成的LR图像(降尺度核是一个delta函数)。(b)非理想降尺度核生成的LR图像。未知的图像特定的核直接从LR测试图像使用[14]估计,并插入我们的图像特定的CNN作为降尺度核。(注意,外部训练的网络在测试时不能使用这些图像特定的信息)。完整尺寸的图片可以在我们的项目网站上找到。对数百张“非理想”LR图像的定量评价可在第4.2节中找到。

的信息(因此较少受到上述有监督的限制),但它们通常依赖于预定义大小(通常为5times;5)的小图像块的简单欧几里得相似性,使用最近邻搜索。因此,它们不能很好地泛化到LR图像中不存在的补丁,也不能很好地泛化到新的隐式学习相似度量,也不能适应图像中重复结构的非均匀大小。

我们的图像特定CNN利用了图像特定信息的跨尺度内部递归的力量,而不受上述基于补丁的方法的限制。我们训练一个CNN,从LR图像及其缩小版本(自我监督)推断复杂的图像特定的HR-LR关系。然后,我们将这些学习到的关系应用到LR输入图像上,以产生HR输出。这大大优于无监督的基于补丁的SR。

由于单个图像内部的视觉熵要比一般外部图像集合[23]的视觉熵小得多,一个小而简单的CNN就足以完成这个特定于图像的任务。因此,即使我们的网络在测试时进行训练,其训练 测试运行时间与SotA监督的CNN测试运行时间相当。有趣的是,我们的图像特定的CNN在SotA监督方法(即使我们的CNN很小,没有经过预先训练)使用的“理想”基准数据集上产生了令人印象深刻的结果(尽管不是SotA),并在“非理想”图像上大大超过了SotA监督的SR。我们提供了这些陈述的视觉和经验证据。

这里使用的术语“Zero-Shot”,是从识别/分类领域借用的。但是请注意,与这些零次学习[22]或一次学习[18]的方法不同,我们的方法不需要任何边信息/属性或任何额外的图像。我们手上可能只有一幅测试图像,独一无二,仅此而已。然而,当有额外的信息并提供时(例如,使用[14]可以直接从测试图像中估计降尺度内核),我们的图像专用CNN在测试时可以很好地利用这一点,进一步提高结果。

因此,我们的贡献是多方面的:

(i)据我们所知,这是第一个基于CNN的无监督SR方法。

(ii)它可以处理非理想的成像条件,以及各种各样的图像和数据类型(即使是第一次遇到)

图 3特定图像信息的内部预测能力。简单的无监督的内部SR[4]能够重构小阳台上的小扶手,而外部训练的SotA SR方法则不能做到这一点。这些小扶手存在的证据只存在于内部,在这幅图像中,在不同的位置和规模(在一个较大的阳台上)。这样的证据在任何外部图像数据库中都找不到(不管它有多大)。

(iii)它不需要预先训练,并且可以在有限的计算资源下运行。

(iv)它可以适用于任何尺寸的SR,理论上也可以适用于任何宽高比。

(v)它可以适应已知和未知的成像条件(在测试时间)。

(vi)它提供在“非理想”条件下拍摄的图像的SotA SR结果,以及SotA监督方法受训的“理想”条件下的竞争性结果。

2.图像内部数据的力量

我们方法的基础是,自然图像有很强的内部数据重复。例如,小图像补丁(例如:5times;5, 7times;7)会在单个图像中重复多次,无论是在相同的尺度内,还是在不同的图像尺度上。这一观察结果通过使用数百张自然图像得到了经验验证[4,23],并且在几乎任何自然图像中的几乎任何小块都被证明是真实的。

图3显示了一个基于内部补丁递归的简单图像SR示例(由[4]提供)。它能够恢复小阳台上的小扶手,因为在这幅图像的其他地方,在一个较大的阳台上发现了它们存在的证据。事实上,唯一能证明这些小扶手存在的证据就在这幅画的内部,在不同的位置,不同的尺度。它不能在任何实例的外部数据库中找到,无论这个数据集有多大!可以看出,SotA SR方法依靠外部训练的图像无法恢复该图像的具体信息。虽然这里使用“形分形”图像证明了强大的内部预测能力,但对几乎所有自然图像[4]的内部预测能力进行了分析,并显示出其强大。

事实上,[23]的经验表明,单幅图像内修补的内部熵远远小于一般自然图像集合中修补的外部熵。这进一步引起了一种观察,即内部图像统计通常比从一般图像集合中获得的外部统计拥有更强的预测能力。在不确定性增加和图像退化的情况下,这种倾向尤其强烈(详见[23,16])。

3.特定图像的CNN

我们的图像特定CNN结合了内部图像特定信息的预测能力和低熵,以及深度学习的泛化能力。给定一幅测试图像I,没有可供训练的外部例子,我们构建一个针对这幅特定图像的CNN来解决该特定图像的SR任务。我们用从测试图像中提取的例子训练我们的CNN。这样的例子是通过对LR图像I进行缩小来生成其分辨率更低的版本,Idarr;s(其中s是期望的SR比例因子)。我们使用一个相对较轻的CNN,训练它从其低分辨率版本Idarr;s(图4(b)顶部)重建测试图像I。然后,我们将得到的训练好的CNN应用到测试图像I,现在使用I作为网络的LR输入,以便构建所需的HR输出Iuarr;s(图4(b)底部)。注意,经过训练的CNN是完全卷积的,因此可以应用于不同大小的图像。

由于我们的“训练集”只包含一个实例(测试图像),我们对I使用数据增强来提取更多的LR-HR样本对来进行训练。增强是通过将测试图像I缩小为其本身的许多小版本(I = I0, I1, I2,hellip;,)。它们

起到了监督SR的作用,被称为“HR父结点”。然后,每个HR父结点被期望的SR比例因子缩小,以获得“LR子结点”,形成输入训练实例。得到的训练集包含许多特定于图像的LR-HR示例对。然后网络就可以在这些对上随机训练。

我们进一步丰富了训练集,通过使用4个旋转(0°,90°,180°,270°)以及它们的镜面在垂直和水平方向上的反射。这增加了8倍的图像特定训练示例。

为了增强稳定性,以及即使在非常小的LR图像中也允许大的SR尺度因子,SR是逐步进行的[4,20]。我们的算法应用于几个中间尺度因子(s1, s2,hellip;)在每个中等尺度的si,我们将生成的SR图像HRi及其缩小/旋转版本添加到我们逐渐增长的训练集中,作为新的HR父结点。我们通过下一个渐进的尺度因子si 1缩小这些(以及先前较小的“HR样本”),以生成新的LR-HR训练样本对。这样重复,直到达到所需的分辨率增加。

3.1架构和优化

图 4 特定图像CNN -“Zero-Shot” SR. (a)外部监督的SR CNN是在大型外部图像数据库上预先训练的。然后将得到的非常深的网络应用于测试图像I。(b)我们提出的方法(ZSSR):在测试图像本身内部提取的例子上训练一个小的图像特定的CNN。它学习如何从较粗的分辨率恢复测试图像I。然后,将产生的自我监督网络应用到LR图像I,产生其HR输出。

受监督的CNN是根据大量多样的LR-HR图像样本外部集合进行训练的,必须在其学习的权重中捕捉所有可能的LR-HR关系的巨大多样性。因此,这些网络往往是非常深入和非常复杂的。相比之下,单个图像中LR-HR关系的多样性要小得多,因此可以通过一个更小、更简单的特定于图像的网络进行编码。

我们使用了一个简单的、完全卷积的网络,有8个隐藏层,每个层有64个通道。我们在每一层使用ReLU激活。网络输入被插值到输出大小。正如之前基于CNN的SR方法[9,8,3]所做的那样,我们只了解嵌入的LR和它的HR父结点之间的残差。我们使用L1损失与ADAM优化[10]。我们从0。001的学习速率开始。我们周期性地对重构误差进行线性拟合如果标准偏差比线性拟合的斜率大一个因子我们将学习率除以10。当学习速率达到10-6时,我们就停止。

为了加速训练阶段,并使运行时间独立于测试图像I的大小,在每次迭代时,我们从随机选择的父子示例对中取一个固定大小的随机作物。作物通常是128times;128(除非采样的图像对更小)。在每次训练迭代中,采样一个LR-HR样本对的概率被设置为非均匀的,并且与HR-father的大小成正比。尺寸比(HR-father与测试图像I之间的比例)越接近1,其被采样的概率就越高。这反映了非合成HR样本比合成HR样本具有更高

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[258295],资料为PDF文档或Word文档,PDF文档可免费转换为Word