英语原文共 7 页,剩余内容已隐藏,支付完成后下载完整资料

附录A 外文译文

改进的立体视觉深度图估计

Hajer Fradi and and Jean-Luc Dugelay

EURECOM, Sophia Antipolis, France

摘 要

在这篇文章中,我们展现了一种新方法,主要以观察到的场景的深度图还原为参照的稠密立体匹配,尽管有些问题还是无法得以解决,但视差图的深度信息的提取是简单易行的。在我们的方法中,我们提出了通过检测并剔除误匹配点的相关技术,这种情况通常发生在一些有难度的图像中,如无特定结构,遮挡以及不连续区域内。缺失部分将通过边缘检测来避免出现一个窗口包含多个物体。这是一种有效的方法,以自适应形状选择可变窗口大小以此来获得准确结果,在深度不连续,均匀区域内保持一个低复杂度系统中,利用米德尔伯里数据集的实验结果,证明了我们提出的方法的有效性,研究主要适用范围是移动设备环境下的新功能设计。

关键词:立体视觉,视差图,匹配,遮挡,通信,边缘

1.简介

研究人员一直对立体视觉系统能够准确感知所观察到的的场景的深度信息这一方面给予特别重视,大多数立体视觉的实现基于两个面向前方的摄像头,其中每个摄像头提供一个场景的二维投影,在立体匹配中所遇到的主要困难是确定每两个对应像素间的空间距离。这个过程被称之为对应的问题,目的是评估视差图中的每组参考图像中的像素对应的视差值。

近几十年来,我们深入研究以此来解决左右图像之间的对应问题。更多的细节表明,一种很好的密集两帧立体匹配算法已经被找到。一般情况下,立体匹配算法可以分为两大类:部分方法和整体方法。整体方法在能量函数方面提出了一个优化问题,然后所有的差异部分同时采用能量最小化技术。整体方法通常可以实现高精度匹配,比如图像分割,动态编程和深度传播。然而大部分方法计算昂贵。

与这些方法相比,本文的方法有更高的效率并且更适用于实时应用,为使视差图更加平滑,所采用的相关方法是利用有限窗口内的色彩或强度值,这些方法已被广泛采用,其中成本函数也是被列入窗口像素考虑范围的方面。基于相关性的方法大多数都是失败的,因为他们是在基于相似性和约束性的基础上,假设相应点的强度是相似的,严格意义上来说,在光照和对比度方面,变化并不是特别明显。同时,在遮挡和不连续区域这一环境下,这些方法不能解决图像的一部分被另一图像遮挡的问题。再者,由于这些区域的水平变化非常的低,对于低纹理区域和重复模式的像素,很难进行适当的匹配。

不仅如此,另一个重要技术问题在于选择合适的窗口大小:大窗口增加了平面面积,也增加了噪声的影响。然而,使用大窗口可能造成物体边界模糊。另一方面,如果窗口很小,强度变化就不明显,且无法给予详细的视差估计。因此,窗口由小到大,视差边界的准确性也在发生变化,视差边界变得模糊。一般来说,相关窗口的大小选择要考虑低纹理区域,可靠性增加和边界模糊效果降低方面问题。除此之外,采用局部支持窗口来减少图像歧义的方法,其隐含假设了所有像素都来自于场景里的相似深度并且它们有相似视差。问题是这个假设并不是总是有效的,因为位于不连续深度的支持窗口里的像素来自不同深度。

除了这些问题之外,大多数方法都使用一个固定大小的矩形窗口,这可能会导致坏的性能和错误的结果。因此,早期的研究人员试图通过图像窗口变化来克服这些限制,大多数这些方法总结出窗口不同尺寸大小取决于强度的局部变化,但他们仍然将窗口限制为矩形形状。然而很少有关于窗口尺寸不同方面的研究。

这些基于相关性的方法留下的含糊之处使得匹配过程更加具有挑战性,准确的视差恢复仍然需要妥善处理。因此,在本文中,我们在相关性和处理误匹配点问题的显示进展的基础上提出了一种新的稠密立体匹配算法。这是一个三步的框架;第一步,使用适当的成本匹配,以避免因为不满足相似约束而造成模糊匹配这一缺点。第二步,双向匹配用于检测遮挡和剔除误匹配。只有在返回(如从右到左再到右)的最终位置和初始位置相同的时候,匹配才是有效的。第三步,在这个阶段创建的孔将通过边缘检测这一方式填充,以此获得完全视差图,其可通过简单的三角剖分转换成深度图。

本文的其余部分组织如下:第2节详细介绍了所提出的立体匹配方法的发展。深度信息的提取在第3节中描述。第4节显示的实验结果证明我们的方法的有效性和鲁棒性。最后,我们在第5节给出一个简短的结论。

- 立体匹配方法

立体匹配的方法采用基于相关的技术来估计视差图上的立体对,它是在三个连续的步骤中进行的:

2.1 第一步:寻找匹配参考点

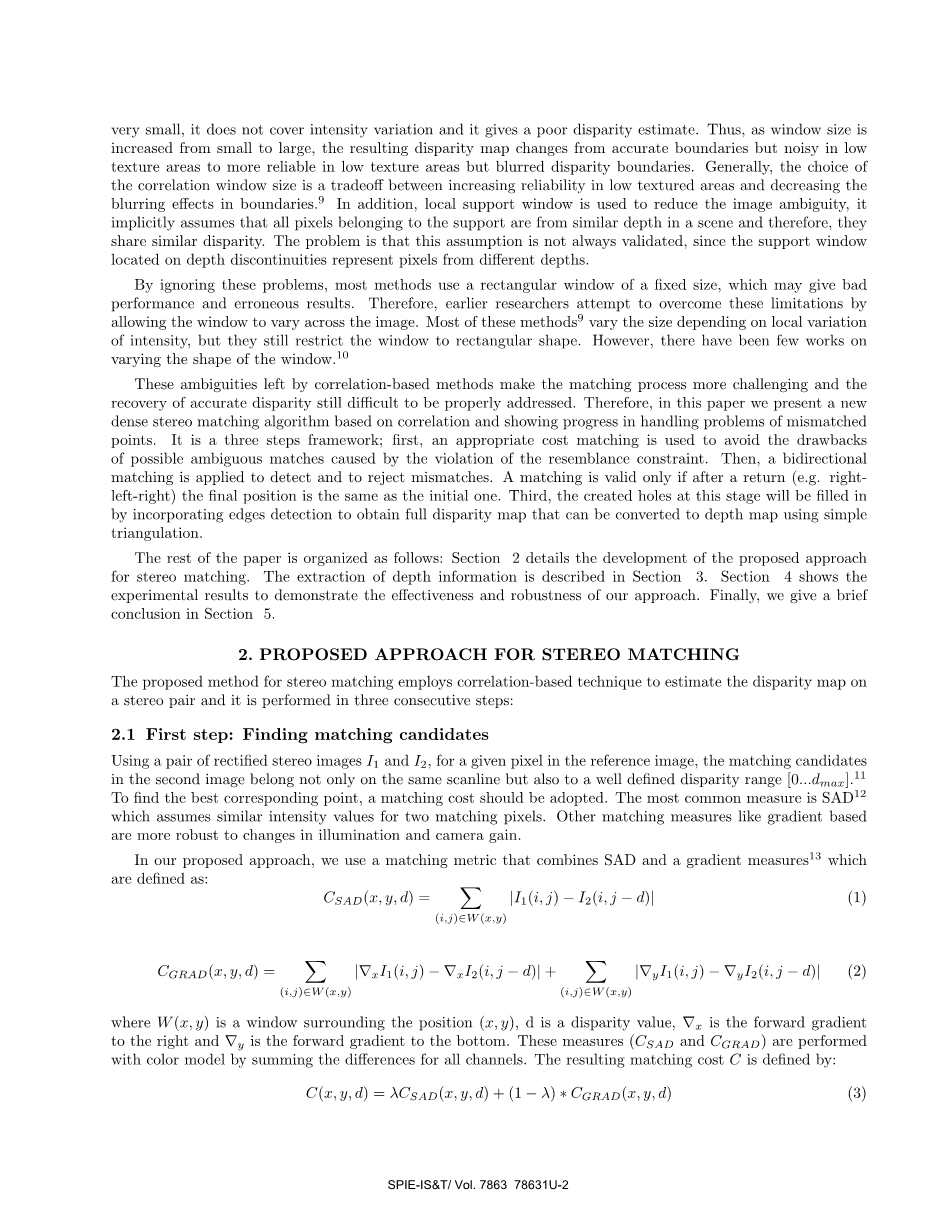

以立体图像对I1和I2为例,对于一个给定的参考图像中的像素,在第二幅图像的匹配的参考点不仅要在同一扫描线上,也要在一个定义好的视差范围内[0...dmax]。为了找到最佳的对应点,我们需要考虑成本匹配。最常见的采取措施是SAD,即两个匹配像素具有相似的强度值。还有其他的匹配措施,例如以梯度为基础的,其在照度和亮度方面增益有很大的变化。

在我们所提出的方法中,我们使用一个将SAD和梯度联系起来的匹配度量,其被定义如下:

(1)

(2)

其中w(x,y)是关于窗口位置(x,y)函数,D是视差值,nabla;X是右前向梯度,nabla;Y底部向前梯度。这些方法(CSAD和CGRAD)通过所有不同通道的颜色模型来进行。由此产生的成本匹配函数c定义为:

(3)

其中lambda;是重量参数,最大限度地选择可靠对应的数目。因此,对于左边图像中的每个相关的像素,周围的像素块从右图像滑过一行,并且在每个位置计算函数C,所选视差值对应最小匹配成本它是由此得到:

(4)

2.2第二步:剔除误匹配

上述问题的存在表明,匹配问题还没有得到解决。因此,在估计图像中的每个像素的视差后,这一步是要通过剔除误匹配的点来保持可靠点的视差。这是同时来检测遮挡和低纹理区域的方法,因为误匹配点几乎都出现在这样的部分。

2.2.1 双向匹配

处理遮挡和低纹理区域的第一个方法是双向匹配;它不像其他大多数的立体匹配算法那样,以左图像作为参考,计算视差图,双向匹配是对于每个图像创建两个视差图。它包括两部分:一次以左图像作为参考,一次以右图像作为参考。然后,我们比较两个视差图以此来剔除误匹配。如图1所示,产生两视差图disp1和disp2后,过程如下:

图1.双向匹配

我们建立了第二幅图像素(i,j)和第一幅图像素(i,j disp2(i,j))的第一个联系。然后,利用第一图的位置(i,j disp2(i,j)),得到视差值disp1(i,j disp2(i,j))。建立第一幅图像像素(I,J disp2(i,j))和第二幅图像像素(i,j disp2(I,J)minus;disp1(i,j disp2(i,j)))第二个联系。我们定义了E为:

(5)

当E(i,j)等于零,我们从右手边的图像点到左手边图像的另一点,我们回到右边的图像达到初始点。这意味着我们用左或右图像作为参考建立了相同的匹配。

总之,双向匹配是一种典型的检测遮挡和低纹理区域的方法。出于同样的目的,我们也提出了一系列约束规则。

2.2.2约束

我们建议采用传统的匹配假设,以便能够加强给定的匹配的可信度,并减少误匹配的数目。

这些约束条件是:

- 唯一约束:每个点只能连接到最多其他图像的一个点。但在对象是透明的情况下,该约束是不成立的。

- 序列约束:第二个约束是关于排序的,它能够成功地检测出遮挡情况。这个附加假设是如果对象O1出现在左图像对象O2的左边,那么对象O1也将出现在右图对象O2左边。

- 连续性约束:这个假设指出,视差值是几乎都是连续。这意味着相邻点必须具有一致的匹配值。在大多数情况下,连续性假设是有效的,因为物理表面被公认为是光滑的。但是,在边缘情况下这个假设是不成立的。

2.3第三步:视差图的补充

在上述步骤执行后,我们有输入产生的视差图和已知的缺失值。我们的任务是完成缺失数据的问题。为了实现这一目标,最简单的解决方案是使用低通滤波器。但是,我们解决问题的选择有多种。我们的想法是保持已知视差的相同值,并给缺失值以平滑值。由于我们一开始使用矩形窗口作为固定大小,这将在以下两种情况下产生错误结果:

- 深度不连续:如果窗口的相关重叠部分的深度不连续,基于窗口包含不同深度的像素的考虑,这将会导致结果的不确定性。

- 均匀区域:如果支持窗口不包含强度的变化,则匹配过程将会产生错误结果。

考虑到这些问题的存在,这一步的目的是在深度的不连续性,以及在均匀区域内纠正虚假匹配,得到准确的结果。为了妥善处理图像的模糊问题,我们描述了一个有效的方法,即选择自适应形状窗口,这样支持窗口在每个像素都将产生变化(包括不正确的视差值)。在细节上,我们首先要从通过检测参考图像中的边缘开始。然后,我们使用大的窗口要充分覆盖强度变化。在此之后,对于每个缺失值的视差图,如果遇到冲突像素,我们就定义像素的窗口。通过使用边缘检测结果,我们只保留像素属于相同的连接组件,以检索适当的对象的形状,并避免跨越边界。这是限制相关像素数量和避免窗口包含超过一个对象有效的办法。这种自适应重塑窗口的选择减少被称为离群值的错误的影响。我们应该注意到,在整个图像中我们没有使用可变窗口,因为它是耗时的过程,同时,噪声也会对视差图产生影响。所以,最好的方法就是在匹配不正确的地方改变窗口的形状和大小。

3.深度图估计

我们提出了一种新的方法来计算视差图。可以通过物体表面到成像系统距离来得到深度图的信息。在位置(i,j)处,深度Z是这样定义的:

(6)

其中f表示焦距,B为基线,d为视差值。

视差值的不确定性导致深度图中的错误。通过表示和Z分别表示估计值和实际深度值,我们可以得到:

(7)

(8)

其中d、分别是代表估计值和实际视差值。考虑到视差值的不确定性和在该范围内计算深度图的误差,涉及到这些变量的等式是:

(9)

深度误差与视差误差可以以图形形式绘制结果,如图2所示:

图2.深度误差与视差误差

4.实验结果

实验在Intel Core 2 Duo P7350, 2 GHZ, 4 Go RAM的笔记本电脑上运行,视差图上的立体对计算需要25到36秒。在本节中,我们列出了与现高水平立体匹配算法相互比较而得的各种数据集。在图3中,所提出的立体匹配方法是使用米德尔伯里的数据集进行评估(http://vision.middlebury.edu/stereo/),我们可以看到基于四个立体对所得到的视差结果图。通过查看灰度级的结果,发现相近的对象有较大的视差值,而距离较远的对象则是视差值较为接近。在同一图中的每个立体匹配对,我们可以发现计算所得视差图和真实视差图之间的不同。定量结果与NCC(归一化互相关)方法的比较, Daisy描述子和局部实现方法在表1中表明,在这张表中,为更好地评估结果,我们计算质量度量EQM(误差平方)使用下面的公式:

(10)

其中Nlowast;M为图像的大小,表示计算的视差图,表示真实视差图。

这个表证明相比其他引用的立体匹配方法,我们的方法提供了更精确的视差图(更小的EQM值)。

5.结论

一种新的立体匹配方法已被引入,它用来估计密集和准确的视差图,能够解决两个图像之间的立体对的不同强度值的问题。除此此外,它能够通过验证所得到的视差图避免模糊匹配。使用米德尔伯里的数据集,我们的方法已经被实验验证具有良好的效果。除此此外,通过与文献中的其他方法的比较,我们证明了我们的研究结果的整体性能。

表1.基于middleburry不同立体对的EQM立体匹配算法的比较

Dolls

(370x463)

Moebius

(370x463)

Aloe

(370x427)

Cones

(375x450)

Reindeer

(370x447)

参考图像 真实数据 我们的结论 差异图

图3 我们的数据基于Middlebury 数据集,从上到下的顺序为:Dolls, Moebius, Aloe, Cones and Reindeer立体图像,从左到右依次为:参考图像,真实视差图,提取的视差图及真实视差图与提取视差图之间的差异图(差异图用颜色映像表示,颜色在青色到洋红色范围内变化)。

自适应窗口立体匹配算法︰ 理论与实验

简 介