英语原文共 8 页,剩余内容已隐藏,支付完成后下载完整资料

VGGFace2:一个跨年龄多姿势的人脸识别数据集

Qiong Cao, Li Shen, Weidi Xie, Omkar M. Parkhi and Andrew Zisserman

Visual Geometry Group, Department of Engineering Science, University of Oxford

{qiong,lishen,weidi,omkar,az}@robots.ox.ac.uk

摘要:本文介绍了一种新的大规模人脸数据集VGGFace2。数据集包含属于9131名对象的331万张图像,平均每个对象有362.6张图像。这些图像从谷歌图像搜索中下载,在姿势、年龄、光照、种族和职业(如演员、运动员、政治家)方面有很大的差异。

数据集的收集有三个目标:(i)有大量的身份,每个身份也有大量的图像;(ii)涵盖多种姿势、年龄和种族;(iii)尽量减少标签噪音。我们描述了数据集是如何收集的,特别是确保图像与身份高度匹配的自动和手动过滤阶段。

为了评估使用新数据集的人脸识别的性能,我们在VGGFace2、MS-Celeb-1M和它们的并集上训练ResNet-50卷积神经网络(分别在有和没有挤压-激励模块的情况下),并证明在VGGFace2上的训练可以提高识别性能,不分姿势和年龄。最后,使用在这些数据集上训练的模型,我们在IJB-A和IJB-B人脸识别基准上展示了最先进的性能,这远远超过了以前的最先进水平。数据集和模型是公开的。

关键词—人脸数据集;人脸识别;卷积神经网络

1.引言

随着深度卷积神经网络(CNNs)的快速发展,在收集大规模数据集以满足数据密集型模型这方面,最近已经有了大量的工作。一般来说,最近的数据集(见表一)探讨了类内和类间变异的重要性。前者侧重于深度(一个对象的许多图像),后者侧重于广度(许多对象,每个对象的图像有限)。然而,这些数据集都不是专门用来研究姿势和年龄变化的。我们为了解决这个问题,在这里设计了一个数据集生成管道来明确地收集具有广泛姿态、年龄、光照和种族变化的人脸图像。

我们做了以下四个贡献:首先,我们收集了一个新的大型数据集,VGGFace2,用于公开发布。它包括9000多个身份,每个身份有80到800张图片,总共有300多万张图片;其次,提出了一个数据集生成管道,鼓励每个对象的姿势和年龄多样性,并涉及多个阶段的自动和手动过滤,以最小化标签噪声;第三,我们为测试集提供模板注释,以显式探索姿势和年龄识别性能;最后,我们证明在新数据集上对深度CNNs的训练效果大大超过了在IJB基准数据集[13]、[22]上的最新性能。值得一提的是,我们用最近的挤压和激励网络[9]进行了实验,并研究了首先在广度数据集(MS-Celeb-1M[7])上进行预训练,然后在VGGFace2上进行微调的好处。

2.数据集回顾

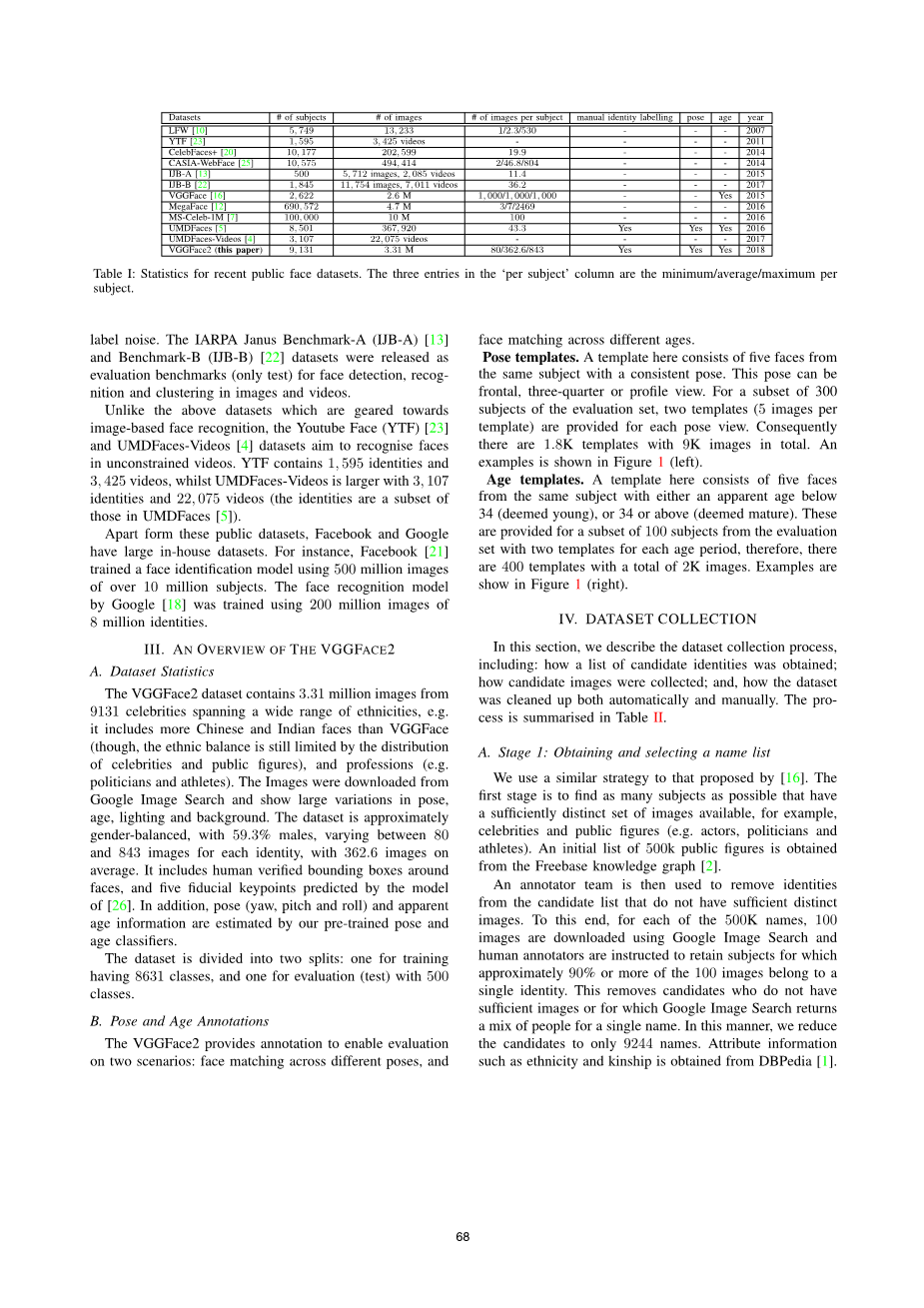

在这一节中,我们简要回顾了最近出现的主要的“野外”数据集,这些数据集的灵感来自于2007年[10]的原始标记人脸(LFW)数据集。这个数据集有5749个身份和13000张图片。

2014年发布的CelebFaces 数据集[20]收录了10177位名人的202599张照片。同年发布的CASIA-WebFace数据集[25]拥有494414张10575人的图像。2015年发布的VGGFace数据集[16]拥有260万张图像,覆盖2622人,是最大的公开数据集之一。在策展版中,人工标注者可以去除标签噪声,该版本有80万张图像,每个身份大约有305张图像。CASIA-WebFace和VGGFace数据集都只用于训练。

2016年发布的MegaFace数据集[12]用于评估人脸识别方法,它包含多达100万个干扰物。该数据集拥有属于672057个身份的470万张图像作为训练集。然而,平均每个身份只有7张图片,这就限制了每个身份的面部差异。为了研究姿势和年龄变化在人脸识别中的影响,MegaFace挑战赛[12]使用FaceScrub[14]的子集(包含来自80个身份的4000张图像)以及FG-NET[15]的子集(包含来自82个身份的975张图像)来进行评估。

2016年,微软发布了大型的Ms-Celeb-1M数据集[7],其中包含了来自10万名人的1000万张图片,用于训练和测试。这是一个非常有用的数据集,我们将其用于本文的预训练。然而,它有两个局限性:(i)虽然它拥有数量最多的训练图像,但由于每个人平均只有81张图像,因此内部特征的变化受到一定的限制;(ii)训练集中的图像是直接从搜索引擎中检索出来的,没有人工过滤,因此存在标签噪声。IARPA Janus Benchmark-A (IJB-A)[13]和Benchmark-B (IJB-B)[22]数据集被发布出来,是用作图像和视频中人脸检测、识别和聚类的评价基准(仅限测试)的。

与上述这些针对基于图像的人脸识别的数据集不同,Youtube face (YTF)[23]和UMDFaces-Videos[4]数据集旨在识别无约束视频中的人脸。YTF包含1595个身份和3425个视频,而UMDFaces-Videos更大,有3107个身份和22075个视频(这些身份是UMDFaces[5]中的一个子集)。

除了这些公共数据集,Facebook和谷歌还有大量的内部数据集。例如,Facebook[21]训练了一个面部识别模型,该模型使用了超过1000万名对象的5亿张图像。谷歌[18]的人脸识别模型使用了800万个身份的2亿张图像进行训练。

3. VGGFACE2综述

A.数据集统计

VGGFace2数据集包含了来自9131位名人的331万张图像,这些名人来自不同的种族,例如,它包含了比VGGFace更多的中国和印度面孔(尽管,种族平衡仍然受到名人和公众人物分布的限制),以及职业(例如,政治家和运动员)。这些图像是从谷歌图像搜索中下载的,在姿势、年龄、灯光和背景上差异巨大。数据集大致性别平衡,有59.3%的男性,每个身份有80到843张图像,平均有362.6张图像。它包括人脸周围的人类验证边界框,以及由[26]中的模型预测的五个基准关键点。此外,姿态(偏航角,俯仰角,翻滚角)和表观年龄信息由我们预先训练的姿态和年龄分类器估计。

数据集分为两个部分:一个用于训练,有8631个类别,另一个用于评估(测试),有500个类别。

B.姿态和年龄标注

VGGFace2提供了对两种情况进行评估的标注:不同姿势的面部匹配和不同年龄的面部匹配。

姿势模板。这里的模板由来自同一对象的五张脸组成,对象摆出一致的姿势。这个姿势可以是正面,四分之三或侧面。对于含有300名对象的评估集子集,每个姿态视图提供两个模板(每个模板5张图像)。因此,总共有1800个模板,9000个图像。图1(左)显示了一个示例。

年龄模板。该模板由来自同一对象的五张脸组成,其中一张的表观年龄低于34岁(视为青少年),另一张34岁或以上(视为成年)。这些提供给含有100名对象的评估集子集,每个年龄段有两个模板,因此,有400个模板,总共有2000张图像。图1(右)显示了一些示例。

4. 数据集采集

在本节中,我们将描述数据集收集过程,包括:如何获得候选身份列表;如何收集候选图像;以及如何自动和手动清理数据集。表2总结了这一过程。

A.阶段1:获取并筛选一个名单

我们使用的策略与[16]提出的策略类似。第一步是尽可能多地找到那些具有足够清晰图像集的对象,例如名人和公众人物(如演员、政治家和运动员)。50万公众人物的初始列表是从Freebase知识图[2]中获得的。

然后标注团队从候选列表中删除那些没有足够不同图像的身份。为此,对这50万个人名中的每一个,我们都使用谷歌图像搜索,然后下载100幅图像,并指示人工标注者仅保留达标的对象,这些对象,它的100幅图像中大约要有90%或更多图像属于同一身份才算达标。这将删除那些没有足够图像的人以及在谷歌图像搜索结果中重名的人。通过这种方式,我们将候选人减少到只有9244人。这些人的属性信息,如种族和亲属关系,是从DBPedia[1]中获得的。

B. 阶段2:获取每个身份的图像

我们在谷歌图像搜索中查询,并为每个对象下载1000幅图像。为了获得姿势和年龄变化较大的图片,我们在每个名字后面加上关键字“侧身”和“非常年轻”,每次下载200张图片。这将为每个身份生成1400个图像。

C. 阶段3:人脸检测

使用在[26]中提供的模型检测人脸。我们使用了在那篇文章中推荐的超参数,以便在精确率和召回率之间取得一个好的平衡。然后将面部包围框扩展0.3倍以包括整个头部。此外,该模型还预测了5个面部标志。

D. 阶段4:自动分类过滤

这个阶段的目的是自动删除每个身份的异常面孔。我们通过学习一个分类器来识别人脸,并在分类分数下去除可能的错误人脸来实现这一点。为此,我们训练1-vs-rest分类器来区分9244个对象。具体来说,每个身份检索到的前100张人脸图像都被用作正面,而所有其他身份检索到的前100张人脸图像都被用作负面。人脸描述符特征是从VGGFace[16]模型中获得的。然后,我们用从训练模型得到的分数(0到1之间)来对每个对象的图像进行排序,按照从最可能到最不可能的顺序。通过手动检查随机抽取的500名对象的图像,我们选择0.5的阈值,并删除低于这个阈值的所有面孔。

E. 阶段5:相似重复删除

下载的图像中还包含完全一样或相似的图像,因为这些图像位于互联网上的不同的位置,或者图像间的差异只有轻微的色彩平衡或JPEG工件等。为了缓解这一问题,我们对所有仍处于阶段4的图像依据VLAD描述符进行聚类,并在每个簇[3]、[11]中只保留一个图像,以此来删除重复的图像。

F. 阶段6:最终的自动和手动过滤

此时,可能仍然存在两种类型的错误:第一类错误是,一些分类仍然有异常值(即存在不属于这个人的图像); 第二类错误是,有些分类包含不止一个人的面孔,或者它们与数据集中的另一个分类重叠。此阶段使用手动和自动算法的组合来处理这两种类型的错误。

检测重叠对象。对象可能与其他对象重叠。例如,“Will I Am”和“William James Adams”在候选名单中指的是同一个人。为了检测每个类别的混淆,我们将每个类别的数据随机分成两部分:一半用于训练,另一半用于测试。然后,我们训练一个ResNet-50[8],并计算测试样本上的top-1错误来生成一个混淆矩阵。通过这种方式,我们发现有20个对象与其他对象相混淆。在这个阶段,我们删除了19个有噪声的类别。此外,我们删除了94名对象,这些对象的样本少于80幅图像,我们最终得到9131个身份。

删除对象的异常图像。这种过滤的目的是达到96%以上的纯度。我们发现,对于某些对象来说,第四阶段分类器得分很高的图像也可能是有噪声的。当下载的图像包含总是一起出现在公共场合的情侣或乐队成员时,就会发生这种情况。在这种情况下,在阶段4中使用这些混合样本训练的分类器往往会失败。

我们基于当前的数据集对模型进行再训练,对于每个身份,我们使用分类器评分将图像分为3组:H(即高评分范围[1,0.95]),I(即中等评分范围(0.95,0.8))和L(即低评分范围(0.8,0.5))。人工标注者根据每个对象的得分来清理图像,他们的工作取决于集合H是否有噪声。如果集合(H) 在一个身份文件夹中包含多个不同的人(有噪点),那么集合I和集合L(置信度得分较低)无疑也会有噪点,所以这三个集合都需要手工清理。相反,如果集合H是干净的,那么就只清理集合L(最低的分数,应该是噪声最大的集合),然后在清洗后的集合H和L上训练一个新的模型,通过这个模型的预测来清洗集合I(中等分数,噪声水平也是中等)。这个过程实现了非常低的标签噪声,不需要手动检查每个图像。

G. 姿势和年龄标注

我们训练了两个网络来获取数据集的姿态和年龄信息。为了获得头部姿态(翻滚角、俯仰角、偏航角),我们在CASIA-WebFace数据集[25]上训练5路分类器ResNet-50[8],然后,使用这个训练好的模型来预测数据集中所有图像的姿态。类似地,为了估计表观年龄,我们在IMDB-WIKI - 500k 数据集[17]上训练了一个8路分类器ResNet-50[8],然后用这个模型预测人脸的年龄。

5. 实验

在本节中,我们通过执行大量的基准实验来评估VGGFace2数据集的质量。我们在VGGFace2测试集上得出结果,并在公共基准IJB-A[13]和IJB-B数据集[22]上进行评估。我们的训练数据集中的对象与IJB-A和IJB-B数据集中的对象不一致。在训练网络时,我们还消除了

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[239636],资料为PDF文档或Word文档,PDF文档可免费转换为Word