英语原文共 10 页,剩余内容已隐藏,支付完成后下载完整资料

(特征)对齐的行人重识别:

超越人类识别表现的行人重识别

摘要:

在本文中,我们提出了一种新的方法叫做AlignedReID(局部特征对齐的行人重识别),它提取了一个与局部特征共同学习的全局特征。全局特征学习很大程度上得益于局部特征学习,局部特征学习通过计算两组局部特征之间的短路径来执行对齐/匹配,且不需要额外的监督。在共同学习之后,只保留全局特征来计算图像之间的相似性。我们的方法在Market1501数据集上达到了94.4%的第一匹配率,在CUHK03数据集上达到了97.8%,大大超过了最先进的方法。在广泛使用的两个行人重识别数据集(Market1501和CUHK03)上,我们评估了人类水平表现,并证明我们的方法首次在Market1501和CUHK03数据集上超过了人类水平表现。

1.介绍

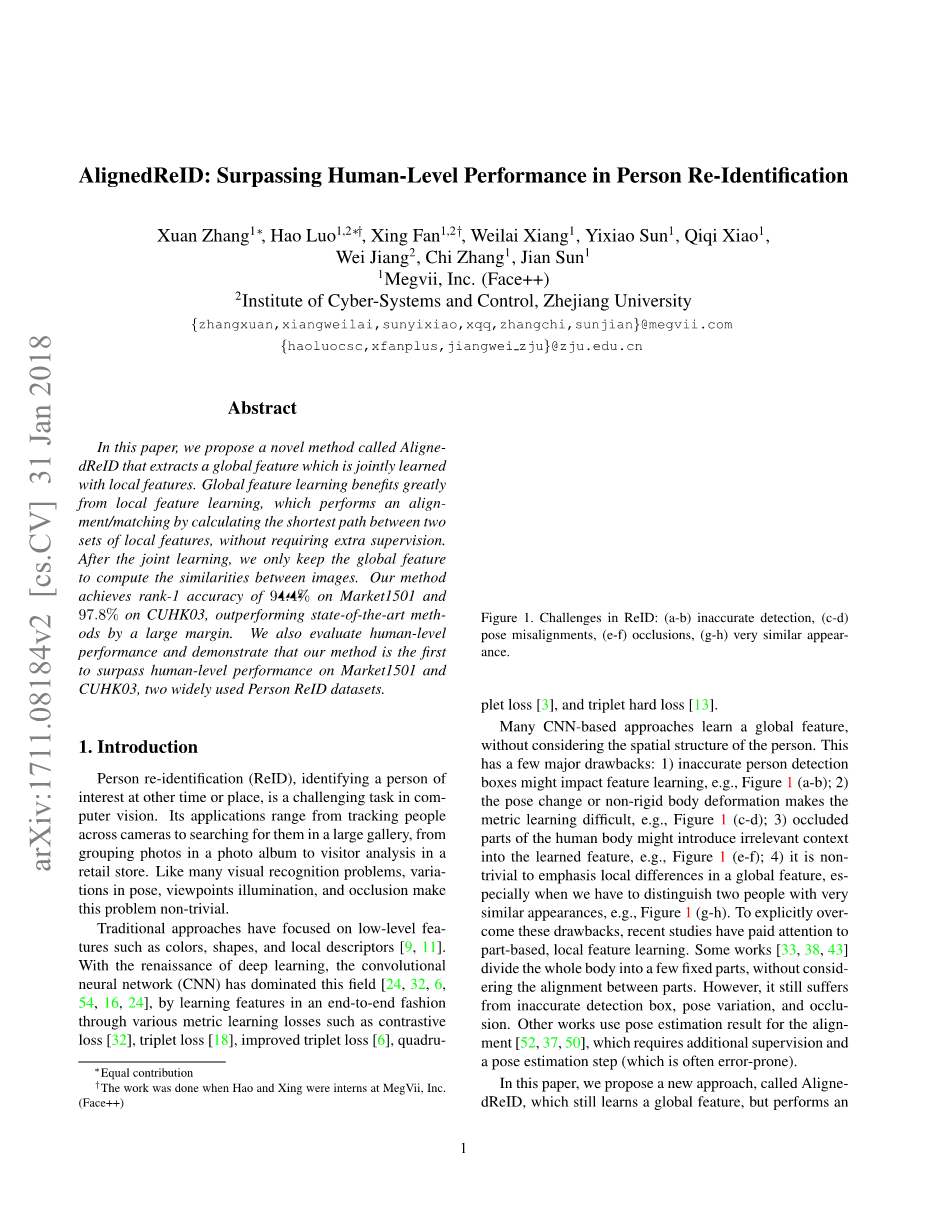

行人识别(ReID),在其他时间或地点识别目标人物,是计算机视觉中一项具有挑战性的任务。它的应用范围从通过摄像头跟踪人们到在大型画廊中搜索他们,从相册中的照片分组到零售商店中的访客分析。像许多视觉识别问题一样,姿势、视点照明和遮挡的变化使这个问题变得非常重要。传统的方法侧重于低级特征,如颜色、形状和局部描述符[9][11]。随着深度学习的复兴,卷积神经网络(CNN)在这一领域占据主导地位[24、32、6、16、24、54],通过各种度量学习损失(如对比损失[32]、三倍损失[18]、改进的三倍损失[6]、四倍损失[3] 许多基于CNN的方法学习一个全球性的特征,而不考虑个人的具体结构。这有几个主要的缺点:1)不准确的人体检测轻微影响特征学习,如图1(a-b);2)姿势改变或非刚性身体变形使度量学习变得困难,如图1(c-d);3)人体的封闭部分可能会将不相关的上下文引入所学特征,如图1(e-f);4)强调全球特征中的局部差异是非常重要的,特别是当我们必须区分两个外表非常相似的人时,例如图1(g-h)。为了有效地将这些图纸包、最近的研究与基于零件的局部特征学习相结合。有些作品[33、38、43]将整个身体分割成几个部分,而不考虑部件之间的对齐。但是,它仍然会受到不准确的检测框、姿势变化和遮挡的影响。其他工作使用姿态估计结果进行校准[52、37、50],这是一个相等的附加监督和姿态估计步骤(通常容易出错)。和三倍硬损失[13])采用端到端的方式学习功能。

图 1 行人重识别存在的问题:(a-b)不准确检测,(c-d)姿势不对齐,(e-f)人体封闭部分,(g-h)外观相似

许多基于CNN的方法学习一个全局性的特征,而不考虑行人的具体结构。这种方式有几个主要的缺点:1)不准确的人检测盒轻微影响特征学习,如图1(a-b);2)姿势改变或非刚性身体变形使度量学习变得困难,如图1(c-d);3)人体的封闭部分可能会将不相关的上下文引入进行学习的特征,如图1(e-f);4)强调全局特征中的局部差异是非常重要的,特别是当我们必须区分两个外表非常相似的人时,例如图1(g-h)。为了有效地克服这些缺点,最近的研究与基于零件的局部特征学习相结合。有些作品[33、38、43]将整个身体分割成几个部分,而不考虑部件之间的对齐。但是,它仍然会受到不准确的检测框、姿势变化和遮挡的影响。其他工作使用姿态估计结果进行校准[37、50、52],这是一个相等的附加监督和姿态估计步骤(通常容易出错)。

在本文中,我们提出了一种新的方法,即AlignedReID(局部特征对齐的行人重识别),它仍然学习全局特征,但在学习过程中执行自动部件对齐,不需要额外的监督或明确的姿态估计。在学习阶段,有两个分支共同学习全局特征和局部特征。在局部分支中,通过引入最短路径损耗来对齐局部部分。在理论阶段,只讨论局部随机抽取全局特征。我们发现,应用的是最基本的、最优秀的、最具组合性的全局和局部特性。简单来说,在新的联合学习框架中,全局特性能够局部特性学习的帮助下,能够有效地解决前面提到的撤回问题。此外,全局特性的形式这种方法在部署大型重识别系统时具有优势,而无需冗杂的局部特性匹配。

在度量学习设置中,我们还采用了相互学习的方法[49],允许两个模型相互学习更好的表示。系统将AlignedReid和相互学习结合起来,在Market1501、CUHK03和CUHK-SYSU数据集上的表现远远超过了现有的先进系统。为了了解人类在重识别任务中的表现如何,我们测量了Market1501和CUHK03上十位专业注释师的最佳人类表现,之后二者进行对比发现系统[57]比测得的人类表现具有更高的准确性。据我们所知,这是中国在重识别任务中的表现超过人类表现的报告。

2.相关工作

格律学习。将原始图像分解为嵌入特征,然后计算特征距离作为它们的相似性。通常,同一个人的两个图像定义为一对正图像,而不同人的两个图像定义为一对负图像,而正负对之间的利差造成三重损失[18]。通过硬采掘为培训模型选择合适的样本已经证明是有效的[13、3、39]。将SoftMax损失与度量学习损失相结合以加速收敛也是一种流行的方法[10]。

特征对齐。许多工作学习全局特征来表示一个人的图像,忽略图像的空间局部信息。有些工作通过将图像分割成多个没有对齐的部分来考虑定位信息[33、38、43],但这些方法存在检测框不准确、遮挡和姿势不能对齐等问题。

最近,通过姿态估计来调整局部特征已经成为一种流行的方法。例如,姿势不变嵌入(pose invariant embedding,PIE)将行人与标准姿势对齐,以减少姿势变化的影响[52]。全局局部对齐描述符(Global-Local Alignment Descriptor ,GLAD)[37]不直接对齐行人图像,而是检测关键姿势点并从相应区域提取局部特征。SpindleNet [50]使用区域候选网络(region proposed network ,RPN)生成多个身体区域,逐步组合不同阶段相邻身体区域的响应图。这些方法需要额外的姿态注释,并且必须处理姿态估计带来的误差。

相互学习。[49]提出了一个深入的相互学习策略,在整个培训过程中,一组学生共同学习并互相教授。DarkRank[4]为模型压缩和加速引入了一种新的知识交叉样本相似性,实现了最先进的性能。这些方法在课堂上使用相互学习。在这项工作中,我们研究了度量学习环境下的相互学习。

重新排序。在获得图像特征后,大多数现有的作品选择二级欧氏距离来计算排序或检索任务的相似性得分。[35、57、1]应用其他的警告以提高准确性,特别是[57]提出了一种结合原始距离和Jaccard距离的Kreciprocal编码的重新排序方法。

3.我们的方法

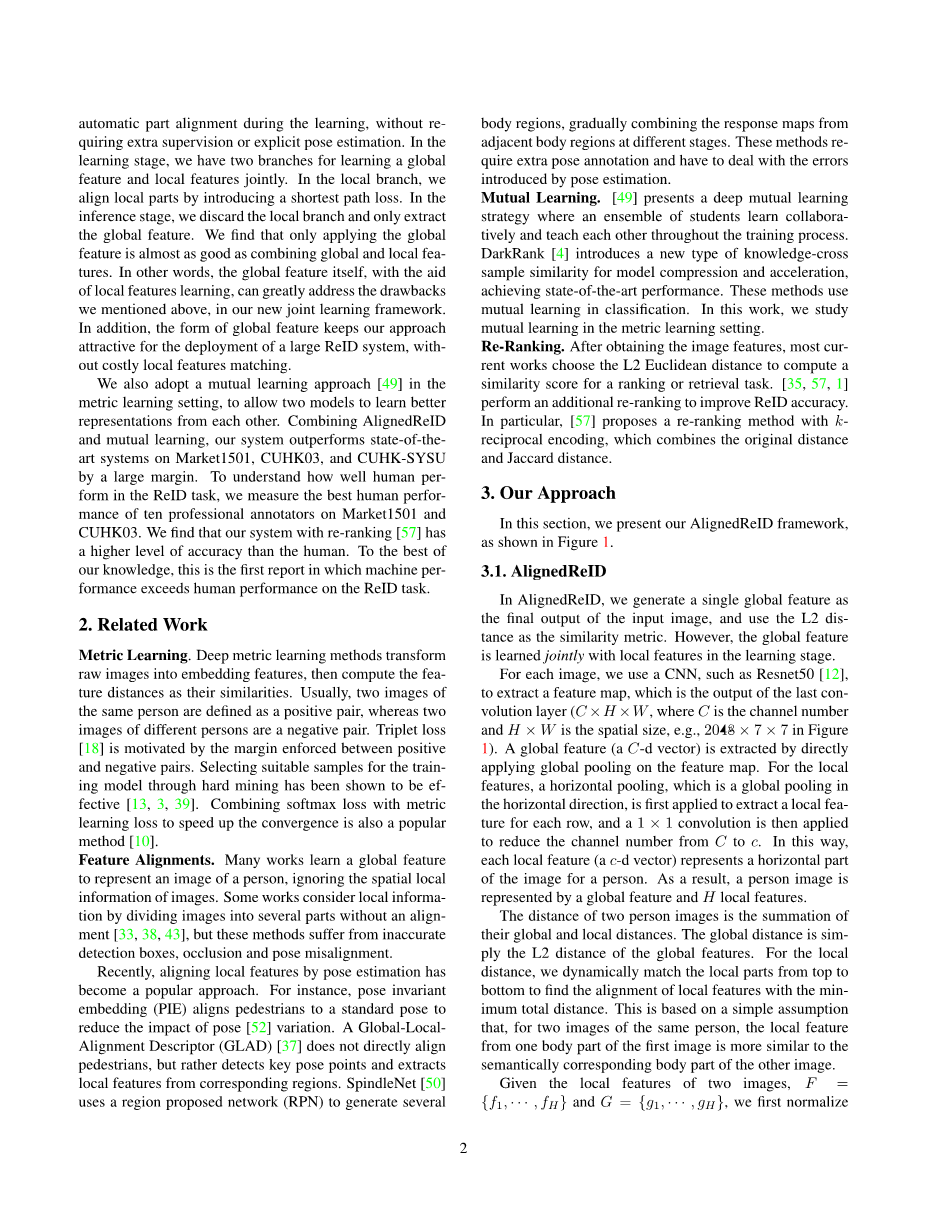

本节展示了AlignedReid框架,如图2所示。

图 2 AlignedReID的框架。全局分支和局部分支共享同一卷积网络来提取特征图。通过将全局池直接应用于特征映射,可以提取全局特征。对于局部分支,经过水平方向的全局池进行水平池化后,通过1times;1卷积层。采用三重硬损失法,根据全局距离,通过硬样本挖掘法得到三重样本。

3.1 AlignedReID

在AlignedReID中,生成单个全局特征作为输入图像的最终输出,并使用L2距离作为相似性度量。然而,在学习阶段,全局特征是与局部特征共同学习的。

对于每幅图像,我们使用CNN(如Resnet50[12])提取特征图,这是最后一个卷积层的输出(,其中是通道数,是空间大小,如图2中的2048times;7times;7)。通过在特征图上直接应用全局池来提取全局特征(C-D向量)。对于局部特征,水平池(水平方向的全局池)被用于每行的特征提取,然后应用1times;1的卷积将通道数从减少到C。这样,每个局部特征(C-D矢量)代表一个人图像的水平部分。因此,一个人的形象由一个全局特征和局部特征来表示。

两人图像的距离是它们的全局和局部距离的总和。全局距离就是全局特征的L2距离。对于局部距离,我们从上到下动态匹配局部零件,以确定局部特征与最小总距离的对齐方式。这是基于一个简单的假设,即对于同一个人的两个图像,第一个图像的一个身体部分的局部特征与另一个图像的语义对应的身体部分更相似。

鉴于两幅图像的局部特征, 和, 首先通过元素转换将距离标准化为[0,1]。

|

|

(1) |

其中,是第一幅图像的第个垂直部分和第二幅图像的第个垂直部分之间的距离。距离矩阵是基于这些距离形成的,其中元素是。我们确定了矩阵中到最短路径的两个图像之间的局部距离,即最短路径的总距离。可通过动态规划计算距离,如下所示:

|

|

(2) |

式中,是距离矩阵中到的最短路径的总距离,以及是两幅图像之间最终最短路径(即局部距离)的总距离。如图3所示,图像A和B是同一个人的样本。相应的身体部位(如图像A中的第1部分和图像B中的第4部分)之间的对齐包含在最短路径中。同时,非对应部分如图像A中的第1部分和图像B中的第1部分之间的对齐仍然包含在最短路径中。这些非对应的对准必须按照垂直对准的顺序进行,并使相应的对准成为可能。非对应对准有较大的L2距离,其梯度在式1中接近于零。因此,这种路线在最短路径中的贡献很小。短路径的总距离,即两幅图像之间的局部距离,最早由相应的对齐确定。

图 3 通过确定最短路径计算的AlignedReID局部距离示例。黑色箭头显示右侧相应距离矩阵中的最短路径。黑线显示左边两个图像之间的对应对齐方式

全局距离和局部距离共同决定了两个图像在学习阶段的相似性,我们选择了[13]提出的三重损失作为度量学习损失。对于每个样本,根据全局距离,选择同人的最不相同的样本和具有不同人的最相似的样本,得到一个整体。对于这个整体,损失是基于全局距离和具有不同边缘的局部距离计算的。使用全局距离采掘硬样本的原因有两个考虑因素。首先,计算全局距离比计算局部距离快得多。其次,我们观察到,使用两种距离采集得到的样本没有显著差异。注意,在理论阶段,我们只使用全局特征来计算两个人图像的相似性。因为我们意外地发现,全局特性本身也几乎和组合特性一样好。这种有悖直觉的现象可能由两个因素造成:1)共同学习的特征图比只学习全局特征要好,因为我们在学习阶段已经充分利用了人的形象结构;2)借助于局部特征匹配,全局特征可以更加关注人的身体,而不是过度定义背景。

3.2.度量学习的相互学习

使用相互学习的方法来训练AlignedReid的模型可以进一步提高性能。基于蒸馏的模型通常将知识从预先培训的大型教师网络传输到较小的学生网络,如[4]。在本文中,我们同时训练了一组学生模型,相互传递知识,如[49]。与仅采用Kullback-Leibler(KL,交叉熵)分类概率之间距离的[49]不同,我们提出了一种新的度量学习互学习损失。我们的相互学习方法框架如图4所示。实际损失函数包括计量损失、计量相互损失、分类损失和分类相互损失。度量损失由全局距离和局部距离共同决定,而度量相互损失仅由全局距离决定。分类相互损失是[49]中分类的KL差异。

图 4 相互学习方法的框架。两个参数为theta;1和theta;2的网络一起训练。每个网络有两个分支:一个分类分支和一个度量学习分支。分类分支机构接受分类损失培训,并通过分类相互损失相互学习。度量学习分支通过度量损失进行训练,包括全局距离和局部距离。同时,度量学习分支通过度量互损失进行学习。

给定N个图像,每个网络提取其全局特征,计算每张图像和其他图像之间的的全局距离得到Ntimes;N个距离矩阵,其中 和 分别表示矩阵中的 元素。相互学习误差定义为:

|

|

(3) |

其中,表示零梯度函数,它在计算梯度时将变量视为常量,在学习阶段停止反向传播。通过应用零梯度函数,二阶梯度是

|

|

(4) |

我们发现,与没有零梯度函数的互损失相比,它加快了收敛速度,提高了精度。

4.实验结果

在本节中,我们介绍了三个最广泛使用的REID数据集的实验结果:Market1501[53]、CUHK03[14]和CUHK-SYSU[41]。

4.1数据集

Market1501数据集中包含32668张照片,其中1501张标记为六个摄像头视图的人。训练集中有751个身份,测试集中有750个身份。在最初对该数据集的研究中,作者还使用map作为评估标准来测试算法。

CUHK03是一个大规模的个人搜索基准,包含18184张图片(99809个边界框)和8432个身份。训练集包含11206张5532人的图像,而测试集包含6978张2900人的图像。

注意,我们只使用来自所有三个数据集的训练样本训练单个模型,如[40、50]所示。遵循Market1501和CUHK03的标准训练和评估协议流程,主要求得均值平均精度(mAP)和rank-1的准确性。对于CUHK03,由于为所有基准训练了一个单一模型,因此它与[14]中的标准程序略有不同,后者将数据集随机拆分20次,用于测试的库每次有100个标识。我们只随机分割数据集一次,用于训练和测试,目标画廊图像包括200个身份。这意味着训练和测试任务可能会比标准流程更困难。同样,在CUHK03上用rank-1、rank-5和rank-10的精确度评估方法优劣。

4.2.实施细则

使用在ImageNet[28]上预先培训的Resnet50和Resnet50-

全文共18875字,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[628]