英语原文共 12 页,剩余内容已隐藏,支付完成后下载完整资料

深度人脸识别

摘要

本文的目标是人脸识别,即从单张照片或从视频中跟踪的一组人脸进行识别。最近这个领域取得进展是由于两个因素:(i)使用卷积神经网络(CNN)进行端到端的学习任务,以及(ii)可获得超大规模训练数据集。

我们做出了两项贡献:首先,我们展示了如何通过循环中的自动和人工组合来获取大规模数据集(2.6万张图像,超过2600人),并讨论了在数据纯度与时间之间的折衷办法;其次,我们通过深度网络的训练和人脸识别的复杂性来展示我们的方法和程序,其在标准LFW和YTF人脸基准上实现的效果可与目前最优结果相媲美。

1.介绍

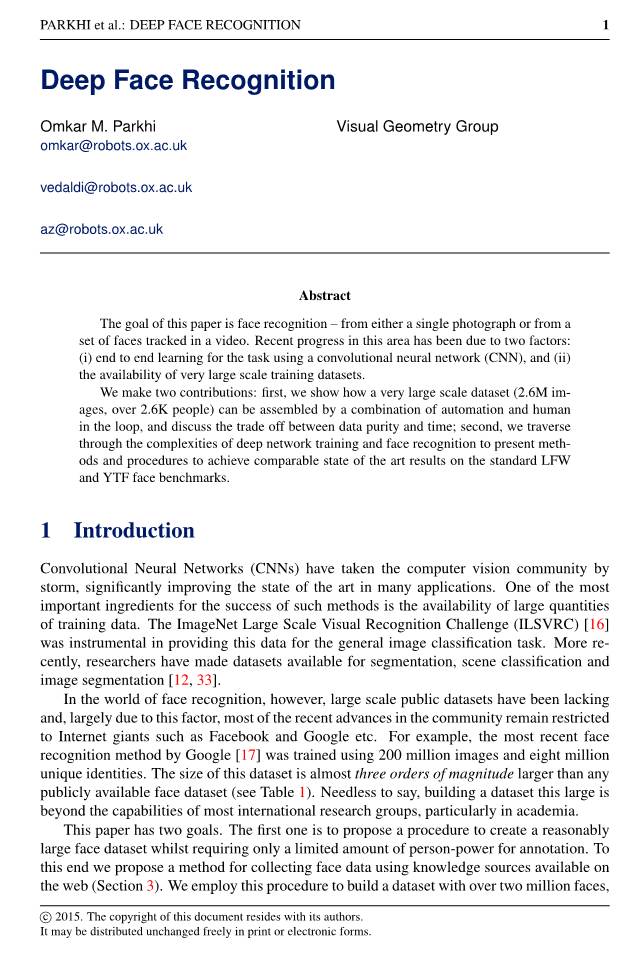

卷积神经网络(CNNs)已经让计算机视觉领域受到了极大的冲击,显著改善着其在许多应用领域的艺术水平。这种方法成功的最重要的因素之一是可以获得量的训练数据。ImageNet大规模视觉识别挑战(ILSVRC)[16]有助于为普通图像分类任务提供这些数据。最近,研究人员已经将数据集用于分割,场景分类和图像分割上[12 33]。然而,在人脸识别领域缺乏大规模的公共数据集。主要是由于这个原因,该领域近来的大部分法仍局限于互联网巨头,例如Facebook和Google等等。例如,最近Google提出来的人脸识别算法使用2亿张图片和800万个独立的身份进行训练。这个数据集的大小几乎比任何公开可用的人脸数据集大三个数量级(见表1)。不用说,建立一个这样大的数据集超出了大多数国际研究团队的能力,特别是在学术界。

|

数据集 |

个体 |

图像 |

数据集 |

个体 |

图像 |

|

|

LFW |

5,749 |

13,233 |

Ours |

2,622 |

2.6M |

|

|

WDRef [4] |

2,995 |

99,773 |

FaceBook [29] |

4,030 |

4.4M |

|

|

CelebFaces [25] |

10,177 |

202,599 |

Google [17] |

8M |

200M |

表1:数据集比较:我们的数据集拥有除Google,Facebook或百度这样的工业数据集以外的最大的面部图像集,且这些工业数据集并非公开可用

本文有两个目标。第一个是提出一个程序来创建一个相当大的人脸数据集,同时只需要有限的人力进行注释。为此,我们提出了一种使用网络上可用的知识源收集人脸数据的方法(第3节)。我们使用这个程序来建立一个拥有超过两百万张脸的数据集,并且可以让研究人员免费使用它。第二个目标是使用新的数据集进行训练(第4节)来研究各种CNN架构的人脸识别和验证,包括探索人脸对齐和度量学习。最近许多关于人脸识别的研究已经提出了脸部CNN体系结构的众多变体,并且我们评估了一些这些模型的选择,以便从不相关的细节中过滤出重要的部分。结果是一个简单而有效的网络架构,它在所有流行的图像和视频人脸识别基准(第5节和第6节)上实现了接近最新的结果。我们在6.2节总结了我们的研究结果。

2.相关工作

本文重点介绍图像和视频中的人脸识别,这是近年来受到重视的一个问题。在文献中提出的许多方法中,我们将那些不使用深度学习的方法(我们称之为“浅”)与那些使用深度学习的方法区分开来。浅层方法首先使用手工标记的局部图像描述符(如SIFT,LBP,HOG [5,13,22,23,32])提取人脸图像的表示;然后他们通过使用池化机制,例如Fisher Vector [15,20],将这些局部描述符聚合为一个整体描述符。这里有大量的这种方法,不能在本文详细描述(例如参见[15]中的参考文献)。

这项工作主要关注面向人脸识别的深层架构。这种方法的定义的特点是使用CNN特征提取器,即通过组合多个线性和非线性算子获得的可学习函数。这类方法的代表性系统是DeepFace [29]。该方法使用深度卷积神经网络来进行训练,使用包含4000个唯一身份的400万个示例的数据集对人脸进行分类。它也使用连体网络结构,其中相同的CNN被应用于面对以获得描述符,然后使用欧几里德距离进行比较。训练的目标是最小化相同的面对之间的距离(即刻画相同的身份),并最大化不一致面对之间的距离,这是一种度量学习的形式。除了使用大量的训练数据之外,DeepFace还使用CNN集合以及预处理阶段,其中预处理中使用3D模型将脸部图像与规范姿势对齐。在提出时,DeepFace在野外贴标签(LFW; [8])基准测试以及Youtube野外测试(YFW; [32])基准测试中实现了最佳性能。作者后来在[30]中扩展了这项工作,即将数据集的大小增加两个数量级,其中包括1000万个身份和每个身份对应的50个图像。他们提出了一种自举策略来选择身份来训练网络,并表明通过控制全连接层的维度可以提高网络的泛化能力。

Sun等人的DeepId系列论文扩展了DeepFace的工作。 [24,25,26,27],其中每一个都逐渐但稳步地增加了算法在LFW和YFW的表现。在这一系列论文中纳入了许多新的想法,包括:使用多个CNN [25],贝叶斯学习框架[4]来训练度量,分类和验证的多任务学习[24],在每个卷积层[26]之后分支出一个全连接层的不同的CNN架构,以及[27]中由[19,28]启发的非常深的网络。与DeepFace相比,DeepID不使用3D脸部对齐,而是使用更简单的2D仿射对齐(如本文所述),并结合CelebFaces [25]和WDRef [4]进行训练。然而,[27]中的最终模型相当复杂,涉及大约200个CNN。

最近,Google [17]的研究人员使用了一个包含2亿个人脸身份和8亿个图像人脸对的庞大数据集来训练类似于[28]和[18]的CNN。不同之处在于他们使用“基于三重的”损失,其中一对两个一致的(a,b)和第三个不一致的脸c被比较。我们的目标是让a比c更接近b;换句话说,与其他度量学习方法不同,比较总是相对于“枢轴”面。这个匹配更接近于如何在应用程序中使用该度量,即当查询脸与其他脸的数据库进行比较以找到匹配的脸。在训练中,这种损失应用于多层,而不仅仅是最后一层。此方法目前在LFW和YTF上实现了最佳性能。

图1 我们数据集中的六个个体的实例图像

3.数据集

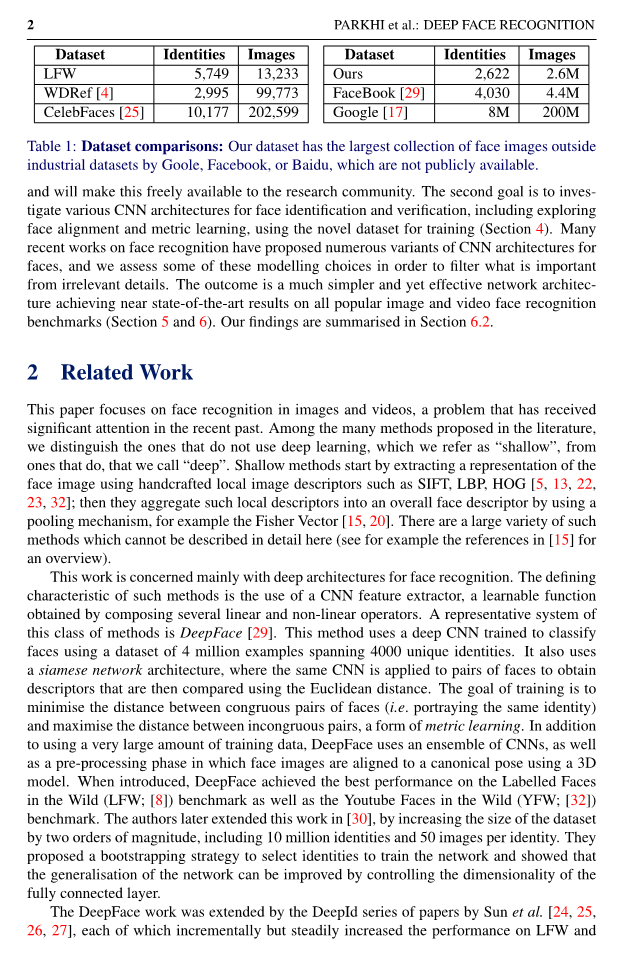

在本节中,我们提出了一个多阶段策略,以有效收集包含数千个独立身份的数百个示例图像的大型人脸数据集(表1)。表2总结了该过程的不同阶段和相应的统计数据。下面的段落详细讨论了各个阶段。

第一阶段:自举并过滤候选身份名称列表。构建数据集的第一步是获取用于获取人脸的候选身份的名称列表。这个想法是关注名人和公众人物,比如演员或政治家,这样就可以在网络上找到足够数量的不同图像,并且避免在下载图像时出现任何隐私问题。最初的公众人物名单是通过从互联网电影数据库(IMDB)名人名单中提取按热门程度排名的男性和女性中获得的。该列表主要包含演员,与Freebase知识图中的所有人相交[1],其中包含约500,000个不同身份的信息,从而产生2.5K男性和2.5K女性的排名列表。这形成了一个包含5000个很受欢迎的人的名字(来自IMDB)的候选名单,并且我们有属性信息,例如种族,年龄,亲属等(来自知识图)。选择总共5K张图片以使后续注释过程对于小型注释员团队来说可管理。

然后对候选列表进行过滤,以删除没有足够清晰图像的身份,并消除与标准基准数据集的任何重叠。为此,5000个名字名字中的每个名字都使用Google Image Search来下载200张图像。然后将200张图像呈现给人类注释者(按照四个组中的50个),以确定哪些身份导致足够的图像纯度。具体而言,只有当相应的一组200幅图像纯度大约为90%时,才会要求注释者保留其身份。缺乏纯度可能是由于同名或图像稀缺。此筛选步骤将候选列表缩减为3,250个身份。接下来,LFW和YTF数据集中出现的任何名称都将被删除,以便可以在新数据集上进行训练,并仍然在这些基准上进行公平评估。以这种方式,获得了最终的2,622名名人名单。

第二阶段:为每个身份收集更多图像。在谷歌和必应图片搜索中都会查询2,622个名人姓名,然后在将关键字“actor”添加到名称后再查询。这导致每个名称有四个查询,每个查询有500个结果,每个身份获得2,000个图像。

第三阶段通过自动过滤器提高纯度。这个阶段的目的是使用分类器自动删除每个集合中的任何错误的脸。为达到此目的,每个身份的前50张图片(基于下载列表中的谷歌搜索排名)被用作正面训练样本,所有其他身份的前50张图片被用作负面训练样本。使用Fisher Vector Faces描述符对每个身份训练一对多的线性支持向量机[15,20]。然后使用每个身份的线性SVM对该身份下载的2000张图像进行排名,并保留前1000张(为实现高精度在正面预测中选择1000的阈值)。

第四阶段:删除近乎重复的图片。提取出从两个不同的搜索引擎找到的相同图像产生的重复图像,或者在两个不同的互联网位置找到的相同图像的副本,将被删除。接近重复的图像(例如仅在色彩平衡方面不同的图像,或叠加文本的图像)也会被删除。这是通过计算每个图像的VLAD描述符[2,9],使用非常严格的阈值为1,000个图像中的每个标识对这些描述符进行聚类,并保留每个簇的单个元素。

第五阶段:最后的手动过滤。目前,这有2,622个身份,每个身份多达1,000个图像。这个最后阶段的目的是使用人类注释提高数据的纯度(精确度)。然而,为了减轻注释任务的负担,并且避免高注释成本,注释者通过再次使用自动排序器而得到帮助。然而这一次,一个多路CNN被训练使用[10]的AlexNet架构区分2,622个人脸身份,那么softmax分数用于通过降低作为内点的可能性来对每个标识集内的图像进行排序。为了加速注释者的工作,每个身份的排名图像以200个块显示,并且要求注释者将块作为整体进行验证。特别是,如果近似纯度大于95%,则块被宣布为良好。最终好的图像数量是982803个,其中大约95%是正面和5%的轮廓。

讨论:总的来说,使用互联网搜索引擎、现有人脸识别方法过滤数据以及有限手动管理的这些方法的组合能够产生准确的结果.

|

阶段 |

目标 |

类型 |

人数 |

每个人照片数 |

总的照片数 |

标记时间 |

识别率 |

|

|

|||||||

|

1 |

Candidate list generation |

A |

5,000 |

200 |

1,000,000 |

– |

– |

|

2 |

Image set expansion |

M |

2,622 |

2,000 |

5,244,000 |

4 days |

– |

|

3 |

Rank image sets |

A |

2,622 |

1,000 |

2,622,000 |

– |

96.90 |

|

4 |

Near dup. removal |

A |

2,622 |

623 |

1,635,159 |

– |

– |

|

5 |

Final manual filtering |

M |

2,622 |

375 |

982,803 |

10 days |

92.83 |

表2:每个处理阶段后的数据集统计。相当一部分收购过程是自动执行的。类型A和M指定处理阶段是自动执行还是手动执行。识别率值是针对CNN应用在LFW上的性能,在数据集的该阶段进行训练并使用l2距离进行

全文共11418字,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[15568],资料为PDF文档或Word文档,PDF文档可免费转换为Word