英语原文共 6 页,剩余内容已隐藏,支付完成后下载完整资料

理解卷积神经网络

一种手写数字识别的最小模型

摘要:本文的主要内容是弥补差距在理解数学结构和方法上使用最小模型(Minimal CNN)实现卷积神经网络(CNN)的计算。 建议使用分层方法呈现最小的CNN。 这个方法提供了简明易懂的理解CNN的主要数学运算。 因此,它的好处是初学者和非数学专业的学习者可以获得原则性理解的基础知识的CNNs没有一个学习的经验。 一个使用MNIST手写数字识别数据集用于实验验证最小的CNN与其他神经网络的性能。

关键词:卷积神经网络,深度学习,人工神经网络,人工智能,机器学习,手写数字识别,计算机视觉

- 介绍

近年来,卷积神经网络(CNN)在人工智能(AI)及其应用(对计算机愿景,具体)领域已经取得了重大成就。CNN是一种特殊类型的多层前馈人工神经网络,这是一种深入学习的技术,该技术已被广泛用于开发计算机视觉应用,自然语言处理,数据挖掘和计算机游戏[1],[2],[14]。卷积神经网络是多层的生物启发变体感知器神经网络(MLP)模仿人类视觉系统的多层视觉皮层。这个设计主要是由研究的动机,因此,接受场理论[7]和新识别模型[8]允许CNN学习视觉特征的多级层次结构从图像更好的比其他计算机视觉技术[2],[5],[14]。最近,CNN已经成为一个有用的工具开发商业计算机视觉应用程序识别图像对象,识别图片中的人脸,道路自动驾驶汽车,手写字符的标志识别识别,视频监控和其他视觉任务[14]。

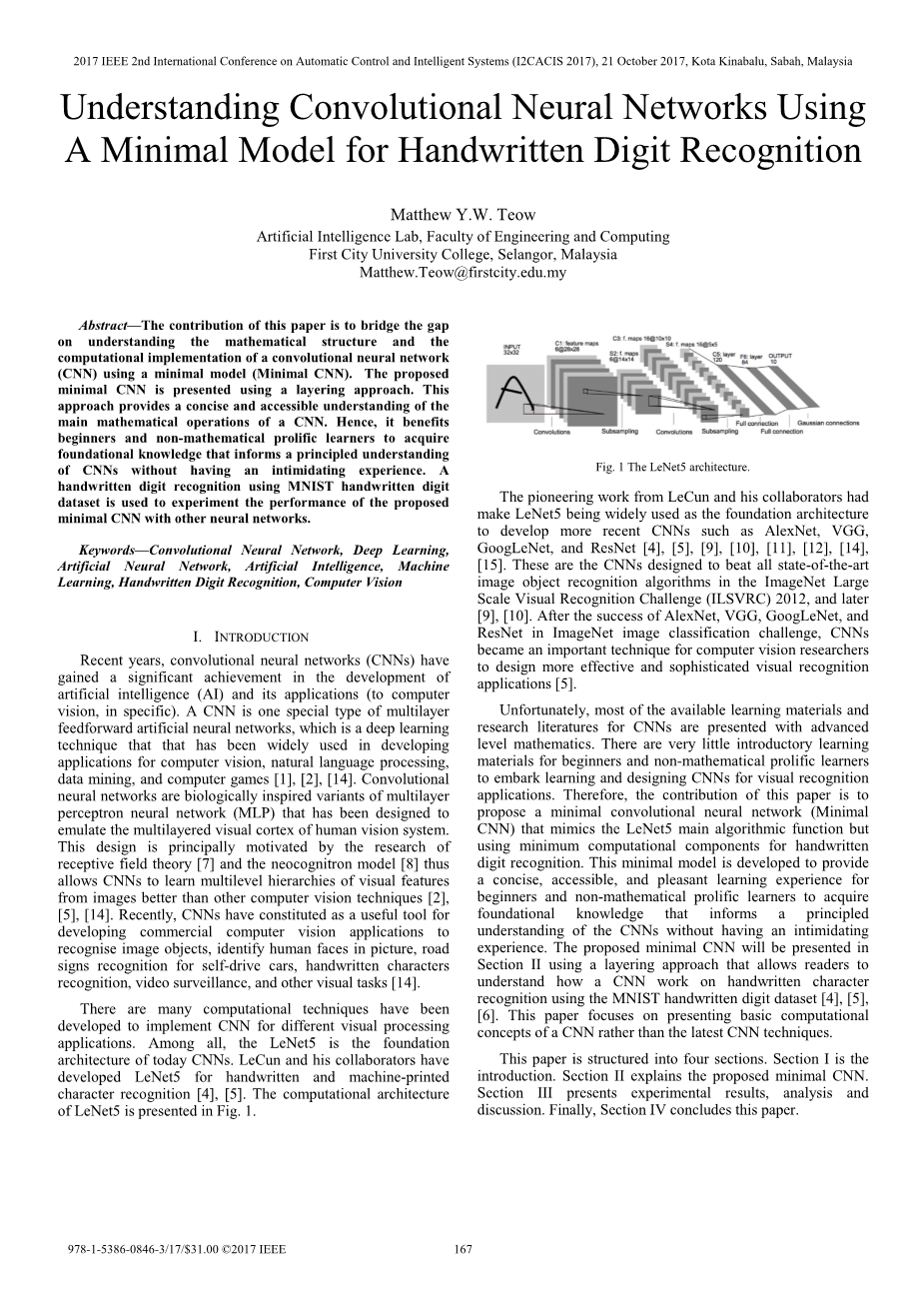

有许多计算技术用于实现不同视觉处理的CNN开发应用。 其中,LeNet5是CNN架构的基础。 乐村和他的合作者都有开发了用于手写和机器打印的LeNet5字符识别[4],[5]。 计算体系结构的LeNet5在图1中给出。

乐村和他的合作者的开创性工作使LeNet5架构被广泛用作开发更新的CNN的基础,如AlexNet,VGG,GoogLeNet和ResNet [4],[5],[9],[10],[11],[12],[14],[15]。 这些CNN旨在打败所有最先进的技术。ImageNet Large中的图像对象识别算法缩放视觉识别挑战(ILSVRC)2012及更高版本[9],[10]。 AlexNet,VGG,GoogLeNet和ResNet在ImageNet挑战图像分类,CNNs成为计算机视觉研究人员设计更有效和成熟的视觉识别应用的重要技术 [5]。

不幸的是,大多数可用的学习资料和为CNNs的研究文献提供了先进的高等数学。有很少的入门学习材料供给为初学者和非数学专业的学习者学习和设计视觉识别CNNs应用。因此,本文的贡献在于提出一个最小卷积神经网络(MinimalCNN),它模仿LeNet5的主要算法功能,但是使用最小的手写计算组件数字识别。这个最小的模型被开发提供一个简洁,方便,愉快的学习体验初学者和非数学专业的学习者获得通用性的基础知识对CNN的理解没有困难的经验。拟议的最小CNN将在英国提交,第二部分使用分层方法,使读者了解CNN如何在手写字符上工作,使用MNIST手写数字数据集进行识别[4],[5],[6]。本文着重介绍基本的计算CNN的概念,而不是最新的CNN技术。

本文分为四个部分。 第一部分是介绍。 第二节解释了提议的最小CNN。第三节介绍了实验结果,分析和讨论。 最后,第四节总结本文。

II 一个极小卷积神经网络

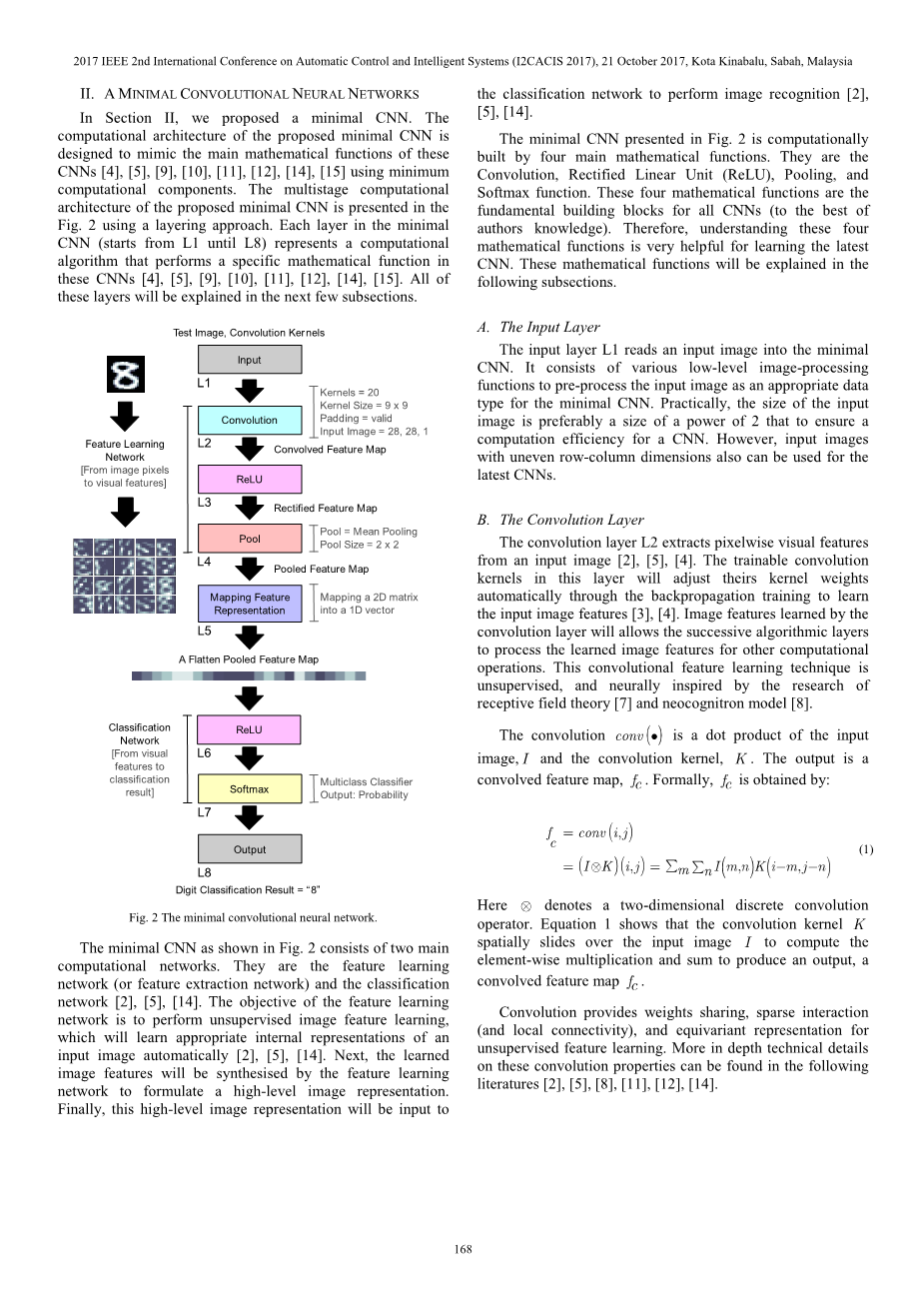

在第二节中,我们提出了一个最小的CNN。提出的最小CNN的计算架构是旨在模仿这些CNNs计算组件的主要数学功能[4],[5],[9],[10],[11],[12],[14],[15]。 多级计算所用的最小CNN的体系结构被提出,图2使用分层方法。 这些最小CNN的每层CNN(从L1开始直到L8)代表一个计算算法,执行一个特定的数学函数[4],[5],[9],[10],[11],[12],[14],[15]。 所有的这些层将在接下来的几节中进行解释。

如图2所示的最小CNN计算网络由两个主要部分组成。 他们是特征学习网络(或特征提取网络)和分类网络[2],[5],[14]。 特征学习的目标网络将执行无监督的图像特征学习。

这将学习适当的在内部自动输入图像[2],[5],[14]。 接下来,学到了图像特征将由特征学习合成网络来制定高级图像表示。最后,这个高层次的图像表示将被输入到分类网络进行图像识别[2],[5],[14]。

图2中呈现的最小CNN的计算是由四个主要数学函数构建。 他们是卷积,整流线性单元(ReLU),汇集和Softmax功能。 这四个数学函数是所有有线电视新闻网的基本组成部分(尽力而为)作者知识)。 所以理解这四个数学函数对学习最新数据非常有帮助CNN。 这些数学函将在以下小节解释。

- 输入层

输入层L1将输入图像读入最小值CNN。 它由各种低级图像处理组成用于预处理输入图像作为适当的数据输入最小的CNN。 实际上,输入的大小图像优先选择的是2的幂的大小以确保aCNN的计算效率。 但是,输入图像具有不均匀的行列尺寸也可以用于最新的CNN。

B.卷积层

卷积层L2从输入图像提取像素视觉特征 [2],[5],[4]。 该层中的可训练的卷积内核将调整其内核权重自动通过反向传播培训来学习输入图像特征[3],[4]。 图像特征了解到

卷积层将允许连续的算法层为其他计算处理学习的图像特征操作。 这种卷积特征学习技术是无监督,神经灵感的研究接受场理论[7]和新识别模型[8]。

ntilde;Gntilde;卷积是输入的点积图像和卷积核心。 输出是一个卷积特征映射。 形式上,通过以下方式获得:

这里表示一个二维离散卷积。 等式1显示了卷积核在输入图像上空间滑动以计算输入图像元素方式的乘法和和来产生输出,一个卷积特征映射。

卷积提供权重分享,稀疏交互(和本地连通性)以及权值表示无监督的特征学习。 关于这些卷积属性更深入的技术细节可以在下面文献找到 [2],[5],[8],[11],[12],[14]。

C. ReLU层

ReLU代表整流线性单位。 这是一个非线性激活函数[2],[5]。 ReLU的目标层L3和L6将为a引入一个点向非线性

CNN,它允许CNN非线性输入函数有学习的能力。 ReLU也被证明是解决消失梯度问题的一个有效的解决方案。

使用反向传播算法训练CNN [3],[4]。

ReLU函数的数学结构是一个具有最大输出的分段非线性算子指示性功能[2],[5]。 一个ReLU的输出是纠正的功能图,由以下给出:

公式2对于负输入和线性传输有积极地影响。

D.合并层

池层L4的目标是对二进制样本进行二次采样,纠正特征图以减小其空间维度,从而产生更紧凑的特征表示[2],[5],[13],[14]。 池层的输出是一个池特征图。 最大池和平均池是两种广泛使用的池技术[13]。 在本文中,意思是说汇集用于提议的最小CNN。在数学上,定义了平均池功能如:

图3说明了平均池的操作功能。 输入图像矩阵是作为一组分割的脱节的部分,他们正在“平均水池”形成一个输出图像矩阵。 计算上,“平均水池”意味着计算输入特征映射的平均值不相交区域,然后将此值存储到输出特征映射中。

另一个计算目标是“均值池”输入特征映射用于特征收缩。 它产生更多输入特征映射的紧凑表示(这里,到整形的特征地图),此减少了网络维度,计算时间和学习参数用于培训CNN [2],[14]。 在数学上,池是一个非可逆函数[13]。

E.特征映射表示层

特征映射表示层L5的功能是从二维矩阵重新映射合并的特征映射成一维矢量。 L5的输出是一个“平坦”汇集的功能地图。 这是一个数据准备层分类网络(参见图2)。

F. Softmax层

L7是softmax功能,。 这是一个多类逻辑分类器[2],[5],[14]。 概率输出softmax函数的计算公式如下:

公式的输出 4是一个热门的概率分布,其中包含[0,1]范围内的实际值,为1来表示不同的概率类。 在本文中,最小的CNN被训练来进行分类MNIST手写数字从“0”到“9”,从而输出有10个分类类,其中。 根据公式如图4所示,具有最高概率值的数字图像是被认为是正确的输出。

G.输出层

输出层L8给定的分类结果由softmax功能呈现。

H.训练最小卷积神经网络

我们使用监督式训练训练了最小的CNN。培训使用小批量梯度的形式进行,降低期望的学习错误输出和实际输出。 计算梯度使用反向传播算法。 所有的网络参数并且训练系数由反向传播更新学习方法。 学习率和动力已经确定分别为0.01和0.95。 本文的重点是解释CNN的前馈模型,从而培训CNN在本文中不会进一步解释。 读者想知道进一步的细节培训CNN和网络超参数优化的方法可以研究以下文献[3],[4],[5],[6],[11],[12],[14],[15]。

III 实验分析与讨论

在第三节中,我们想介绍一下实验分析和结果讨论提出的最小CNN使用修改后的国家标准与技术研究所技术承认(MNIST)手写数字数据集。 乐村和他的合作者开发了这个数据集,目的是评估他们的LeNet模型手写数字识别问题[4],[5],[6]。该MNIST数据集由70,000个不同的手写数字组成图像,其中60,000数字图像用于训练,和10,000数字图像用于测试。 每个数字图像分辨率是像素。 他们是黑白的图片。 它还包括每个数字图像的标签,告诉我们它是哪个数字。 有关MNIST的更多信息手写数字数据集可以参考[4],[5],[6]。 图4显示数据集样本。

本节分为两个小节。 第一提出了对特征学习能力的分析通过特征映射可视化和最小化CNN讨论。 第二小节讨论MNIST最小的CNN与其他神经网络相比手写数字识别性能。

A.分析和可视化特征映射

在第A小节中,对功能图进行了系统分析被呈现。 我们为什么要分析这些特征地图?因为这些特征图显示了神经元激活在最小CNN中的每个隐藏层(从L2到L5为止)如图2所示)。 这种分析使我们能够理解最小的CNN如何学习(或提取)视觉特征从输入图像[2],[5],[8],[14]。 我们已经预制亮度标准化在这个所有的实验图像为了更好的视觉检查。 对于所有的实验图像,像素值也被归一化为一个范围[-1, 1]。 黑色像素是负像素的地方值,白色像素是正值的像素,而灰色像素是具有零的像素。

首先,如图2所示,前两个输入参数L1是输入图像和一组卷积核。如图5所示的一个数字“8”图像从该图像采样MNIST数据集追踪数据流(特征图)和最小CNN的计算序列。

其次,一组可训练的卷积核与一个内核大小和随机初始权值被输入到L1连同数字“8”输入图像,如图2所示。可训练的卷积核意味着a的内核权重卷积核不是预定的。 他们会在反向传播训练中学习。 一个例子历元= 3之后的卷积核(第三次训练之后)如图6(a)所示。

第三,卷积层(L2)执行特征通过将输入图像原始像素转换为提取像素视觉特征因此产生一组特征输入图像的表示称为卷积功能地图。 得到的卷积特征映射是如图6(b)所示。

图6(b)显示了卷积特征映射捕获数字“8”输入的学习图像对象视觉特征图片。 这些学习功能编码边缘和其他图像原始结构,制定一个分层和可解释的输入图像表示。 因此,我们可以抽象地识别出可识别的数字“8”如图6(b)所示的卷积特征映射。

图6(b)要注意的另一个重要的观察是卷积核被训练以提取可学习的内容具有空间取向的像素视觉特征(Gabor特征)。 为了证明,一些卷积核心训练后epoch = 3以及它们各自的特征提取方向如图7所示。

以下总结了其他重要的观察结果对于如图6(a),6(b)和7所示的卷积核。

bull;他们代表本地接受领域提取本地化输入图像像素视觉特征。

bull;内核大小在空间上是有界的,因此它提供了紧凑的支持仅检测局部像素对小几何变化不变的特征。

bull;这些卷积核已经用各种计算要检测最大可能的特征方向来自输入图像的按像素视觉特征。

第四,卷积特征地图将被纠正ReLU激活功能(图2中的L3)。 等式2描述ReLU将替换卷积中的所有负值像素具有“零”的特征映射从而产生只包含“零”和正值的输出矫正特征图如图8(a)所示。 ReLU操作的目标是从卷积中获得有效的特征表示用于后续特征识别的特征映射由分类网络执行。

检查图8(a),我们可以观察到那些黑色卷积区域(像素为负值的区域)特征图(图6(b))已经是阈值并被设置为“零”。只有具有正值的像素(白色区域)才会被保留形成修正的特征图。 因此,ReLU操作纠正数字“8”图像的像素视觉特征卷积特征映射(图6(b))转换为整形特征图(图8(a))仅具有有效的像素视觉特征保留。 在数学上,我们认为“有效的像素视觉特征“是具有正值的像素,如由其定义的式。 2.该操作也被认为是引入非线性入卷积特征映射的光滑图像表面作为卷积中的邻域像素连接特征映射将被ReLU非线性破坏。

最后,图2中的汇集层L4执行“均值”池“添加到修正的特征映射中,从而输出池化特征如图8(b)所示。 汇集的目标是将学习的图像视觉特征编码为更紧凑表示。 这种紧凑的表示允许空间降维因此产生空间收缩使几何平移不变成图像空间。这有助于提高识别的准确性分类网络[2],[3],[5],[13],[14]。

图8(b)也显示了池化操作没有改变学习图像视觉的空间几何表示,数字“8”仍然可以清楚从汇总的功能图中识别。

总之,图9提供了一个清晰的图画展示特征学习网络如何提取视觉特征从输入的数字“8”图像产生像素视觉可以由分类使用的特征表示网络来执行数字识别。

B. MNIST手写数字识别精度

本节介绍MNIST手写数字最小CNN的识别性能分析与Le

全文共9413字,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[14239],资料为PDF文档或Word文档,PDF文档可免费转换为Word