英语原文共 14 页,剩余内容已隐藏,支付完成后下载完整资料

基于对象-局部关注区的细粒度图像分类模型

摘要:细粒度图像分类是识别属于同一基本类别的数百个子类别,例如属于鸟类的200个子类别,由于同一子类别的差异较大且不同子类别之间的差异较小,因此具有高度挑战性。现有方法通常首先定位对象或部分,然后区分图像属于哪个子类别。但是,它们主要有两个局限性:(1)依赖于耗费大量劳动力的对象或部分注释。 (2)忽略物体与其各部分之间以及这些部分之间的空间关系,这两者对于找到有辨别力的部分都非常有帮助。因此,本文提出了弱监督细粒度图像分类的对象关注模型(OPAM),主要的新颖性是:(1)对象关注模型集成了两个层次的关注:对象层次关注定位图像对象,部分 - 级别注意选择对象的判别部分。两者共同用于学习多视图和多尺度功能,以增强他们的相互促销。 (2)对象部分空间约束模型结合了两个空间约束:对象空间约束确保选定部分具有高度代表性,部分空间约束消除冗余并增强对所选部分的区分。两者共同用于利用细微和局部差异来区分子类别。重要的是,在我们提出的方法中既没有使用对象也没有使用部分注释,这避免了标签的大量劳动力消耗。与4种广泛使用的数据集中的10种以上最先进的方法相比,我们的OPAM方法实现了最佳性能。

关键词:细粒度图像分类,对象部分关注模型,对象部分空间约束模型,弱监督学习。

1引言

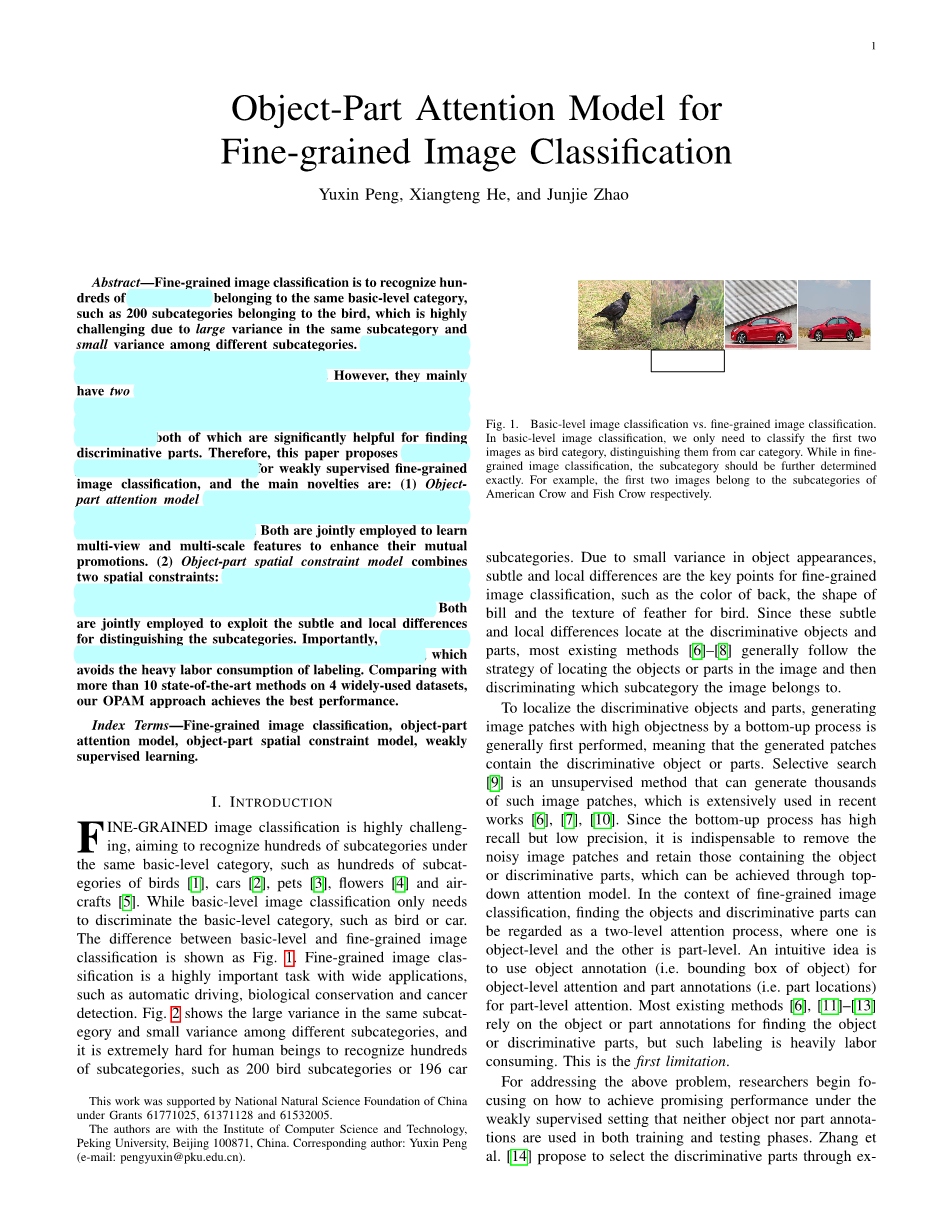

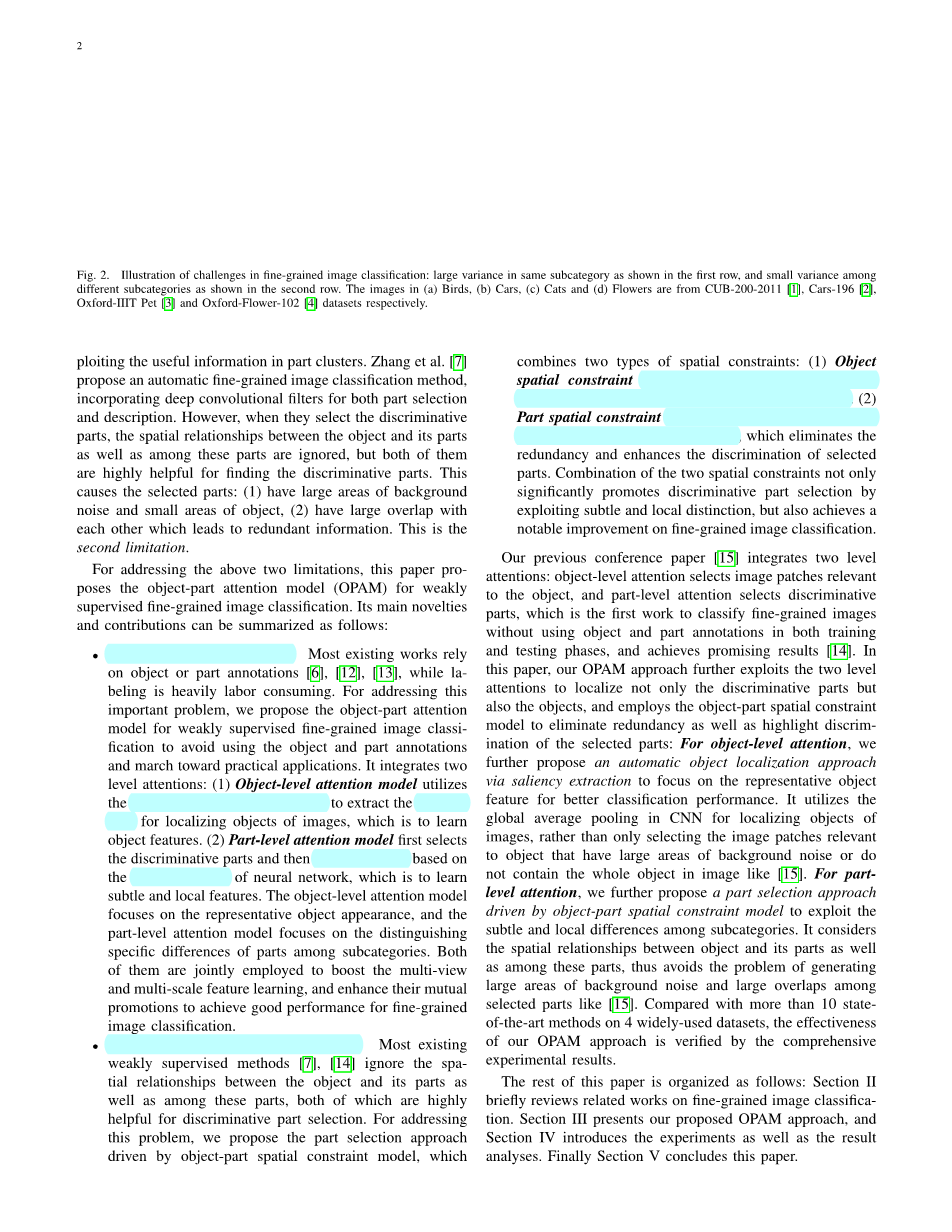

细粒度图像分类极具挑战性,旨在识别相同基本类别下的数百个子类别,例如数百个鸟类,汽车,宠物,花卉和航空工艺品。虽然基本级别的图像分类只需要区分基本级别的类别,例如鸟或汽车。基本级和细粒度图像分类之间的差异如图1所示。细粒度图像分类是一个非常重要的任务,如自动驾驶,生物保护和癌症检测等。图2显示了相同子类别中的大方差和不同子类别之间的小方差,并且人类极难识别数百个子类别,例如200个鸟类别或196个汽车子类别。由于物体外观的微小差异,细微和局部的差异是细粒度图像分类的关键点,例如背部的颜色,纸币的形状和鸟的羽毛纹理。由于这些细微和局部差异位于判别对象和部分,因此大多数现有方法通常遵循定位图像中的对象或部分然后区分图像属于哪个子类别的策略。

为了定位判别对象和部分,通常首先执行通过自下而上过程生成具有高无物体的图像补丁,这意味着生成的补丁包含一个或多个判别对象。选择性搜索是一种无监督的方法,可以生成数千个这样的图像块,在最近的工作中被广泛使用。由于自下而上的过程具有高回忆率但是精度低,因此必须去除噪声图像块并保留包含对象或辨别部分的图像,这可以通过自上而下的注意模型来实现。在细粒度图像分类的上下文中,找到对象和判别部分可以被视为两级关注过程,其中一个是对象级别而另一个是部分级别。直观的想法是使用对象注释(即,对象的边界框)用于对象级注意和部分注释(即,部分位置)以用于部分级注意。大多数现有的方法,关于找到反对者或歧视性部分的对象或部分注释,但这种标记是非常耗费人力的。这是第一个限制。

为了解决上述问题,研究人员开始关注如何在弱监督环境下实现有希望的性能,即在训练和测试阶段都不使用对象或部分注释。张等人。 [[4]建议通过利用部分集群中的有用信息来选择判别部分。张等人。 [7]提出了一种自动细粒度图像分类方法,结合深度卷积滤波器用于部件选择和描述。然而,当他们选择辨别部分时,对象及其部分之间以及这些部分之间的空间关系被忽略,但是它们都非常有助于找到辨别部分。这导致所选择的部分:(1)具有大面积的背景噪声和小的物体区域,(2)彼此具有大的重叠,这导致冗余信息。这是第二个限制。

为了解决上述两个局限性,本文提出了弱监督细粒度图像分类的对象 - 部分关注模型(OPAM)。其主要的新颖性和贡献可归纳如下:

对象 - 部分注意模型。大多数现有的作品依赖于对象或部分注释,而标签则耗费大量人力。为了解决这个重要问题,我们提出了弱监督细粒度图像分类的对象 - 部分关注模型,以避免使用对象和部分注释,并向实际应用迈进。它集成了两个层次的注意事项:(1)对象级关注模型利用CNN中的全局平均池来提取用于定位图像对象的显着性图,即学习对象特征。 (2)部分关注模型首先选择判别部分,然后根据神经网络的聚类模式对齐部分,即学习细微和局部特征。对象级关注模型侧重于代表性对象外观,而部分级关注模型侧重于区分子类别之间部分的特定差异。它们共同用于促进多视图和多尺度特征学习,并增强它们的相互促销以实现细粒度图像分类的良好性能。

对象 - 局部空间约束模型。大多数现有的弱监督方法忽略了对象及其部分之间以及这些部分之间的空间关系,这两者对于判别部分选择都非常有用。为了解决这个问题,我们提出了由对象部分空间约束模型驱动的部分选择方法,它结合了两种类型的空间约束:(1)对象空间约束强制所选部分位于对象区域并具有高度代表性。 (2)部分空间约束减少了部件之间的重叠并突出了部件的显着性,这消除了冗余并增强了对所选部件的区分。两种空间约束的结合不仅通过利用细微和局部区分显着地促进了判别部分的选择,而且在细粒度图像分类方面也实现了显着的改进。

我们之前的会议论文集成了两个层面的注意事项:对象级关注选择与对象相关的图像补丁,而部分关注选择判别部分,这是首次对细粒度图像进行分类而不使用对象和部分注释的工作在培训和测试阶段,并取得了可喜的成果。在本文中,我们的OPAM方法进一步利用了两个层面的注意力,不仅定位了判别部分而且定位了对象,并采用了对象部分空间约束模型来消除冗余以及突出所选部分的区分:对于对象 - 在关注度上,我们进一步提出了一种自动对象定位方法的显着性提取,重点关注代表性对象特征,以获得更好的分类性它利用CNN中的全局平均合并来定位图像对象,而不是仅选择与具有大面积背景噪声的对象相关的图像块,或者不包含图像中的整个对象,如T5]。对于部分级别的关注,我们进一步提出了由对象 - 部分空间约束模型驱动的部分选择方法,以利用子类别之间的细微和局部差异。它考虑了物体与其各部分之间以及这些部分之间的空间关系,从而避免了产生大面积背景噪声和选定部分之间的大量重叠的问题。与4种广泛使用的数据集中的10种以上最先进的方法相比,我们的OPAM方法的有效性得到了综合实验结果的验证。

本文的其余部分安排如下:第一部分简要回顾了有关细粒度图像分类的相关工作。第二节介绍了我们提出的OPAM方法,第四节介绍了实验和结果分析。最后,第五节总结了本文。

2相关工作

大多数传统的细粒度图像分类方法遵循提取基本低级描述符(如SIFT)的策略,然后生成用于图像表示的词袋。但是,这些方法的性能受到手工制作功能的限制。深度学习在特征学习方面表现出强大的力量,并在细粒度图像分类方面取得了很大进展。这些方法可以分为三组:基于网络的方法集合,基于视觉注意的方法和基于部分检测的方法。

A.基于网络的方法的集合

提出了基于网络的方法的集合以利用多个神经网络来学习图像的不同表示以获得更好的分类性能。每个子类别在其本体树中隐含了标签层次结构。例如,Picoides Pubescens是物种水平的标签,其属性水平的标签为Picoides,家族水平为Picidaelig;。王等人首先利用多个级别的标签来训练每个级别的一系列CNN,其关注于图像中的不同感兴趣区域。不同级别的CNN提取不同的特征,并且组合以编码信息性和判别性特征。最后,训练线性SVM以学习最终分类的权重。然而,本体树的外部标签对于的方法是必要的。林等人提出双线性CNN模型,这是一个联合组合两个CNN的端到端系统,每个CNN都被用作特征提取器。来自两个CNN的提取的特征坐在图像的每个位置上乘以外部产品操作,然后合并以生成图像描述符。最后,SoftMax用于最终预测。尽管取得了有希望的结果,但这些方法仍然受到缺乏对输入图像在空间上不变的能力的限制。因此,Jaderberg等人提出了一个可学习的网络,称为空间变换器,它由三部分组成:定位网络,网格生成器和采样器。在图像上执行并行的四个空间变换器,并捕获辨别部分以传递到部分描述子网。最后,在连接的部分描述符上进行SoftMax以进行最终预测。

B.基于视觉注意的方法

由于注意系统,人们动态地关注图像的判别区域,而不是直接接收和处理整个图像的信息。这种自然优势使得注意机制广泛用于细粒度图像分类。灵感来自于人类如何进行视觉序列识别,Semantical提出了细粒度分类(AFGC)系统的关注。首先,它们在输入图像上处理多分辨率裁剪,其中每个裁剪称为一瞥。然后他们使用瞥见信息在每一步通过深度递归神经网络输出下一个位置和下一个对象。通过一瞥序列计算最终预测。最近,完全卷积神经网络用于学习图像的显着性,以找到判别区域。刘等人使用完全卷积关注来定位多个部分以获得更好的分类性能。谢等人提出了一种名为Interactive的新算法,它可以计算神经元和网络的活跃度(注意力)。连接,说高级环境以及提高低级和中级神经元的描述能力,从而在图像分类方面取得了良好的性能。周等人使用CNN中的全局平均合并(GAP)来生成每个图像的显着性图。基于显着性图,可以找到判别区域。此外,提出了一种多样化的视觉注意网络(DVAN)来追求注意力的多样性以及收集判别信息。在本文中,我们的OPAM方法集成了两个级别的关注模型:对象级关注模式1关注代表性对象外观,而部分关注模型关注于判别部分。他们两人共同学习多视图和多尺度功能,以加强他们的相互促进。

C.基于零件检测的方法

在细粒度图像分类中,细微差异和局部差异通常位于对象的判别部分,因此判别部分检测对于细粒度图像分类至关重要。 Girshick等提出了一种流行的检测方法R-CNN,它首先通过自下而上的过程为每个图像生成数千个候选图像块[9],然后选择具有高分类分数的图像块作为检测结果。张等人。图6利用具有几何形状的R.CNN来检测用于细粒度图像分类的判别部分,然后训练关于检测到的部分的特征的分类器以用于最终分类。它们同时使用对象和部分注释。

最近,研究人员开始关注如何在弱监督下检测判别部分,这意味着在训练和测试阶段都不使用对象或部分注释。 Simon和Rodner提出了一种星座模型来定位物体的各个部分,利用CNN来寻找神经激活模式的星座。首先,通过使用CNN的中间层的输出来计算神经激活图作为部分检测器。其次,通过星座模型选择部分检测器来估计零件模型。最后,零件模型用于提取分类特征。张等人我建议自动罚款。粒度图像分类方法,结合深度卷积滤波器用于部件选择和描述。它们结合了深度滤波器响应拾取的两个步骤:第一步选择显着响应图像中特定部分的判别滤波器。第二步选择显着区域,并根据分类的显着性图谱生成具有空间加权Fisher矢量的特征Zhang 等人建议通过利用部分集群中的有用信息来选择歧视性部分。在我们的OPAM方法中,我们首先提出了一个对象 - 部分空间约束模型来选择判别部分,它考虑了对象及其部分之间以及这些部分之间的空间关系,然后利用神经网络的聚类模式来对齐部分。具有相同的语义含义,以提高分类性能。

3我们的OPAM方法

我们的方法基于一个直观的想法:细粒度图像分类通常首先定位对象(对象级注意),然后是区分部分(部分级注意)。例如,识别包含Field Sparrow的图像遵循首先找到鸟的过程,然后关注区别于其他鸟子类别的判别部分。我们提出了弱监督细粒度图像分类的对象 - 部分关注模型,它既不使用对象也不使用部分注释训练和测试阶段,并且仅使用图像级子类别标签。如图所示,OPAM方法首先通过对象级注意模式1对图像对象进行定位,以学习对象特征,然后通过部分关注模型选择判别部分,以学习细微和局部特征。在以下小节中,分别给出了对象级和部分级关注模型。

A.对象级注意模型

大多数现有的弱监督工作对判别部分选择进行反投票,但忽略了物体定位,这可以消除图像中背景噪声的影响,以学习有意义和有代表性的物体特征。虽然有些方法可以考虑对象定位和部分选择都依赖于对象和部分符号。为了解决这个重要问题,我们提出了一种基于显着性提取的对象级关注模型,用于定位图像对象仅自动使用图像级子类别标签,没有任何对象或部分注释。该模型由两个部分组成:补丁过滤和显着性提取。第一个组件是过滤掉噪声图像补丁并保留与对象相关的那些用于训练CNN称为ClassNet,用于学习特定子类别的多视图和多尺度特征。第二个组件是通过全局平均池来提取显着性图在CNN中用于本地化图像对象。

1)补丁过滤:大量的训练数据对于CNN的性能具有重要意义,因此我们首先关注如何扩展训练数据自下而上的过程可以通过将像素分组到可能包含的区域来生成数千个候选图像补丁物体。由于它们与对象的相关性,这些图像块可以用作训练数据的扩展。因此,采用选择性搜索[9]来生成给定图像的候选图像块,这是一种无监督且广泛使用的自下而上的处理方法。这些候选图像块提供原始图像的多个视图和比例,这有利于训练有效的CNN以实现更好的细粒度图像分类准确性。然而,由于高召回率但低精度,这些贴片不能直接使用,这意味着存在一些噪声。对象级注意模型非常有助于选择与对象相关的补丁。

我们删除嘈杂的补丁并通过名为FiherNet的CNN选择相关补丁,这是在ImageNet数据集上预先训练的,然后很好。调整了训练数据。我们将属于输入图像的子类别的SoftMax层中的神经元的激活定义为选择置信度得分,然后设置阈值以确定是否应该选择给定的候选图像块。然后我们获得与具有多个视图和比例的对象相关的图像块。培训数据的扩展提高了ClassNet的培训效果,这对我们的OPAM方法有两个好处:(1)ClassNet本身就是一种有效的细粒度图像分类器。 (2)它的内部特征对于构建用于将具有相同语义的部分对齐在一起的部分集群非常有帮助,这将在后面的子部分B中进行描述。应注意,补丁过滤仅在训练阶段执行并且仅使用图像级子类别标签。

2)显着性提取:在该阶段,采用CAM [

全文共14905字,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[135],资料为PDF文档或Word文档,PDF文档可免费转换为Word

您可能感兴趣的文章

- GIS矢量地图的鲁棒水印方案外文翻译资料

- 中国相似地理位置发达地区房价影响因素的差异——以西安高新区和沣渭新区为例外文翻译资料

- 集成数据在城市土地利用变化时空动态监测的应用——以印度金奈都市为例外文翻译资料

- 全球地表水及其长期变化的高分辨率制图外文翻译资料

- 造成沿海大型城市内涝灾害的主要因素识别——以中国广州为例外文翻译资料

- 基于SFPHD框架的中国快速城市化地区城市生态系统健康综合评价方法外文翻译资料

- 基于绿地演变的未来城市地表热岛强度的多情景模拟预测外文翻译资料

- 中国大陆272个城市地面和冠层城市热岛强度的长期趋势外文翻译资料

- 与孟加拉湾热带气旋有关的中国低纬度高原远距离降雨事件外文翻译资料

- 新丰江水库流域GPM IMERG降水产品评价及水文效用研究外文翻译资料