英语原文共 10 页,剩余内容已隐藏,支付完成后下载完整资料

基于学习的船舶设计优化方法

摘要

随着计算机在船舶设计中应用的发展,优化作为一种强有力的手段,在船舶设计分析过程中得到了广泛的应用。然而,在当前的计算环境中,运行时间往往从几个星期到几个月不等一直是优化应用的瓶颈问题,尤其是在船舶的结构设计中。为了加快优化过程,调整复杂的设计环境,船舶设计人员通常依靠自己的经验来辅助设计工作。然而,这在很大程度上依赖于设计师个人技能的传统体验往往使设计质量对经验非常敏感,降低了最终设计的稳健性。本文提出了一种新的基于机器学习的船舶设计优化方法,将机器学习作为指导优化的有效工具,提高了优化对动态设计环境的适应性。在优化过程中引入了自然人的学习过程,提高了算法的效率。Q-学习作为强化学习的一种方法,在优化过程中被用来实现学习功能。利用多目标粒子群优化方法、多智能体系统和CAE软件构建了一个完整的优化系统。以某散货船结构设计优化为例,对该方法在实际应用中的适用性进行了评价。

关键词:机器学习;船舶设计结构优化;结构分析;多目标优化

1.绪论

船舶设计是一个复杂的、分布式的过程,随着计算机应用在船舶设计中的不断发展,优化在这一过程中起着重要的作用。在船舶结构设计和分析中,优化一直是一个特别有效的工具,然而,船舶结构优化所需的时间往往从几个星期持续到几个月,一直是实际应用中的一个瓶颈问题。设计者总是尽量减少运行时,加快优化的收敛速度。最常见的方法之一是利用设计者的经验来协助优化。然而,专家的经验和技能过于依赖个人能力,这意味着设计过程将变得非常敏感,设计质量无法得到保证。同时,在整个设计过程中,设计条件和变量往往会发生动态变化,从而使设计非常不稳定。

本文提出了一种新的基于机器学习的船舶优化设计方法,将人的学习过程引入到实际的船舶设计与分析中,以提高优化的效率。强化学习作为一种重要的机器学习方法,以其良好的实时学习性能,解决了感官记忆和部分短时记忆问题。Q-学习作为强化学习的一种具体方法,在本研究中是通过一个多代理系统来选择和实现的。该方法通过经验学习指导优化方向,有助于系统进一步调整船舶设计环境。该方法在一个实际的散货船结构设计案例中得到了验证。本文首先介绍了本文的工作,然后介绍了优化在船舶设计和结构分析中的应用背景。第三节介绍了一种基于学习的船舶优化方法,并简要介绍了人的学习理论。第四节重点介绍了该方法在船舶结构设计中的应用,并在第五节中讨论了该方法的优缺点。

2.背景

由于船舶设计的复杂性和动态性,海军建筑师试图采用多种可靠和自适应的方法来辅助设计工作,以提高设计质量。随着CAD和CAE技术在计算机科学领域的发展,无论是提高船舶的性能,还是在满足规章制度要求的同时获得更好的经济效益,优化都变得越来越重要。20世纪60年代,计算机辅助船舶设计的概念开始出现,使计算机在船舶设计中发挥着越来越重要的作用。随着计算机辅助船舶设计的迅速普及和发展,这已成为船舶设计的一个重要研究方向。这些优化方法是有效的工具,大大降低了设计工作的复杂性,提高了最终解决方案的质量。根据已有的研究成果,MOGA(多目标遗传算法)是一种启发式方法,是解决复杂船舶设计优化问题的一种很有前途的方法。

雷和沙结合了公认的海军建筑设计方法、决策系统处理程序、非线性优化工具和集装箱船模型。雷等人也提供了部分离散优化模型、全局优化模型和人工神经网络在船舶设计中的应用。提出了一种进行监督训练的BP网络模型,并给出了实现方法的神经网络结构。托马斯使用帕累托排序、MOGA和NPGA来研究全尾桨潜艇的可行性。考虑了三个目标:最大容积容积、管道推进器潜艇功率系数的最小值和空化指数的最小化。使用二进制表示和不同的选择技术。托马斯还对几种不同的算法进行了比较,得出结论:MOGA在所有方面都优于其他方法。布朗和托马斯使用GA与帕累托排名海军舰船概念设计。考虑了两个目标:总体有效性度量的最大化(该因素代表客户需求,并将船舶性能指标与任务有效性联系起来)和生命周期成本最小化。采用随机抽样的二元表示法和轮盘赌选择法。布朗和萨尔塞多和布朗和迈尔-祖维基在舰船设计中引入了多目标遗传算法。托德和森使用了MOGA的变体用于集装箱船布局的预先规划(一个大规模的组合问题)。首先考虑四个目标:集装箱接近的最大化、横向重心的微型化、垂直重心的最小化和卸载最小化,使用基于非优势的精英化的二元表示和轮盘选择。他们使用相同的算法对造船厂的切割车间问题。再考虑两个目标:最大完工时间的最小化和总惩罚成本的最小化。雷等人提出了一般多目标设计优化问题的演化算法。该算法基于OB空间和约束空间中的解的非支配性,并利用有效的匹配框架GES来改进任一空间中较弱的解。雷和蔡在单目标和多目标优化中应用了一种用于翼型形状优化的群算法。提出的群集算法是基于社会行为模型,并使用三个不同的翼型设计作为案例研究。佩里和坎帕纳提出了一种多学科设计优化的海军水面战斗员,并开发了高保真度模型和多目标全局优化算法在基于仿真的设计。为了解决船舶设计和航运中的多目标优化问题,本文提出了一种混合方法。在他的研究中,软件“模型边界”被用来通过MOGA进行优化。布鲁古里斯和帕帕尼古拉乌引入了一个浮动LNG终端的多目标优化,并利用MOGA的软件“模型前沿”。平托等。提出了一种确定多粒子群算法的确定方法,并将该方法应用于集装箱船多目标(2目标)的海防问题。崔和图兰提出了一种新的多粒子群优化算法HCPO,并将其应用于船舶稳定设计的三目标优化。

里戈在2003年发表了一篇关于结构优化研究领域的详细的、最新的论文.他介绍了20世纪60年代至2003年船舶结构优化的概念和发展。在同一篇论文中,里戈介绍了优化软件LBR-5,里希尔等人使用该软件解决了一个三目标优化问题。以生产成本、权重和转动惯量为目标,采用两阶段局部搜索启发式算法作为优化算法。扎尼等人介绍了一种决策支持方法,包括对多甲板船舶结构的优化。Klanac提出了矢量化和约束分组的方法来增强快速轮渡结构的优化.Klanac提出了一种用于碰撞模拟的两阶段优化方法. 艾蒙和瑞鲁哈尼提出了一种基于可靠性的复合先进潜艇帆结构优化方法。长采用多目标遗传算法求解一个双目标优化问题. 塞库尔斯基采用遗传算法求解高速客车双体船结构的重量最小化问题。

3.基于学习的船舶优化设计方法

基于学习的船舶优化设计方法旨在模拟自然人的学习,辅助船舶优化设计。因此,设计系统可以自动地从设计活动中吸取经验,帮助正在进行的工作。在这种方法中,船舶设计过程可以类比于人的生活。在每一个设计过程中,该方法将学习瞬时经验,并在特定的设计练习之后,将此经验作为非常有用的知识存储在系统中。随着设计案例数量的增加,系统将通过学习逐步提高其能力。

3.1.学习理论简介

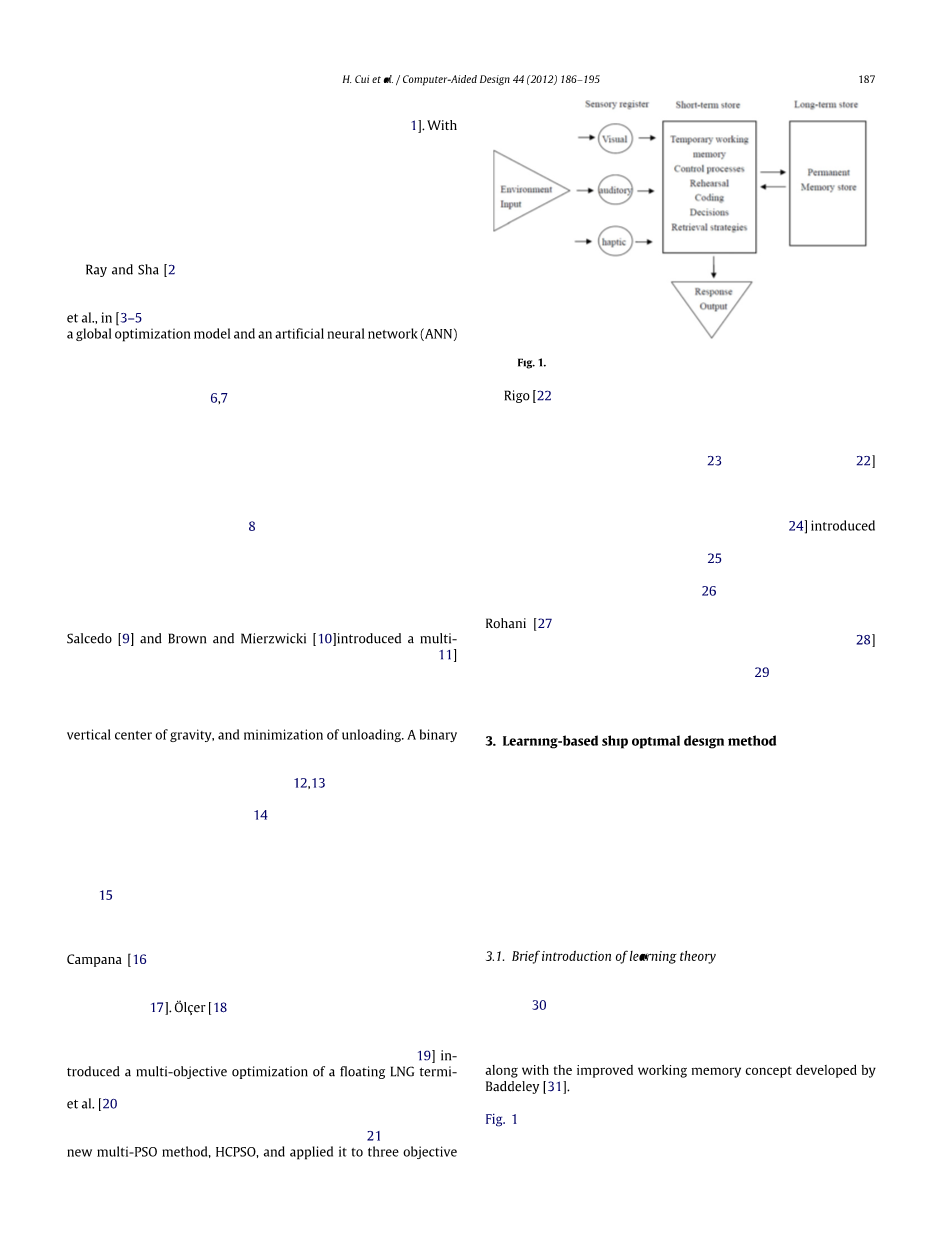

虽然学习科学是20世纪90年代发展起来的,但人类的记忆存储机制是非常复杂的,而记忆存储的详细过程长期以来一直是一个令人困扰的研究课题。在本研究中,阿特金森和谢夫林的流行学习模式被接受,巴德雷也提出了改进的工作记忆概念。

在阿特金森和谢夫林的记忆模型中(如图1所示),记忆过程分为三部分:感觉记忆、短期记忆和长期记忆。感觉记忆是即时记忆,通常只持续几秒钟。长期记忆是使人们能够记住事物的规则的记忆.短期记忆是整个记忆过程中最重要的部分.它在感官记忆中选择合适的部分来转移到长期记忆中,并将放弃其他部分。然而,记忆作为学习理论中最复杂的部分,仍然是一个争论的话题。本研究采用工作记忆理论来描述短期记忆.

图1 巴德利总结的阿特金森和希夫林模型。

图2说明Baddeley的工作记忆模型[32]。内存由中央主管处理。多个组件,其中包括一个视觉空间草图,片段缓冲和语音回路,激活中央主管来帮助回忆。因此,工作记忆过许多感知方法的类型。

图2 巴德利的多组分工作记忆模型

3.2.多目标优化

一般的多目标优化问题(也称为多准则优化、多性能优化或向量优化)是在可行的设计空间上寻找优化向量目标函数的设计变量。目标函数是设计者希望在一定值下最小化、最大化或达到的数量。这个问题可以表述如下:

最小值:F(Y)={f1(Y),f2(Y),hellip;,ft(Y)}

但须符合:

P不等式约束gdelta;(Y)ge;0,delta;=1,hellip;,p

q等式约束hPhi;(Y)=0,Phi;=1,hellip;,q

其中Y=[y1,y2,hellip;,yn]是决策变量的向量。

在多目标优化中,目标往往是相互冲突的。多目标优化的目的是找到一个决策者可接受的解决方案。

设计变量是在优化问题中要选择值的数值量。在大多数工程应用中,设计变量可根据实际问题由设计者控制。设计变量通常具有最大和最小边界,它们可以被视为单独的约束。

环境或资源(例如,物理限制、时间限制等)在优化问题中开发可接受的解决方案时必须满足各种限制。这些限制通常被称为约束,可以是显式的或隐式的。

多目标优化,其目标不仅仅是作为一个全局优化找到一个新的解决方案,而是找到好的妥协。这里,引入了帕累托最优性。对于多目标优化问题,任意两个解y1和y2都有两种可能性之一:一种占优,另一种占优。在最小化问题中,在不失去一般性的情况下,如果满足以下两个条件,则由解y1支配y2:

(1)

如果违反了上述任何条件,则解决方案y1不会主导解决方案y2。如果y1主导解y2,y1称为非支配解。整个搜索空间中的非占优解表示为帕累托最优解,构成帕累托最优集或帕累托最优边界。

3.3.基于学习的船舶优化设计

杉克研究了动态学习,并指出建立专家系统有两种可能的途径。一是尝试获取专家的汇编知识。另一种是试图对专家的原始记忆进行建模。本研究接受后一种观点。根据记忆理论,船舶设计优化的全过程可分为三个部分。每个部分模拟一个相关的学习功能,如图3所示。

图3 一个单一的运行基于机器学习的船舶优化设计。

由心理学家定义为即时记忆的感觉记忆部分,在这里被用来寻找优化过程中的新经验,这些经验是通过尝试和错误来学习的。对于每个设计过程,设计任务可能是不同的,并且从每次运行中获得的经验可能不适合其他设计。首先,该方法应对数据进行分析,并区分其所属的设计任务类型。此外,该方法应尽量从数据中提取规则/关系。这些规则可以在未来的长期记忆中被选择,并可能被放弃。

根据工作记忆理论,短期记忆是这种方法中最重要的部分.这个部分是通过一个“中央行政”中心来管理的。中央主管首先检查数据库中的新规则,以确定它是否已经成为正式规则。正式规则是指从成熟或可靠的知识中获得的规则,如船级社规则、国际海事组织条例等。正式规则还包括以前的设计中使用的规则,这些规则已经被证明是合理的和可用的资源。如果新规则是存储在系统中的正式规则,则可以直接使用。否则,中央行政机关将继续检查新规定是否属于寺庙规则。庙会规则是指在过去的设计工作中至少两次被证明是正确的规则。每个庙会规则都有一个柜台。如果新规则属于庙会规则,则此庙宇规则的计数器将增加1的值。否则,该方法将创建一个新规则并分配相对计数器,在本例中为零。本部分中的计数器用于检查规则的可用性。在规定的时间后,中央行政人员也会检查每一个寺庙规则的柜台。如果计数器超过给定值,中央行政机构将这一庙会规则改为正式规则。如果计数器与给定值不匹配,则将为此计数器提供一个时间检查索引。经过三次连续的预定义时间检查,如果寺庙规则的计数器仍然不能满足给定的要求,则从数据库中删除该庙宇规则。

由巴德利提出的长期内存用于存储足够长的时间,以便在任何持续超过几秒钟的时间内访问信息。在图3中,“长期记忆”是指已经被证明是正确和有效的规章制度体系。

在这种方法中,最重要的是通过实时学习来确定规则.强化学习是最重要和最经典的机器学习方法之一,它通常用于解决代理人在动态环境中必须通过尝试和错误交互来学习行为的问题。强化学习可以在实时学习中得到很好的处理.在经典的强化学习模型中,代理人通过感知和行为与环境连接。在图4所示的模型中,B是代理,T是环境。

图4 经典的强化学习模型。

在第一步骤中,代理B接收输入lsquo;irsquo;;在第二步骤中,代理B选择动作lsquo;arsquo;来生成输出。这个动作lsquo;arsquo;改变了环境T,在第三步,这种状态转换的值通过标量增强信号lsquo;rrsquo;传递给代理B。代理人的行为B,应该选择倾向于增加强化信号值的长期和的行为。随着时间的推移,它可以通过系统的尝试和错误,在各种各样的算法指导下,学会这样做。

该方法选择了一种很好的实时学习方法amp;Q-学习来辅助算法寻找隐藏规则。Q-学习是通过学习一个动作值函数来运行的,该函数给出了在给定状态下采取给定行动并随后遵循固定策略的预期效用。作为无模型强化学习的一种形式,即Q-学习可以在不需要特定环境的情况下比较可用行为的预期效用,对Q-学习的要求相对于环境类型是灵活的。然而,这并不意味着Q-学习适用于所有情况.与连续环境相比,离散环境更适合当前Q学习的发展.同时,离散有限工程环境是船舶设计优化的重要特征之一。因此,Q学习与船舶设计优化相结合是合理的。

对于Q-学习,确定性马尔可夫决策过程(MDP)是一种状态转移是确定性的过程.在非决定论MDP中,概率分布函数定义了给定状态下给定动作的一组潜在后继状态。如果mdp是不确定的,则值的迭代要求我们确定返回最大期望值的操作。理论上,价值迭代在非确定性MDP环境下是可能的。然而,在实际应用中,如果没有额外的知识或一些修改,就不可能找到必要的积分。Q-学习通过取一组积分的最大值来解决这个问题。Q-学习不是从状态到状态值的映射,而是从状态/动作对

全文共10025字,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[13804],资料为PDF文档或Word文档,PDF文档可免费转换为Word