英语原文共 9 页,剩余内容已隐藏,支付完成后下载完整资料

2016年IEEE计算机视觉与模式识别会议

上下文编码器:通过修复的特征学习

Deepak Pathak Philipp Krauml;henbuuml;hl Jeff Donahue Trevor Darrell Alexei A. Efros

University of California, Berkeley

{pathak,philkr,jdonahue,trevor,efros}@cs.berkeley.edu

摘 要

我们提出了一种基于上下文的像素预测驱动的无监督的视觉特征学习算法。通过对自动编码器的类推,我们提出了上下文编码器——一种在训练后能够根据周围环境为条件,生成任意图像区域的卷积神经网络。为了成功地完成这项任务,上下文编码器既需要了解整张图像的内容,也需要为缺失的区域进行合理的假设。在训练上下文编码器时,我们已经尝试了标准的像素重建损失以及像素重建损失与对抗损失相加后的和数。后者产生了更清晰的结果,因为它可以更好地处理输出的多个模式。我们发现,上下文编码器的表示学习,捕获到的不仅仅是视觉结构的外观,而且还有图片的语义信息。我们定量地展示了我们为预训练的学习的卷积神经网络特征在分类、检测以及分割任务上的有效性。此外,上下文编码器可以用于语义上的图像修复任务,也可以是独立的或者非参数方式的初始化。

1 介绍

我们眼中的世界是非常丰富的,同时也是高度结构化的,人类有着不可思议的能力,来理解这些结构。在这项工作中,我们将探索是否可以用最先进的计算机视觉算法来做到相同的事情。如图1a所示,尽管图片的中心部位已经缺失,但是大部分人可以轻松地根据它周围的像素,来想象出缺失部位的内容。我们中的某些人甚至可以把它画出来,就像图1b展示的那样。这种能力,源于这样的事实:尽管自然图像(nautral images) 是多样的,但是它们都是高度结构化的(例如墙体立面上的规则窗户图案)。我们人类可以理解这些结构,然后

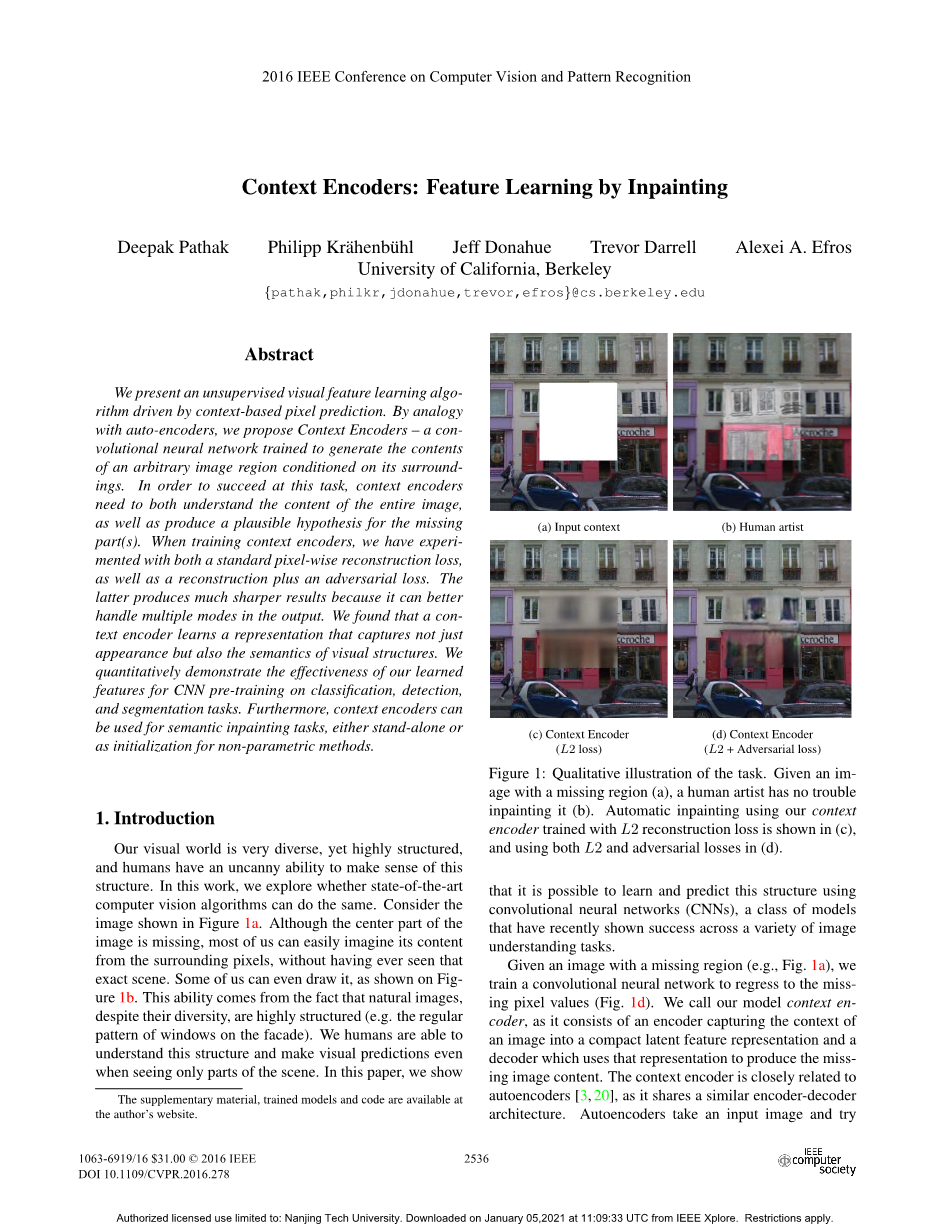

图1:任务的定性说明。给定一个缺少区域(a)的图像,人类艺术家可以毫不费力地修复它(b)。使用我们的上下文自动修复用L2重建损失训练的编码器如(c)所示,同时使用L2和对抗损失的编码器如(d)所示

对视觉结果进行预测,甚至当我们只看到一部分场景的时候,我们也能这么做。在这篇文章中,我们展示了使用卷积神经网络学习对这些结构进行预测是可行的,而卷积神经网络最近在各种图像理解任务中取得成功的一类模型。

给出一幅带有缺失区域的图像(例如图1a),我们训练了一个卷积神经网络 去复原这些缺失的像素值(如图1d)。我们把我们的模型称为上下文编码器。它由一个捕获图片上下文并将图片转化为紧凑的潜在表示的编码器,以及一个生成缺失图片内容的解码器。上下文编码器与自动编码器[3,20]密切相关,它们都有一个相似的 编码-解码 结构。自动编码器接受一张图片,然后在它经过低维度的瓶颈层的时候,将其重构为包含了可以表示场景的压缩(语义)特征。不幸的是,这些特征表示似乎只是将图片内容压缩,而并没有(真正地)学习到有意义的语义表示。去噪自动编码器[38]通过破坏输入的图片来解决这个问题,要求网络可以撤销这些对图片的损伤。然而,这些对图像的破坏方式是通常过于局部,过于低级,完成这些撤销并不需要过多的语义信息。相比之下,我们的上下文编码器需要解决更艰巨的任务:填充图片中的大面积缺失区域,它无法从临近的区域获得用来“提示 hints”的像素。这需要对场景有更加深刻的语义信息理解,与在更大的空间范围内,合成更高层级特征的能力。例如,在图1a中,它需要“凭空捏造(out of the thin air)”出一个完整的窗户。这使得它与 学习从自然语言中,根据上下文预测单词的word2vec [30]有些神似。

就如自动编码器一样,上下文编码器通过完全无监督的方式进行训练。我们的结果表明:为了达成这项任务,模型需要在理解图片上下文的同时,也做出对图片缺失部位的合理假设。然而对于这个任务,在保持(图片)连贯性的基础上,还存在着多种填补缺失区域的方式。(为了尽量避免这种情况),我们通过联合训练我们的上下文编码器来最小化重建损失与对抗损失,来将这种麻烦与我们的损失函数分开。重建损失(L2)捕获了与上下文相关的缺失区域 的整体结构,而对抗损失[16]具有从分布中选择特定(填补)模式的效果。如图1所示,值使用重构损失将会产生模糊的结果。然而添加了对抗损失后,产生了更加清晰的预测结果。

我们独立地评估了编码器与解码器。对于编码器,我们展示了:仅仅通过对图片补丁上下文的编码,以及使用特征提取的结果,就能够从数据集中检索临近的上下文信息,产生在语义上类似于(没见过的)原始补丁。我们通过微调编码器,来进一步用具特征学习的质量,以用于各种图像理解任务,包括分类、对象检测、语义分割。我们与目前最好的无监督、自监督方法,在相同的任务上面比较。对于解码器,我们展示了我们的方法在通常情况下,能够填充逼真的图像内容。事实上,据我们所知,在孔洞修补任务上(大区域的缺失修补),我们是第一个能够给出合理的语义信息修复结果 的参数化的图像修复算法。在无参数的图像修补方法中,上下文编码器也可以被用来计算更好视觉特征。

2 相关工作

过去的十年中,计算机视觉在图片的语义信息理解任务上已经取得了巨大的成果,例如分类、目标检测、语义分割。最近的卷积网络模型[13,27]在这些任务上表现了巨大的性能优势[15,26,28]。这个模型在图片分类任务上面取得的成功,为解决更加困难的问题铺平了道路,包括无监督的情况下,理解并生成自然图片。我们简要地回顾与这篇文章相关的子领域的一些工作。

无监督学习 用上百万张ImageNet[37]中的图片,训练得到卷积网络分类模型,学习到的特征,在交叉任务上面的泛化性能非常地好[9]。然而,这种语义信息和泛化特征是否可以单独地从原始图片中学习到,仍然是一个没有解决的问题。无监督的深度学习中,最早的工作是自动编码器[3,20]。遵循着相同的思路,去噪自动编码器[38]从局部破坏的图片中 重构出原来的图片,使得编码的时候,面对破坏依然可以保持稳健性(robust)。在此处,上下文编码器可以被认为是去噪自动编码器的一种变体,而传递给上下文编码器的输入图片损坏的空间要更大,因此它需要要更多的语义信息完成(对损坏的)撤销。

弱监督与自监督学习 不久前,人们对通过弱监督和自监督来自我学习产生了浓厚的兴趣。一种有用的监督学习资源是使用视频中包含的时态信息。跨帧连续性(consistency across temporal frames) 在嵌入学习(learn embeddings) 中已经的得到使用,并在几个任务上取得良好的表现[17,34]。另一种使用连续性的方法是 追踪包含了相关任务属性的视频中的补丁,并使用追踪补丁的连贯性来指导训练[39] 。从非视觉传感器上读取出自我运动(Ego-motion) 已经被用作训练视觉特征的监督信号[1,21]。

与本文最密切相关的是利用空间的上下文背景 作为自由且丰富的监督信号来源。visual Memex(Menory-Extender) [29]将上下文用于非参数模型的对象关系和预测掩膜对象(predict masked objects) 的场景中,从而[6]使用上下文建立起对无监督对象的发现(体系)。然而,两个方法都依赖于手工设计的特征,并且在表示学习中表现得不好。最近,Doersch[7]等人在图片中的相邻方块预测相对位置的任务中 训练无监督深度特征表示。我们与Doersch等人的研究目标相同,但是在方法上面有着根本的不同:虽然都是解决一个识别的任务(补丁A 是优于 还是劣于 补丁B)我们的上下文编码器解决了一个纯粹的预测问题(即缺损区域中的像素应该是什么值?)有趣的是,在使用语言的上下文学习单词嵌入的任务中,也有着相同的区别:Collobert和Weston [5]提倡一种拼接方式,而在 word2vec[30] 模型中将其标书为单词预测。我们的方法有一个重要的好处,就是我们的监督信号更加的丰富:在每个训练例子中,一个上下文编码器需要预测大约15,000张真实图片,而在Doersch 的方法[7]中的8个选择只有1个选项。可能由于这种差异,我们的上下文编码器需要的时间远远少于 Doersch [7]的方法。此外基于上下文的预测也更难以“投机取巧/作弊 (cheat)”,因为诸如色差之类的低级图像特征,不能提供任何有意义的信息。这一点与 Doersch 中 根据色差(提供的信息)部分地解决任务 形成对比。另一方面,尚不清楚是否需要可信的像素数据来生成良好的视觉特征。

图像生成 自然图像的生成模型一直是人们研究的热点[16,24,35]。最近,Radford[33]提出了新的卷积结构和生成对抗网络(GAN)[16]的优化超参数,产生了令人鼓舞的结果。我们使用对手联合重建损失产生修复结果训练我们的上下文编码器。我们将在第3.2节对此进行详细讨论。

Dosovitskiy[10]和Rifai[36]证明,CNN可以学习生成特定对象类别(分别是椅子和人脸)的新图像,但依赖于带有这些类别示例的大型标记数据集。相反,上下文编码器可以应用于任何未标记的图像数据库,并学习根据周围的上下文生成图像。

图2:上下文编码器。传递上下文图像通过编码器获得所连接的特征使用信道全连接层作为解码器如第3.1节所述。解码器然后产生图像中缺少区域。

孔洞修补和填充 需要指出的是,经典的修补[4,32]或纹理合成方法[2,11]无法处理空洞填充任务,因为缺失区域太大,局部非语义方法无法很好地工作。在计算机图形学中,填充大洞通常是通过场景完成来完成的[19],包括使用来自数百万图像数据集的最近邻的剪切粘贴公式。然而,场景完成意味着通过移除整个对象来填充留下的洞,并且它很难填充任意洞,例如部分遮挡对象的非模态完成。此外,以前的完成依赖于手工制作的距离度量,例如最近邻计算的Gist[31},其低于学习的距离度量。我们证明了我们的方法通常能够以参数化的方式修复语义上有意义的内容,同时也为用户提供了更好的特征。

3 用上下文编码器进行图像生成

我们现在介绍上下文编码器:使用卷积网络,从周围的环境 预测场景中的缺失区域。首先,我们对模型的基本结构进行概述,然后提供学习过程的详细信息,最后介绍图像区域的各种移除策略。

3.1编码-解码流程

模型的整体架构是一个简单的编码-解码器。编码器接受部分区域缺失的图片作为输入,然后输出潜在的特征用于表示这幅图片。解码器接受这些表示特征,然后输出缺失的图片区域。我们发现:在编码器与解码器之间,用全连接层连接起来是重要的,它允许每个解码器单元对整张图片进行推断。图2展示了我们架构的概观。

编码器 我们的编码器是中AlexNet架构里面分离出来的[26]。输入图片的尺寸是227x227,我们使用了前五个卷积层,和跟在它们后面的池化层(称为pool5),计算得到一个6x6x256的特征表示张量。与AlexNet相对比,我们的模型不需要在ImageNet上面进行分类训练。相反,网络被用来进行“从零开始 ”的上下文预测训练。

然而,如果仅限于使用卷积层作为编码器的架构,那么没有任何方法 可以将获取到的信息从特征映射的一角传播到另外一角。这是由于卷积网络只做到了将所有特征映射连接在一起,但却没有直接将所有的位置用一个特定的特征映射连接起来。目前的这个架构中,这一类信息的传播完全由全连接层或者隐含层处理,所有的激活函数都直接与每个节点直接连接。在我们的架构中,潜在特征的维度是6times;6times;256 = 9216,对于编码器和解码器都是这样的。与自动编码器不同,我们没有对原始的输入进行重构,因此我们将它们设计成全连接层是因为我们没有想自动编码器一样拥有一个比较小的瓶颈层。然而,用全连接层完全连接编码器和解码器会导致参数爆炸(超过100M)。在某种程度上,对当前的GPU进行高效的训练是困难的。为了缓解这个问题,我们使用与特征通道相同宽度的全连接层缓解这个问题,详情如下。

与通道等宽的全连接层 这一层实质上是一个全连接层分组,用于传递每一个特征映射中激活后的信息。如果输入层有m个ntimes;n特征映射,那么这一次将会输出维度相同的m个ntimes;n特征映射。然而,与于全连接层不同,它没有连接不同的特征映射,而是在特征映射之间传播信息。因此,等宽通道全连接层的参数数量为mn4,比起m2n4的参数数量已经减少不小了(忽略偏置项)。接下来是一个步长为1的卷积模块执行跨通道的信息传播任务。

解码器 我们现在讨论流程图中的下半部分,使用编码特征生成图片像素的解码器。“编码特征”使用上面提及的通道等宽全连接层与“解码特征”相连接。

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[259472],资料为PDF文档或Word文档,PDF文档可免费转换为Word