英语原文共 11 页,剩余内容已隐藏,支付完成后下载完整资料

附录X 译文

低分辨率人脸识别采用双分支深卷积神经网络

摘 要

提出了一种基于深度卷积神经网络(DCNNS)的低分辨率人脸识别的耦合映射方法。该结构由两个DSCNN分支组成,利用非线性变换将高分辨率和低分辨率的人脸图像映射到一个公共空间。高分辨率图像变换对应的分支由14层构成,将低分辨率人脸图像映射到公共空间的另一个分支由5层超分辨率网络连接到14层网络构成。利用对应高、低分辨率图像特征之间的距离进行反向传播,对网络进行训练。我们的方法在FERET、LFW和MBGC数据集上进行了评估,并与最先进的竞争方法进行了比较。我们的大量实验评估表明,该方法显著提高了识别性能,特别是对于非常低分辨率的探测人脸图像(识别精度提高了5%)。此外,它可以从相应的低分辨率探头图像重建高分辨率图像,在视觉质量上可与目前最先进的超分辨率方法相媲美。

关键词: 低分辨率人脸识别超分辨率方法、耦合映射方法、深度卷积神经网络

1.介绍

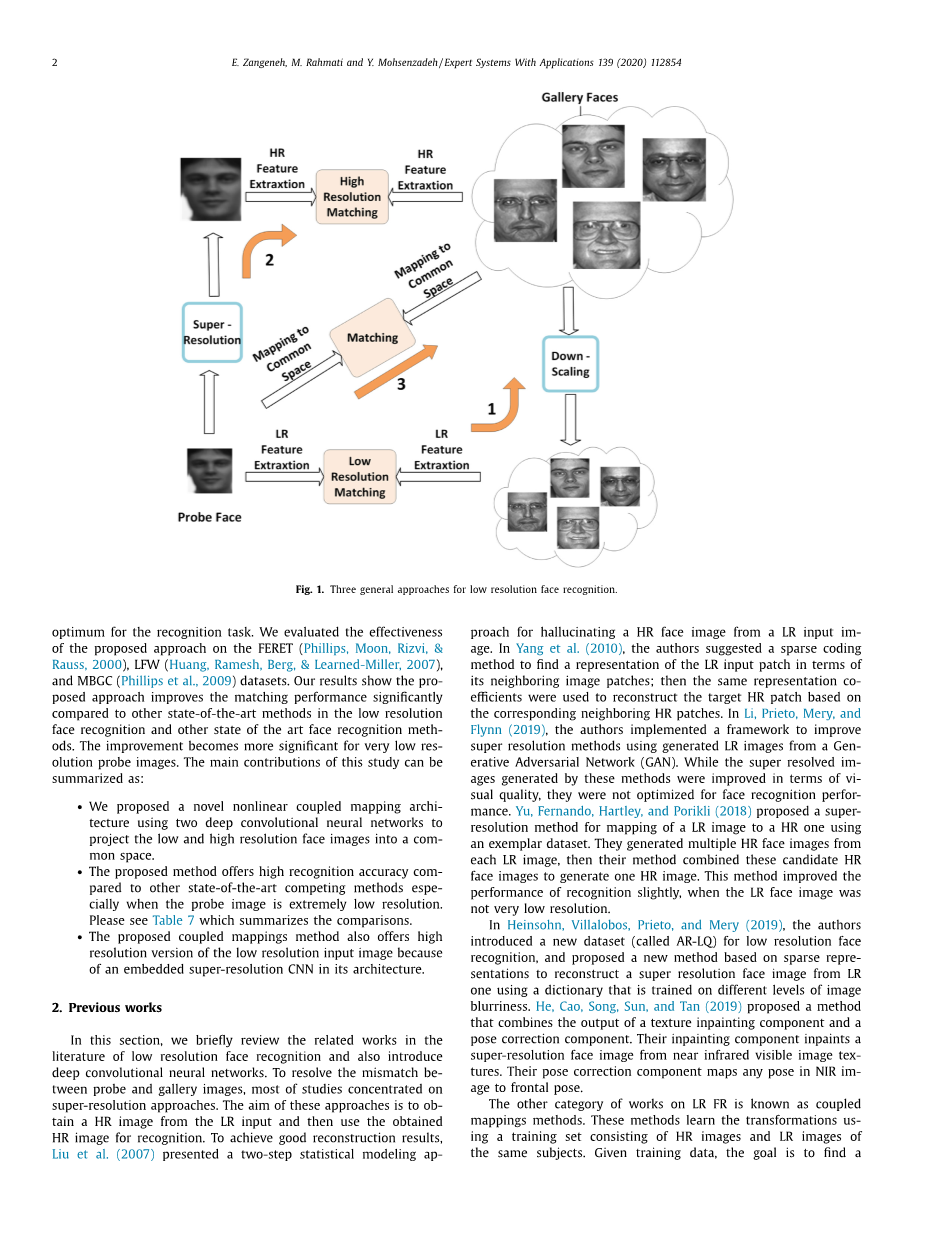

在过去的几十年里,人脸识别在许多应用领域和具有挑战性的条件下显示出了良好的性能,如遮挡、姿势变化、光照和表情。虽然许多人脸识别系统已经开发识别高质量的脸的图像在控制条件下,有一些研究集中在人脸识别等真实世界的应用程序监视系统与低分辨率人脸。在这些应用中一个重要的挑战是,高分辨率(HR)探头图像可能是不可用的,因为相机到被摄对象的距离很大。在这里,我们重点解决了在高质量图像库可用时识别低分辨率探测人脸图像的问题。有三种标准方法可以解决这个问题。(1)向下采样画廊图像到探头图像的分辨率,然后进行识别。然而,这种方法是次优的,因为额外的鉴别信息在高分辨率画廊图像丢失了。(2)第二种方法是从低分辨率图像中获取高分辨率的探头图像,然后将其用于识别。这些超分辨率技术大多是为了在视觉质量方面重建高分辨率的图像,而没有优化识别性能。(3)最后,第三种方法同时将LR探针和HR图库图像转换为一个公共空间,其中对应的LR和HR图像距离最近;在本文中,我们使用第三种方法,提出了一种利用深度卷积神经网络(DCNNS)来寻找低分辨率和高分辨率人脸图像之间的公共空间的方法。尽管之前的工作使用线性方程作为目标函数来寻找两个投影矩阵,我们的工作发现了一个从LR和HR到公共空间的非线性转换。该方法将变换后的低分辨率和高分辨率图像在公共空间中的距离作为训练深度卷积神经网络的目标函数。该方法还重建了良好的人脸图像最适合识别任务。我们评估了该方法的有效性。

图1. 低分辨率人脸识别的三种一般方法

结果表明,在低分辨率人脸识别和其他最先进的人脸识别方法中,该方法显著提高了匹配性能。对于非常低分辨率的探测图像,这种改进变得更加重要。本研究的主要贡献可以总结为:

bull;我们提出了一种新的非线性耦合映射结构,使用两个深度卷积神经网络将低分辨率和高分辨率的人脸图像投影到一个公共空间。

bull;与其他最先进的竞争方法相比,该方法具有较高的识别精度,特别是在探头图像分辨率极低的情况下。请参见表7,其中总结了比较结果。

bull;该耦合映射方法还提供了高分辨率的低分辨率输入图像,因为其架构中嵌入了超分辨率CNN。

2.文献综述

在本节中,我们简要回顾了低分辨率人脸识别的相关文献,并介绍了深度卷积神经网络。为了解决探头图像与画廊图像之间的不匹配问题,目前的研究多集中在超分辨率方法上。这些方法的目的是从LR输入中获取HR图像,然后使用获得的HR图像进行识别。为了取得良好的重建效果,提出了两步统计建模AP用于从LR输入图像中产生HR面部图像的幻觉。作者提出了一种稀疏编码方法,用相邻的图像块来表示LR输入块;然后利用相同的表示系数,在相邻的HR patch的基础上重建目标的HR patch。在Li, PRIE和Flynn(2019)中,作者实现了一个框架,使用生成的对抗网络(GAN)生成的LR图像来改进超分辨率方法。虽然这些方法生成的超分辨图像在视觉质量方面得到了改善,但在人脸识别性能方面没有得到优化。YU、Fernando(2018)提出了一种使用范例数据集将LR图像映射到HR图像的超分辨率方法。他们从每个LR图像生成多个HR人脸图像,然后他们的方法结合这些候选HR人脸图像生成一个HR图像。在LR人脸图像分辨率不是很低的情况下,该方法对识别性能有一定的提高。

在维拉波斯、普列托和MERY(2019),作者引入了一个新的数据集(称为AR-L)对低分辨率人脸识别,并提出了一种新的基于稀疏表示方法重建的人脸图像超分辨率LR使用字典训练在不同级别的图像模糊不清。He,Song,Sun,and Tan(2019)提出了一种将纹理组件输出和姿态校正组件输出相结合的方法。他们的组件从近红外可见图像纹理绘制超分辨率的人脸图像。他们的姿态校正组件将近红外图像中的任何姿态映射到正面姿态。

另一类关于LR FR的工作被称为耦合映射方法。这些方法使用由相同受试者的HR图像和LR图像组成的训练集来学习转换。给定训练数据,目标是找到最小变换后的LR和HR特征向量XLI和XHI之间的距离。大多数耦合映射方法使用线性目标函数如下:

其中n为训练图像的数量,{XIH}NI=1, {XLI}NI=1分别为HR和LR图像的对应提取特征。WL和WH分别表示低分辨率和高分辨率特征向量到公共空间的线性映射。P是一个保留原始特征空间中数据点间局部关系的ntimes;n罚权矩阵,它是在数据点的邻域上定义的训练具有不同分辨率的人脸图像将提高任何基于DCNN的人脸识别方法的性能如下。

综上所述,耦合映射方法比超分辨率方法具有更好的识别性能,但这些方法的目的不是从低分辨率输入图像重建高分辨率图像。另一方面,超分辨率方法的主要目标是重建高质量的图像以达到可视化的目的,但这并不一定能提供更好的识别精度。在下一节中,我们将提出一种使用深度卷积神经网络的耦合映射方法来实现到公共空间的非线性映射。该方法与其他成功的使用深度卷积神经网络的方法相似,具有上述优点。除了具有较高的识别性能外,该方法还可以从低分辨率的输入图像生成高分辨率的图像。

3.该方法

这里,C包含的指标k最近的邻居XHII高分辨率空间和sigma;是被定义为高斯函数宽度i

其中alpha;是一个尺度参数。由于假设HR特征空间具有更多的判别信息,因此上述目标函数的目标是找到一个与HR特征空间相似的公共特征空间。最后,通过对上述目标函数的优化,找到WL和WH,分别将低分辨率和高分辨率的图像转化为公共空间。

Huang和He(2011)提出了一种为低分辨率探头和高分辨率画廊图像寻找公共空间的方法,以及一种保证新公共空间可识别性的目标函数。利用多维标度变换学习来寻找低分辨率和高分辨率投影矩阵。优化问题的目标函数使一个类在公共空间中的低分辨率和高分辨率图像对之间的距离与该类的高分辨率图像对之间的距离相等。利用正则相关分析(CCA)将低分辨率和高分辨率图像投影到一个公共空间中,使低分辨率图像与其对应的高分辨率图像尽可能接近。然后利用立体匹配代价函数在变换后的空间中保持不同光照、姿态和分辨率下的距离。Lu, JIANG, and KOT(2018)的作者提出了一个人脸识别框架,该框架实现了将两个低分辨率和高分辨率的人脸图像匹配到公共空间的残差网络,但是他们没有使用任何超分辨率方法来实现LR图像的超分辨率。他们使用了8个具有不同训练数据集的DCNNS,并利用这些网络的最后一层的特征来匹配LR探测面和gallery HR面。在这个方法中,它们告诉我们由于求解非线性优化问题的难度,以往耦合映射方法(如第2节所述)中的目标函数均采用线性变换建模。但是,将低分辨率和高分辨率的非线性变换到一个公共空间可能会得到更好的性能。在此,我们提出了一种非线性耦合映射方法,该方法使用两个深度卷积神经网络(DC- NNS)来从低分辨率探测图像和高分辨率画廊图像中提取特征,并将它们投射到一个公共空间中。我们使用基于梯度的优化来最小化映射的HR和LR图像对在公共空间中的距离,并通过误差的反向传播来更新DCNN的权值。在训练阶段,我们使用包含同一个人的低分辨率和高分辨率图像对的训练图像集,这些图像在不同的光照、姿态和表情条件下可以在不同的图像中变化(不一定是相同的图像,只是不同的分辨率)。在下一节中,我们将详细介绍所提出的方法的体系结构。

3.1. 网络体系结构

该方法具有两个分支结构,一个分支将高分辨率图像投影到公共空间,另一个分支将低分辨率图像映射到公共空间。在我们的方法中,我们使用一个称为VGGNET的DCNN。这个网络最著名的配置是16层,13个卷积层和3个全连接层。VGGNET的最后一个完全连接层,用于特定的分类任务。在我们方法的顶部分支。我们的方法的顶部分支的输入图像是高分辨率图像(IH),它必须是224times;224维的(当输入图像大小与224times;224维不同时,我们使用传统的双三次插值方法来获得所需的大小)。i最后一层的输出是一个包含4096个元素的特征向量。

在我们的方法的底部分支中,我们使用了之前用于超分辨低分辨率图像的DCNN,然后是第二个网络,其架构与顶部分支中的网络类似。第一个子网也有类似的建筑提出的DCNN,咚,阿来,他和唐(2014),但我们扩展这个架构从三层到五层,虽然作者显示没有区别一个三层体系结构和一个五层的视觉重建的图像质量,我们发现增加三至五层的改善我们的方法的识别性能。我们称底层分支的第一个子网络为超分辨率网络(SRNET)。第一个子网的输出被送入第二个子网(FECNN)。因此,我们的方法上支网由14层组成,下支网由19层组成,如图所

图2.方法概述M和N分别表示HR和LR图像的维数,M表示gt; N。

图3.我们所提出的方法是在两个分支上建立两个深度卷积神经网络

示底支网的输入是低分辨率的图像(I1),需要用传统的插值方法进行插值,其大小为224times;224。同时SR子网的输出为大小为224times;224的图像。如上所述,除了最后两个完全连接的层之外,FECNN网络具有与VGGNET相同的体系结构。虽然超级分辨率和特征提取卷积神经网络(SRFECNN)有18个卷积层和一个全连通的卷积层,但是SRFECNN中使用的权值总数远远小于VGGNET。

尽管我们提出的SRFECNN包含18个卷积层,但是由于与VGGNET相比,全连接层的数量更少,所以它的权值比VGGNET (141M权值)更少。因此,在测试阶段,当我们需要在内存中加载SR- FECNN权值时,我们提出的方法比VGGNET需要更少的空间。这是一个重要的特点,使我们的方法适用于低内存系统。

3.2 常见的子空间学习

最后两个完全连接的层,因为它们是特定于网络所训练的分类任务的。我们将这个网络称为预训练的FECNN,并将其用于我们架构的顶部和底部分支。

bull;在第二步中,我们使用高分辨率和低分辨率的人脸图像对数据集训练底层分支的SRNET。使用数据集的详细信息在实验评估部分中给出。

bull;第三步是主要的培训阶段。我们将两个子网,即SRNET和FECNN合并,将一个包含同一个人的低分辨率和高分辨率对的训练数据集分别输入到底层和顶层的分支上。

表1.SRFECNN 层中使用的权值的数量

|

图层组 |

参数 |

数量的权重 |

|

Conv0_1 |

F = 9times;9 深度= 696 |

3times;9times;9times;96 = 23,328 |

|

Conv0_2 |

F = 1times;1 深度= 64 |

96times;1times;1times;64 = 6144 |

|

Conv0_3 |

F = 1times;1 深度= 48 |

64times;1times;1times;48 = 2928 |

|

Conv0_4 |

F = 1times;1 深度= 32 |

48times;1times;1times;32 = 1536 |

|

Conv0_5 |

F = 5times;5 |

32times;5times;5times;3 = 2400 |

|

Conv1 (2 conv) |

深度= 3 F = 3times;3 |

2(3times;3times;3times;64)= 3456 |

|

Conv2 (2 conv) |

深度= 64 F = 3times;3 |

2(64times;3times;3times;128)= 147,456 |

|

Conv3 (3 conv) |

深度= 128 F = 3times;3 |

3(128times;3times;3times;256)= 884,736 |

|

Conv4 (3 conv) |

深度= 256 F = 3times;3 |

3(256times;3times;3times;512)=3,538,944 |

|

Conv5 ( 剩余内容已隐藏,支付完成后下载完整资料 资料编号:[424504],资料为PDF文档或Word文档,PDF文档可免费转换为Word |