英语原文共 9 页

利用图卷积网络对关系数据进行建模

摘要

知识图谱支持广泛的应用,包括回答问题和信息检索。尽管在创建和维护上投入了大量的精力,但即使是最大的知识图谱(例如Yago、DBPedia或Wikidata)也仍然不完整。我们引入关系图卷积网络(R-GCNs),并将其应用于两个标准的知识库完成任务:链路预测(恢复缺失的事实,即主体-谓词-对象三元组)和实体分类(恢复缺失的实体属性)。RGCNs是一种新型的基于图形的神经网络,专门用于处理现实知识库中高度多关系的数据特征。我们证明了R-GCNs作为实体分类的独立模型的有效性。我们进一步证明,利用编码器模型对DistMult等链路预测的因子分解模型进行丰富,从而在关系图中通过多个推理步骤积累证据,可以显著提高这些模型的性能,与仅使用解码器的基线相比,FB15k-237的性能提高了29.8%。

1引言

知识库组织和存储事实知识,支持包括问答在内的多种应用(Yao and Van Durme. 2014;Bao 等.2014;Seyler, Yahya, and Berberich. 2015; Hixon, Clark, and Hajishirzi. 2015;Bordes 等.2015;Dong 等.2015)与信息检索 (Kotov and Zhai .2012; Dalton, Dietz, and Allan .2014;Xiong and Callan 2015b;2015a)。即使是最大的知识库(如DBPedia、Wikidata或Yago),尽管在维护上投入了大量的精力,但它们也是不完整的,并且缺乏覆盖范围会损害下游应用程序。预测知识库中的缺失信息是统计关系学习(SRL)的主要研究内容。

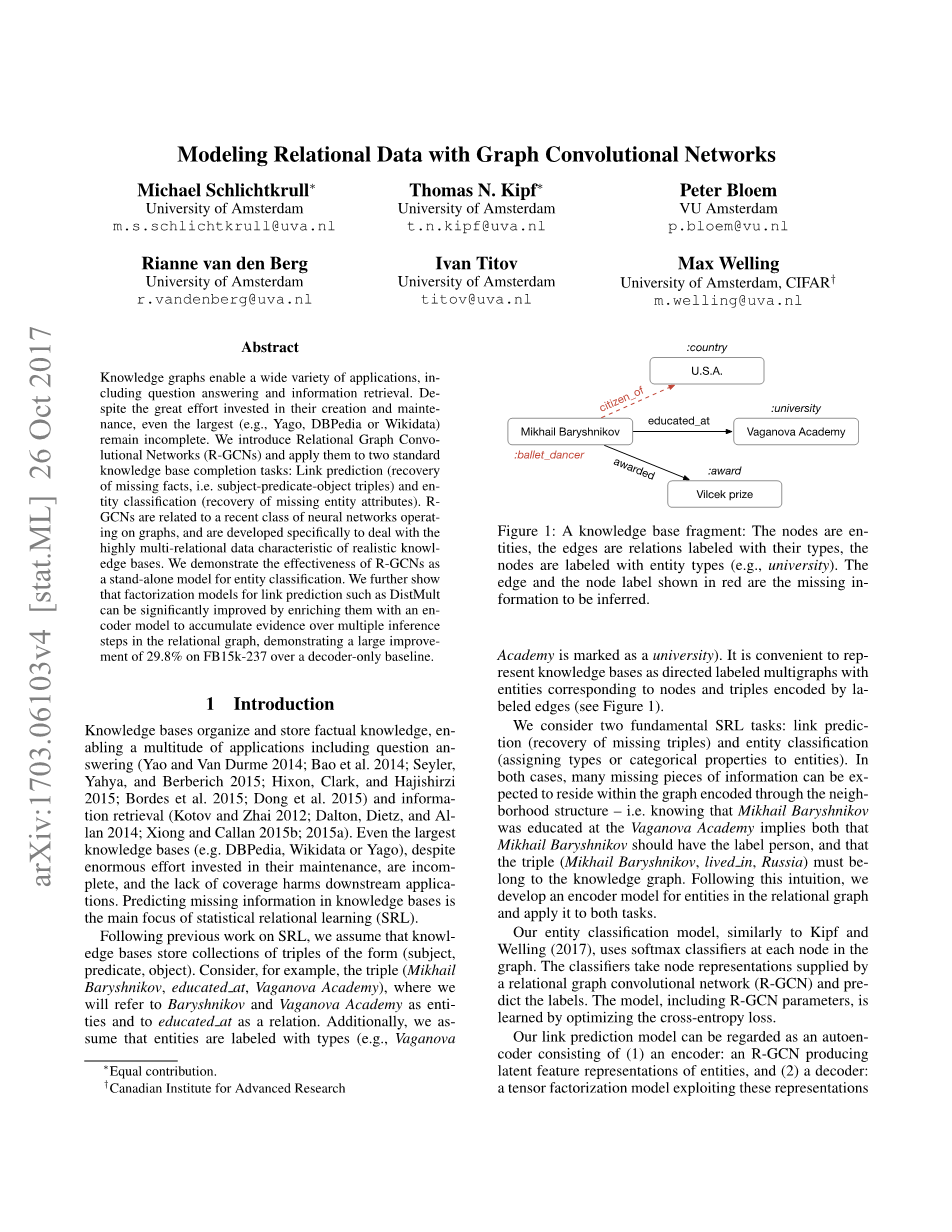

在前面的SRL工作之后,我们假设知识库存储表单的三元组集合(主题、谓词、对象)。例如,考虑一下三元组(Mikhail Baryshnikov 在瓦加诺瓦学院接受教育),我们将把Baryshnikov和瓦加诺瓦学院作为实体,并将其接受教育作为关系。此外,我们假设实体被标记为类型(例如,瓦加诺瓦学院被标记为大学)。可以方便地将知识库表示为有向标记的多图,其中的实体对应于标记边编码的节点和三元组(参见图1)。

图1知识库片段:节点是实体,边缘是用其类型标记的关系,节点是用实体类型标记的(例如大学)。红色显示的边缘和节点标签是要推断的缺失信息。

我们考虑两个基本的SRL任务:链路预测(恢复丢失的三元组)和实体分类(为实体分配类型或分类属性)。在这两种情况下,可,以将许多失踪的信息驻留在图形编码通过社区结构,在这两种情况下,许多缺失的信息都可能存在于通过邻域结构编码的图中,即知道Mikhail Baryshnikov在Vaganova教育学院就意味着Mikhail Baryshnikov应该是个人, 而这三元组(Mikhail Baryshnikov,生活在俄罗斯)必须属于知识图谱。根据这种直觉,我们为关系图中的实体开发了一个编码器模型,并将其应用于这两个任务。

我们的实体分类模型,类似于kipf和welling(2017年),在图中的每个节点使用SoftMax分类器。这些分类器采用关系图卷积网络(R-GCN)提供的节点表示来预测标签。该模型的R-GCN参数通过优化交叉熵损失得到。

我们的链路预测模型可以被看作是一个自动编码器,包括(1)编码器:产生实体潜在特征表示的R-GCN编码器;和(2)解码器:利用这些表示来预测标记边缘的张量分解模型。尽管原则上解码器可以依赖于任何类型的因数分解(或通常任何评分函数),但我们使用了最简单和最有效的因子分解方法之一:DistMult(Yangetal.2014)。我们观察到,我们的方法在标准基准上取得了具有竞争力的结果,在其他基线中表现优于因子分解的直接优化(vanilla DistMult)。当我们考虑更具挑战性的FB15k-237数据集(Toutanova和Chen.2015)时,这种改进尤其明显。该结果表明,R-GCNs中邻域的显式建模有利于知识库中缺失事实的恢复。

我们的主要贡献如下,据我们所知,我们是第一个证明GCN框架可以应用于关系数据建模,特别是链路预测和实体分类任务。其次,我们介绍了参数共享和稀疏约束的技术,并利用它们将R-GCNs应用于具有大量关系的多图。最后,我们以DistMult为例,通过在关系图中执行多个信息传播步骤的编码器模型来丰富因子分解模型,可以显著提高模型的性能。

2神经关系建模

介绍以下符号:我们将有向和有标记多图表示为,其中节点(实体)为,有标记边(关系),其中为关系类型。

2.1关系图卷积网络

我们的模型主要是作为对局部图形邻域进行操作的GCN的扩展(Duvenaud等.2015;kipf和welling. 2017)到大规模关系数据。这些方法和相关方法,如图神经网络(Scarselli等.2009)可以理解为简单可区别消息传递框架的特殊情况(Gilmer等.2017):

是神经网络第层中节点的隐藏状态,为该层表示的维数。表单的传入消息被累积并通过元素激活函数 传递,例如。表示节点的传入消息集,通常选择与传入边集相同。通常被选择为一个(特定于消息的)类神经网络函数,或者简单地用权重矩阵W进行线性变换,如Kipf和Welling(2017)。

这种类型的转换在积累和编码来自本地结构化社区的特征方面非常有效,并在图分类(Duvenaud 等.2015)和基于图的半监督学习(Kipf和Welling 2017)等领域带来了显著的改进。

受这些架构的驱动,我们定义了以下简单传播模型,用于计算多图关系中(定向和标记)由表示的实体或节点的正向传递更新:

其中表示关系下节点的一组相邻索引,是一个问题特定的规范化常量,可以预先学习或选择(如)。

直观上,(2)通过归一化和来累积相邻节点的变换特征向量。与常规的GCN不同,我们引入了关系特定的转换,即依赖于类型和方向风扇边缘。为了保证L 1层节点的表示也能通过L层相应的表示得到通知,我们为数据中的每一个节点添加了一个特殊关系类型的单自连接,注意,可以选择更灵活的函数,如多层神经网络(以牺牲计算效率为代价),而不是简单的线性消息转换。我们把这个留给将来的工作。

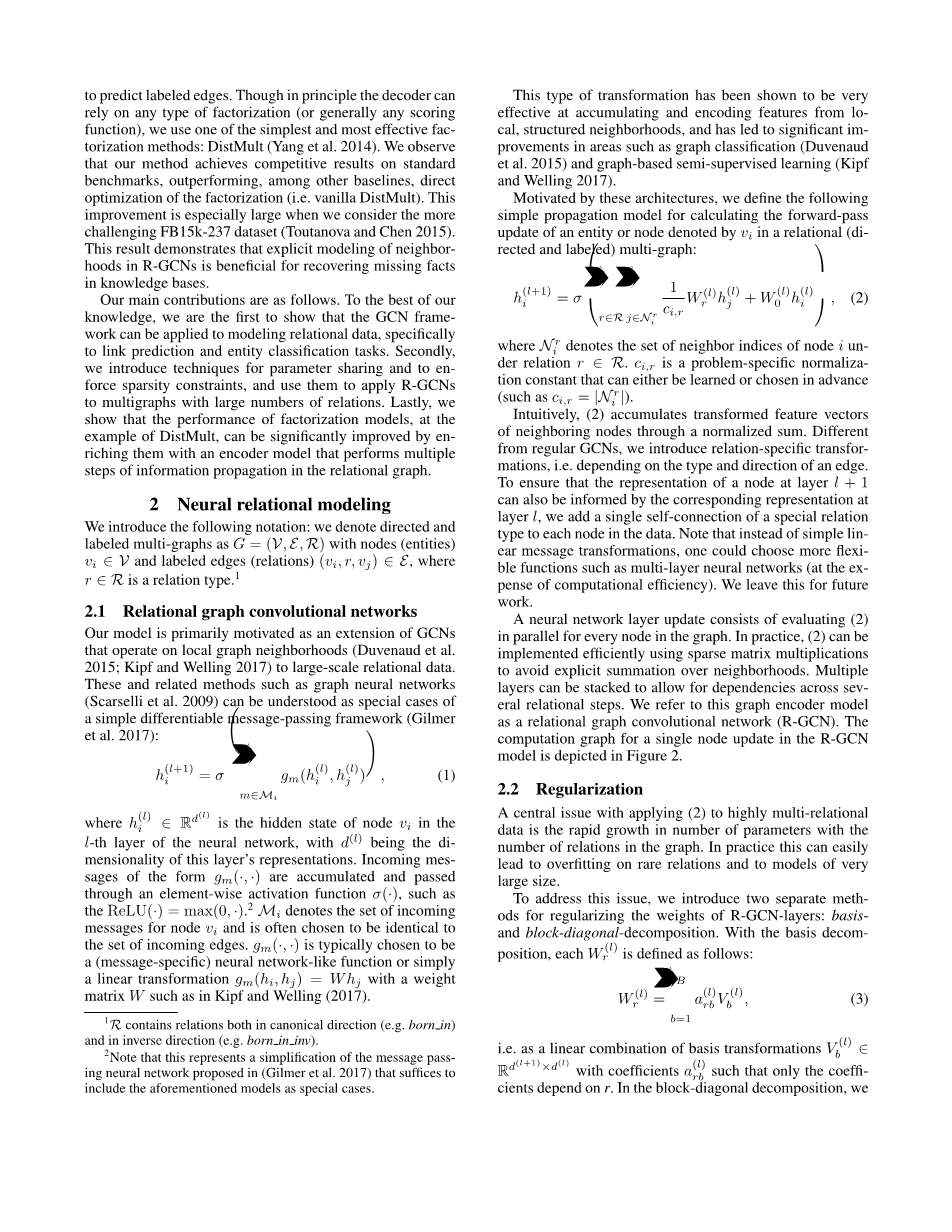

神经网络层更新包括对图中每个节点并行求值(2)。在实际应用中,利用稀疏矩阵乘法可以有效地实现(2),避免邻域上的显式求和。可以将多层堆叠起来,以支持跨多个关系步骤的依赖性。我们将此图编码器模型称为关系图卷积网络(R-GCN)。R-GCN模型中单个节点更新的计算图如图2所示。

2.2正规化

将(2)应用于高度多关系数据的一个中心问题是,随着图中关系的数量增加,参数的数量也在快速增长。在实践中,这很容易导致对罕见关系和超大尺寸模型的过度关注。

图2:R-GCN模型中单个图节点/实体(红色)的更新计算图。从邻接节点(深蓝色)获取激活(d维向量),然后分别对每个关系类型(对于向内和向外的边)进行转换。结果表示(绿色)以(规范化)和的形式累积,并通过激活函数(如ReLU)传递。每个节点的更新可以与整个图中的共享参数并行计算。

为了解决这个问题,我们引入了两种独立的规则化R-GCN层权重的方法:基块对角分解。根据基分解,每个定义如下:

即基础的线性组合转换 和系数这样只有系数取决于r。在块对角分解中,我们通过对一组低维矩阵的直和来定义每个:

因此,是块对角矩阵:和。

基函数分解(3)可以看作是不同关系类型之间有效权值共享的一种形式,而块分解(4)可以看作是对每种关系类型的权值矩阵的稀疏性约束。块分解结构编码了一种直觉,即潜在特征可以被分组到一组变量中,这些变量在组内的耦合比在组间的耦合更紧密。这两种分解都减少了学习高度多关系数据(如现实知识库)所需的参数数量。同时,我们希望基参数化可以缓解稀有关系的过拟合,因为稀有关系和更频繁关系之间共享参数更新。

整个R-GCN模型采用如下形式:我们按照(2)中的定义将L层堆叠起来——上一层的输出作为下一层的输入。如果没有其他特性存在,则可以为图中的每个节点选择第一层的输入作为惟一的单热向量。对于块表示,我们通过一个线性变换将这个热向量映射到一个稠密的表示形式。虽然我们在本文中只考虑了这种无特征的方法,但我们注意到Kipf和Welling(2017)的研究表明,这类模型可以使用预定义的特征向量(例如,与特定节点相关联的文档的文字描述)。

图2:R-GCN模型中单个图节点/实体(红色)的更新计算图。从相邻节点(深蓝色)收集激活(d维向量),然后分别对每个关系类型(对于向内和向外的边)进行转换。结果表示(绿色)以(规范化)和的形式累积,并通过激活函数(如ReLU)传递。每个节点的更新可以与整个图中的共享参数并行计算。

3实体分类

对于(半)监督的节点(实体)分类,我们简单地将表单(2)的R-GCN层堆叠起来,在最后一层的输出上使用softmax(·)激活(每个节点)。我们在所有标记节点(忽略未标记节点)上最小化以下交叉熵损失:

其中是具有标签的节点索引的集合,是第个标签节点的网络输出的第项。表示其各自的地面实况标签。在实践中,我们使用(整批)梯度下降技术训练模型。图3a给出了我们的实体分类模型的示意图。

4链路预测

链路预测是对新事实(即三元组(主体、关系、对象))的预测。在形式上,知识库由一个有向标记的图表示. 我们只得到一个不完整的子集,而不是整组边。任务是将分数分配给可能的边,以确定这些边属于的可能性。

为了解决这个问题,我们引入了一个图形自动编码器模型,它由一个实体编码器和一个计分函数(解码器)组成。编码器 每个实体映射到一个实值向量解码器塑造边缘图的依赖顶点表示;换句话说,它的分数(主题、关系、对象)三元组通过一个函数s: 。大多数现有预测方法(例如,张量和神经因子分解方法(Socher 等. 2013;Lin等.2015;Toutanova 等. 2016;Yang 等. 2014;Trouillon 等. 2016))可以在这个框架下进行解释。我们工作的关键特点是依赖编码器。虽然大多数先前的方法对于训练中直接优化的每个使用单个实值向量,但我们通过具有的R-GCN编码器计算表示,类似于引入的图形自动编码器模型 在Kipf和Welling(2016)中,未标记的无向图。 我们的完整链接预测模型如图3b。

在我们的实验中,我们使用DistMult因数分解(Yang 等. 2014)作为评分函数,该函数在标准链路预测基准测试中单独使用时表现良好。在DistMult中,每个相关关系和一个对角矩阵相关联,一个三元得分为:

如先前的关于因子分解的研究(Yang等. 2014;Trouillon等.2016);我们对模型进行了负样本训练。对于每个观察到的例子,我们对omega;负数进行抽样,通过随机破坏每个正例子的主题或对象来取样。我们优化交叉熵损失,推动模型得分可观察到的三元组高于负值:

其中是实际和损坏的三元组的总集合,是逻辑sigmoid函数,是一个指标,对于正三元组设置为,对于负三元组设置为。

5实证评估

5.1实体分类实验

在这里,我们考虑对知识库中的实体进行分类的任务。例如,为了推断一个实体(例如个人或公司)的类型,一个成功的模型需要推断出这个实体与所涉及的其他实体之间的关系。

数据集 我们在资源描述框架(RDF)格式(Ristoski,de Vries和Paulheim2016)中的四个数据集3上评估我们的模型:AIFB,MUTAG,BGS和AM。 这些数据集中的关系不一定必须编码定向的主客体关系,而是还用于编码给定实体的特定特征的存在或不存在。 在每个数据集中,要分类的目标是表示为节点的一组实体的属性。 数据集的确切统计数据可以在表1中找到。有关数据集的更详细描述,读者可以参考Ristoski,de Vries和Paulheim(2016)。 我们删除了用于创建实体标签的关系:使用AIFB的andafafiation,MUTAG的Mututnic,BGS的具有生成功能,以及AM的objectCategory和材料。

表1:实体数量,关系,边和类以及每个数据集的标记实体数量。 Labeled表示具有标签且要进行分类的实体子集。

基线 作为我们实验的基线,我们比较了RDF2Vec嵌入(Ristoski和Paulheim 2016),Weisfeiler-Lehman内核(WL)(Shervashidze等2011; de Vries和de Rooij)的最新分类结果。 2015),以及手工设计的特征提取器(Feat)(Paulheim和Fuml;umkranz2012)。 Feat从每个标记实体的in-and-degree(每个关系)组装一个特征向量。 RDF2Vec使用Skipgram(Mikolov等2013)模型提取已经过标记的图表,然后使用Skipgram(Mikolov等,2013)模型生成实体嵌入,用于后续分类。 有关这些基线方法的深入描述和讨论,请参见Ristoski和Paulheim(2

资料编号:[3567]