英语原文共 8 页,支付完成后下载完整资料

自适应图卷积神经网络

摘要

图卷积神经网络是经典CNNs的推广,用于处理分子数据、点网络和社会网络等图形数据。图CNNs中的电流滤波器是针对固定图结构和共享图结构而建立的。然而,大多数真实数据的图形结构在大小和连通性方面都有所不同。本文以任意图结构的数据为输入,提出了一种广义灵活的图CNNs。这样,就可以在训练时为每个图数据学习一个任务驱动的自适应图。为了有效地学习图,一种距离度量学习方法被提出。对九个图结构并行算法进行的广泛实验,证明了算法的收敛速度和预测精度都有很好的性能提高。

1 概述

尽管卷积神经网络(CNNs)已经被证明在广泛的机器学习问题上取得了极大的成功 (Hinton et al. 2012; Dundar et al.2015),但它们通常需要投入才能成为张量。例如,图像和视频分别被建模为二维和三维张量。然而,在许多实际问题中,数据处于不规则网格或非欧几里德域,如化学分子、点云和社交网络。与规则形状的张量不同,这些数据更好地被构造成图,它能够处理变化的邻域顶点连通性以及非欧几里德度量。在这种情况下,网格上允许基于核的卷积的平稳性和组合性不再满足。因此,有必要重新构造图结构数据上的卷积算子。

然而,将CNNs从规则网格扩展到不规则图并非易事。为了构造卷积核的简单性,早期图CNNs通常假定数据仍然是低维的l (Bruna et al. 2013;Henaff, Bruna, and LeCun 2015)。卷积器根据节点程度分别处理节点,它们的卷积核过于局部化,因而无法从具有不可预测和灵活节点连通性的复杂图(如分子和社会网络)中学习层次表示。

在某些情况下(如点云分类),图的拓扑结构比顶点特征信息更丰富。遗憾的是,现有的图卷积由于难以设计参数化的空间核来匹配不同数目的邻域,而无法充分利用图上的几何性质(Shuman et al. 2013)。此外,考虑到图的灵活性和参数的尺度,了解每个图的自定义拓扑保持空间核是不切实际的。

除了受限图的空间卷积外,基于图Fourier变换的光谱网络提供了一个弹性核(Defferrard, Bresson, and Vandergheynst 2016)。与经典的CNNs相同,仍然假定样本之间存在共享的内核。因此,为了保证层输出的维数统一,必须调整输入的大小,这也是经典CNNs的一个约束。然而,这种对图形数据的预处理可能会破坏面向图形信息的完整性。例如,分子的粗化很难在化学上被证明是合理的,并且粗糙的图形很可能已经失去了区分分子与其他分子的关键子结构。如图1所示,除去图中任何一个碳原子都会破坏苯环。如果图CNNs能够接受不同图形结构的原始数据样本,那么情况就会好很多。最后,我们提供给图CNNs的数据要么有一个内在的图结构,要么可以通过聚类来构造一个图结构。在以前的图CNNs中,初始图结构将在训练过程中固定(Bruna et al. 2013)。但是,对于有监督学习任务,仍采用无监督聚类(或从领域知识)构造的图是否是最优的,是很难评估的。虽然已经提出了具有完全连通网络的有监督图构造(Henaff, Bruna, and LeCun 2015),但它们的密集训练权将模型限制在了小图上。此外,从单独的网络中学习到的图结构也不能保证最好地服务于图的卷积。

图1:图形结构数据示例:有机化合物3,4-二甲基吡啶(C7H9N)及其图形结构。

当前图CNNs的瓶颈包括:

·约束图度;

·要求输入之间共享相同的图结构;

·不经过训练而构造的固定图;

·无法从拓扑结构中学习。

在本文中,我们提出了一种新的谱图卷积网络,该网络以多个图结构的原始数据为基础。为了避免共享谱核,我们给出了一个定制图Laplacian,它客观地描述了每个样本的唯一拓扑结构。自定义图Laplacian将导致定制的频谱滤波器,并根据自身独特的图形拓扑结合邻居特征。

一个有趣的问题是,什么样的精确图最适合监督学习任务。例如,化学键自然地为一个化合物建立了一个图形,然而,不能保证工作于内在图上的卷积器已经提取了所有意义的特征。因此,我们训练一个新的剩余图来发现内在图所不包含的剩余子结构。此外,为了保证残差图是对特定任务的最佳补充,我们设计了一种在训练剩余图CNN的过程中学习残差图的方案。

对于N个顶点的 图,图Laplacian的直接学习代价为复杂度。允许在M训练样本中保留唯一的图拓扑意味着学习M唯一图Laplacian,这样做得代价是非常大的。如果利用带Mahalanobis距离的监督度量学习,假设度量参数是在样本间共享的,我们就可以将参数减少到甚至。因此,学习复杂度与图的大小N无关。在经典的CNNs中,反向传播通常会更新核权重,在每个特征维上调整相邻节点之间的关系,而后总结来自所有滤波器的信号来构造隐藏层激活。为了使图CNN具有类似的能力,我们提出了一种在特征域上附加变换权值和偏差的再参数化方法。最后,卷积层的总训练参数由距离度量、顶点特征变换和偏差两部分组成。给定经过训练的度量和变换后的特征空间,可以构造更新的残差图。

在实验中,我们探索了在多个图形结构数据集(如化学分子和激光雷达产生的点云)上提出的光谱卷积网络。本文的创新点总结如下:

1.构造唯一图Laplacian 为每一批样本构造并学习唯一的剩余拉普拉斯矩阵,并将学习到的残差图拉普拉斯加入到初始(聚类或内在)样本中。

2.学习图更新的距离度量 通过学习数据间共享的最优距离度量参数,随着预测网络的训练,对图的拓扑结构进行更新。学习复杂度为,与输入大小无关。

3.在卷积中嵌入特征 顶点特征的转换是在把图的内点特征和内点特征连接起来之前进行的。

4.接受灵活的图形输入 由于1和2的存在,所提出的网络可以根据不同的图结构、大小以及对图度的限制,给出相应的网络。

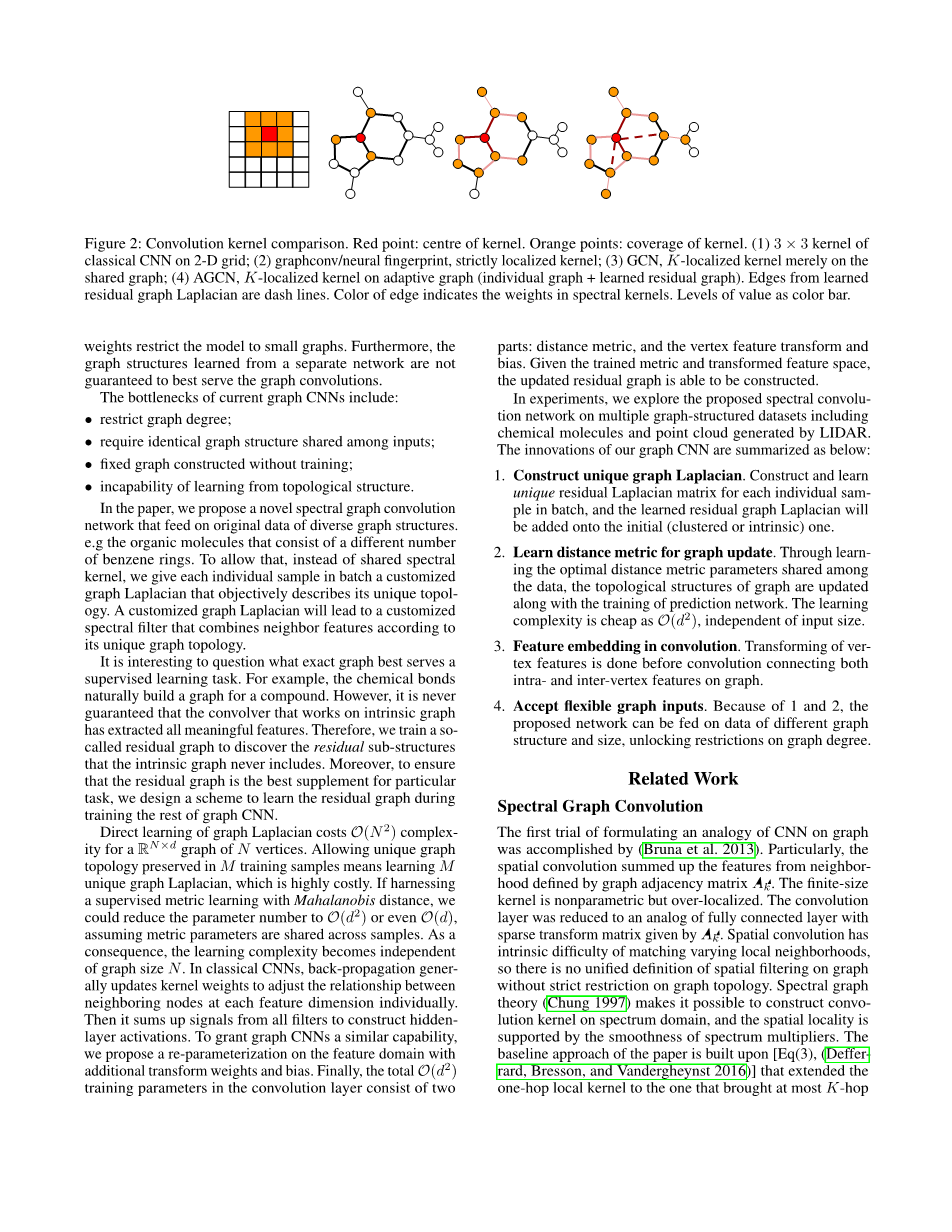

图2:卷积核比较。红点:内核的中心。橙色点:内核的覆盖范围。(1)二维网格上经典CNNs的3times;3核;(2)图/神经指纹,严格局部核;(3)GCN,K局部核仅在共享图上;(4)自适应图上的AGCN,K局部核(单个图学习残差图),学习的残差图拉普拉斯边是破折号线,边缘颜色表示光谱核的权重,作为颜色条的值级别。

2相关工作

2.1谱图卷积

(Bruna et al. 2013)完成了CNN在图上类比的第一次尝试,特别是空间卷积由邻接矩阵定义的邻域特征。有限大小核是非参数的,但过于局部化。利用给出的稀疏变换矩阵,将卷积层简化为完全连通层的模拟。空间卷积具有匹配变化的局部邻域的内在困难,没有严格的图拓扑约束,就没有统一的图空间滤波定义。谱图理论 (Chung 1997)使得在谱域上构造卷积核成为可能,空间局部性是由谱乘子的光滑性支持的。本文的基线方法是基于公式(3)建立的,它将单跳本地内核扩展到最多的K-Hop连接。根据图傅立叶变换,如果U是L的图傅立叶级数的集合,

diag()是L的频率分量。(Defferrard, Bresson, and Vandergheynst 2016)还利用切比雪夫多项式及其近似评估方案来降低计算成本和实现局部滤波。(Kipf and Welling 2016) 显示了切比雪夫多项式的一阶近似图滤波谱,这需要更少的训练参数。尽管如此(De Brabandere et al. 2016; Simonovsky and Komodakis.2017; Looks et al. 2017)已经开始构建更强调拓扑结构的定制图,甚至解锁输入图维数的约束,但设计一个更灵活的图CNN仍然是一个悬而未决的问题。

2.2分子图上的神经网络

对有机分子性质的预测通常采用手工制作的特征和特征嵌入 (Mayr et al. 2016; Weiss, Torralba, and Fergus.2009)。由于分子是自然模拟成图形的, (Duvenaud et al. 2015; Wallach, Dzamba, and Heifets 2015;Wu et al. 2017) 已经成功地尝试在原始分子上构建神经网络,用于学习表征。然而,由于空间卷积的限制,它们的网络未能充分利用原子连接性,这比少数键特征更能提供信息。最近在渐进网络、多任务学习和低射或单次学习方面已经完成了更多的探索 (Altae-Tran et al. 2016;Gomes et al. 2017)。到目前为止,最先进的分子网络 (Wallach, Dzamba, and Heifets 2015; Duvenaudet al. 2015)仍然使用非参数化的空间内核,无法充分利用空间信息。此外,拓扑结构也是判别特征的丰富来源。

3方法

3.1 SGC-LL层

为了使谱卷积核在不同的数据图拓扑中真正可行,我们对距离度量进行了参数化,使图Laplacian本身具有可训练性。利用经过训练的度量,我们动态地为不同形状和大小的输入样本构造唯一的图。新层采用基于自适应图的K局部化谱滤波器进行卷积。同时,对样本的拓扑结构进行更新,使训练损失最小化。新的带拉普拉斯学习的谱图卷积层被命名为SGC-LL。在这一部分中,我们介绍了SGC-LL层的创新之处。

学习图Laplacian 给定图G=(V,E)及其邻接矩阵A和度矩阵D,通过:

显然,L既决定了节点的连通性,又决定了顶点的程度。了解矩阵L是指知道图G的拓扑结构。由于L是一个对称正定矩阵,它的特征位置给出了由构成的一组特征向量U,其中N是顶点数。以U为图傅里叶基,对角化为。图傅里叶变换类似于欧氏空间上的傅里叶变换,定义为,将图信号x(主要是顶点特征)转换为基U所覆盖的谱域。由于图拓扑的谱表示为lambda;,所以谱滤波器在空间图上确实产生自定义卷积核。(Chung 1997) 告诉我们,由平滑的频率分量形成的光谱会导致局部的空间核。(Defferrard, Bresson, and Vandergheynst 2016)的主要贡献是将表述为多项式:

这给我们带来了一个K域核,它允许任意一对最短路径距离的顶点挤进去。而且,远距离连接意味着相似程度较低,并且由控制的重要性也会降低。多项式滤波器平滑了谱,而的参数化也迫使得到的核从中心顶点到最远处的K-跃点的权值呈圆形分布,这限制了内核的灵活性。更重要的是,两个顶点之间的相似性本质上取决于所选择的距离度量和特征域。对于部署在非欧氏域的数据,欧氏距离不再是度量相似性的最佳度量标准。因此,由于图的次优性,使得连通节点之间的相似度可能低于不连通节点之间的相似度。造成这一现象有两个可能的原因:

- 在特征提取和变换之前,在原始特征域中构造图形。

- 图拓扑是内在的,它仅仅代表物理联系,例如分子中的化学键。

为了解锁这些限制,我们提出了一种新的谱滤波器,它将Laplacian L而非系数参数化。给定原始Laplacian L,特征X和参数,函数F(L,X,)输出更新的Laplacian 的频谱,则滤波器如下:

最后,SGC-LL层主要表述为:

计算公式(5)的复杂度为,这是由于密集矩阵乘法造成的。如果近似为的多项式函数,并可递归计算,则由于Laplacian 的稀疏性,其复杂度将降至。我们选择与(Defferrard, Bresson, and Vandergheynst 2016)相同的切比雪夫展开来计算K阶的多项式。

图更新的训练度量 对于图结构的数据,欧几里得距离不再是度量顶点相似性的好指标。因此,在训练过程中,距离测量需要与任务和特征相适应。在度量学习的文章中,将算法分为监督学习和无监督学习 (Wang and Sun 2015)。在无监督方式下得到的最优度量使簇内距离最小化,并使簇间距离最大化。对于标记数据集,学习的目标是找到最小损失的度量。和之间的广义Mahalanobis距离表示为:

如果M=I,公式(6)减小到欧氏距离,在我们的模型中,对称正半定矩阵,其中是SGC-LL层的可训练权值之一。是对我们测量到之间欧氏距离空间的变换基。然后,我们用距离来计算高斯核:

对G进行归一化后,得到一个稠密邻接矩阵。在我们的模型中,最优度量是构造图Laplacian集最小化预测损失的方法。

特征变换的再参数化 在经典的CNNs中,卷积层的输出特征是最后一层的所有特征映射之和,这些特征映射是用独立滤波器计算出来的。这意味着新的特征不仅建立在相邻顶点上,而且还依赖于其他内部顶点特征。然而,在图的卷积上,对于同一图上不同顶点特征的拓扑结构的建立和训练是无法解释的。为了在SGC-LL层构造内点特征和间点特征的映射,在输出特征上引入了一个变换矩阵和偏置向量。在方程(5)的基础上,将输出特征的再参数化表述为:

在第一层,将变换矩阵和偏置双与度量一起训练,其中是特征维数。在每个SGC-LL层,我们都有学习复杂度的参数,与输入图的大小或程度无关。在下一个SGC-LL层,将在另一个具有不同度量的特征域中构建光谱滤波器。

余图Laplacian 一些图形数据具有内在的图形结构,如分子。分子图是以原子为顶点,键为边的。这些键可以通过化学实验证明是合理的。但是,大多数的数据都不具有自然的图形结构,因此我们必须先构造图,然后再将它们输入网络。除上述两种情况外,最有可能的情况是,以无监督方式生成的图不能充分表达特定任务所有意义的拓扑结构。

资料编号:[3208]