英语原文共 10 页,剩余内容已隐藏,支付完成后下载完整资料

Smart Reply: 电子邮件的自动回复建议

摘要

在本文中,我们提出并研究了一种新颖的端到端方法,它可以自动生成简短的电子邮件回复,称为“Smart Reply”。它产生了语义上不同的建议,可以完全作为电子邮件的回复,用户只需在移动设备上轻轻一击即可。该系统目前在Gmail的收件箱中使用,并负责协助10%的移动设备的电子邮件回复。它被设计成能够在非常高的吞吐量下工作,并且每天处理数亿条消息。该系统利用了最先进的、最大规模的深度学习。

我们描述了系统的架构,以及我们在构建它时遇到的挑战,比如回复的多样性和可伸缩性。我们还介绍了一种新的用户生成内容的语义聚类方法,它只需要少量显式标记的数据即可完成语义聚类。

1. 引言

电子邮件是网络上最流行的通信方式之一。尽管最近社交网络使用率有所增加,但电子邮件仍然是全球数十亿用户连接和共享信息的主要媒介。随着电子邮件负载的迅速增加,用户处理和回复消息的难度也越来越大。在移动设备上回复电子邮件的时间尤其紧迫。

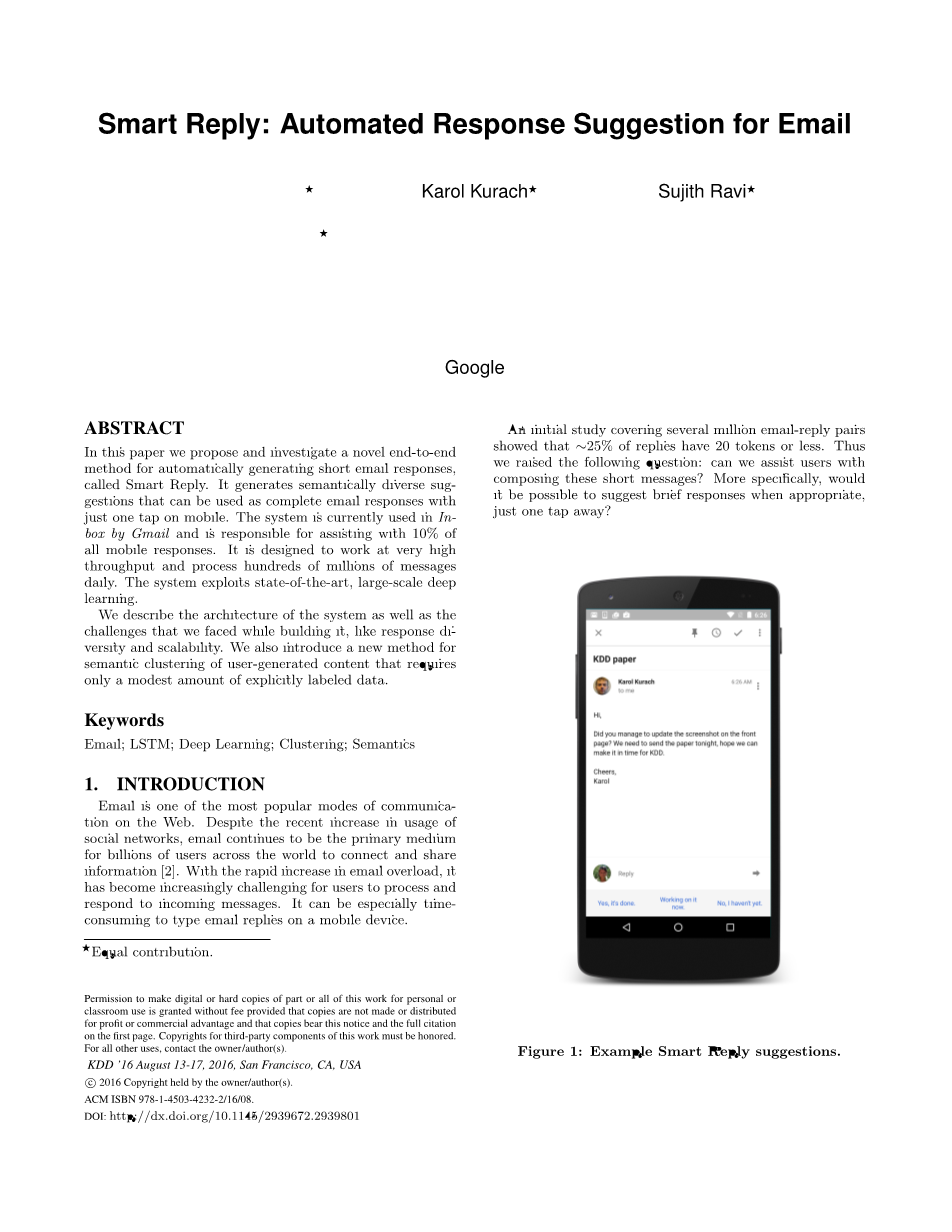

一项初步研究覆盖了几百万封邮件及其回复显示,25%的回复只有20个或更少的标记。因此,我们提出了以下问题:我们是否可以帮助用户编写这些短消息?更具体地说,在适当的时候,只要轻轻一击就能建议简短的回复。

图1: Smart Reply建议示例。

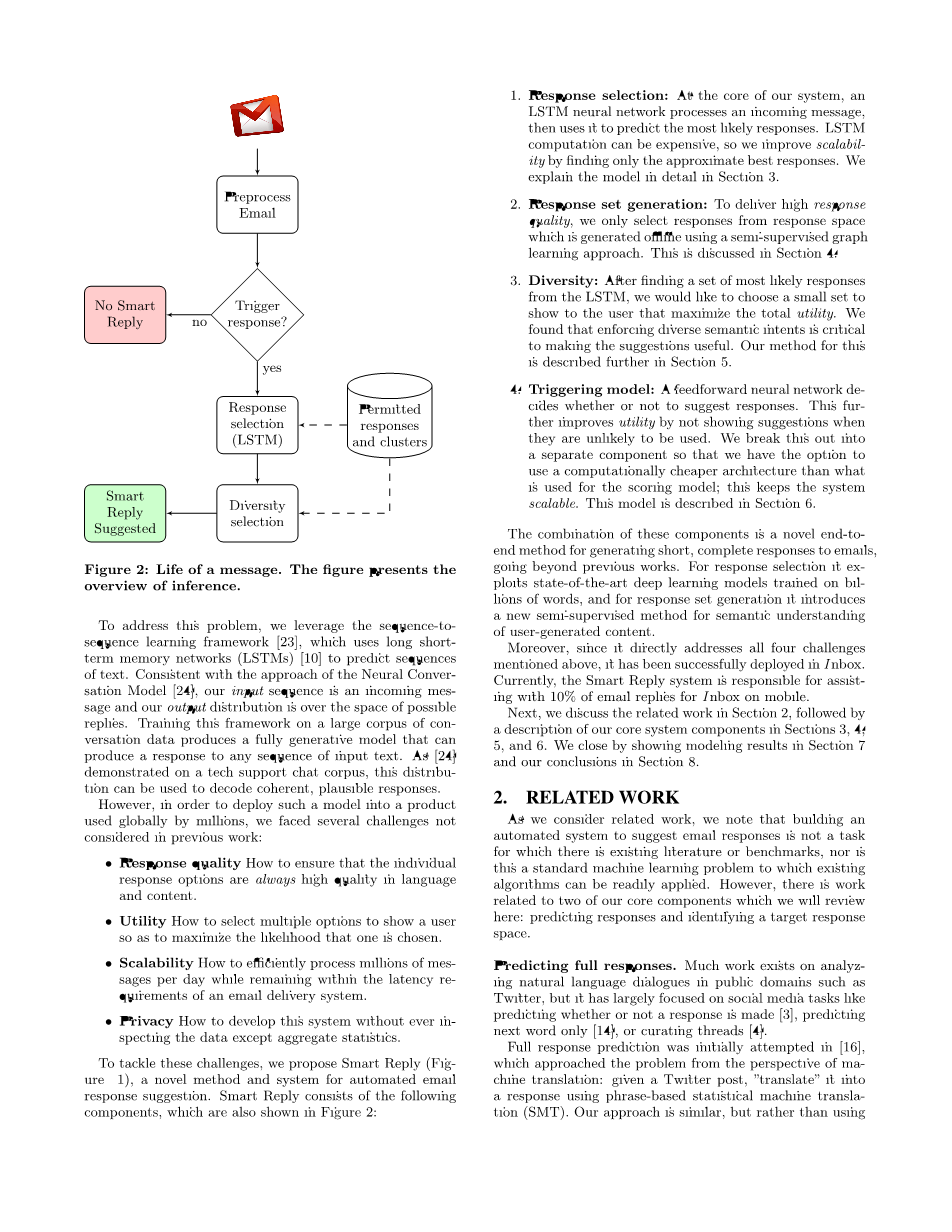

图2: 一条消息历经的生命形式。图中给出了推理的概述。

为了解决这个问题,我们利用序列到序列的学习框架,它使用长短期记忆网络(LSTMs)来预测文本序列。与神经会话模型的方法一致,我们的输入序列是一个传入消息,我们的输出分布在可能的回复空间上。在大量会话数据的基础上训练这个框架会产生一个完全生成的模型,它可以对任何输入文本序列产生回复。正如在技术支持聊天语料库中演示的那样,这种分布可以用于解码连贯的、可信程度高的回复。

然而,为了将这种模型部署到全球数百万人使用的产品中,我们面临着以前工作中没有考虑到的几个挑战。

bull; 回复质量 如何确保在语言和内容上,单个回复选项总是高质量的。

bull; 效率 如何选择多个选项来显示给用户,以最大化一个用户选择回复的可能性。

bull; 可扩展性 如何每天高效地处理数以百万计的消息,同时保持邮件发送系统的延迟需求。

bull; 隐私 如何在除了统计数据以外而不检查其他数据的情况下开发系统。

为了应对这些挑战,我们提出了Smart Reply (图1),这是一种新的自动化邮件回复建议的方法及系统。Smart Reply包含以下组件,如图2所示。

1. 回复选择: 在我们的系统的核心,一个LSTM神经网络处理传入的消息,然后使用它来预测最有可能的回复。LSTM计算开销可能非常高,因此我们通过只找到近似的最佳回复来提高可扩展性。我们在第3节详细解释模型。

2. 回复集生成: 为了提供高回复质量,我们只选择回复空间中的回复,这是使用半监督图学习方法离线生成的。这将在第4节中讨论。

3. 多样性: 从LSTM中找到一组最有可能的回复之后,我们想选择一个小的集合来显示给用户,使总效用最大化。我们发现,执行不同的语义意图对于使这些建议有用是至关重要的。我们的方法在第5节中进一步描述。

4. 触发模型: 前馈神经网络决定是否建议回复。当它们不太可能被使用时,这进一步改进了程序的效率。我们将其分解为一个单独的组件,这样我们就可以选择使用一个计算成本较低的体系结构,而不是用于得分模型的架构;这使系统具有可扩展性。该模型在第6节中描述。

这些组件的组合是一种新颖的端到端方法,用于生成对电子邮件的简短、完整的回复,超出了以前的工作。为了回复选择,它利用了最先进的深度学习模型,训练了数十亿个单词,并为回复集生成了一种新的半监督方法,用于语义理解用户生成的内容。

此外,由于它直接处理上面提到的所有四个挑战,它已经成功地部署到Inbox中。目前,Smart Reply系统负责协助10%的移动设备的Inbox的电子邮件回复。

接下来,我们将在第2部分中讨论相关工作,然后在第3、4、5和6小节中描述我们的核心系统组件。我们通过在第7节中展示模型结果和第8节的结论来结束全文。

2. 相关工作

在我们考虑相关工作时,我们注意到,构建一个自动化系统来建议电子邮件回复并不是现有的文献或基准测试的任务,这也不是一个标准的机器学习问题,现有的算法可以很容易地应用它。然而,我们将在这里回顾的两个核心组件的工作是:预测回复和确定目标回复空间。

预测全回复。 在诸如Twitter等公共领域的自然语言对话分析中,很多工作都是存在的,但它在很大程度上专注于社交媒体任务,比如预测是否做出回复、只预测下一个单词,或管理线程。

最初尝试了完整的回复预测,从机器翻译的角度解决了这个问题:给定一个Twitter帖子,用基于短语的统计机器翻译(SMT)将其翻译成回复。我们的方法是相似的,但是我们使用的是神经网络机器翻译模型,称为“序列到序列学习”。

序列对序列学习,利用长短期记忆网络(LSTMs)来预测文本序列,最初应用于机器翻译,但后来在图像字幕和语音识别等其他领域取得了成功。

其他近期的研究也应用了循环神经网络(RNNs)或LSTMs。作者依靠SMT系统生成n-best列表,开发出完全生成的模型。我们的方法最类似于神经会话模型,它使用序列到序列的学习来对技术支持聊天和电影字幕进行建模。

我们工作的主要区别在于,它部署在生产环境中,这产生了回复质量、效率、可扩展性和隐私的挑战。这些挑战在这些相关的工作中都没有被考虑到,因此促使我们在本文的其余部分解释我们的新解决方案。

此外,在这项工作中,我们接触到的领域主要侧重于社交媒体和电影对话。在这两个领域中,提供一个仅仅是相关或主题的回复都是可以接受的。另一方面,电子邮件经常表达一个请求或意图,必须在回复中处理。

识别目标回复空间。我们在这里的方法是基于Expander图学习方法,因为它适用于大数据(大量的电子邮件)和大的输出(许多不同的潜在语义意图)。虽然Expander最初是为知识扩展和分类任务而提出的,但是我们的工作是第一个使用它来发现来自用户生成内容的语义意图集群。

其他基于图形的半监督学习技术已经在过去被探索用于更传统的分类问题。但是,问题设置和任务本身与我们工作中处理的问题有很大的不同。

最后,我们注意到,Smart Reply是第一个同时解决这些任务的工作,并在一个单独的端到端、可部署系统中实现。

3. 选择回复

给定原始信息,Smart Reply系统的基本任务是找到最可能的回复。换句话说,给定原始消息o和所有可能回复的集合R,我们希望找到:

为了找到这个回复,我们将构建一个模型,它可以对回复进行评分,然后找到得分最高的回复。

接下来我们将描述模型是如何制定、训练和用于推理的。然后我们将讨论引入该模型的核心挑战,以大规模地提出高质量的建议。

3.1 LSTM模型

由于我们是在一个标记r的序列上评分的,所以这个问题是序列到序列学习的自然匹配。模型本身就是一个LSTM。输入是原始消息;输出是给定输入的回复标记序列的条件概率分布:

这种分布可以分解为:

首先,读入原始消息标记的序列,包括一个特殊的消息尾标记,这样,LSTM的隐藏状态编码了整个消息的向量表示。然后,给定这个隐藏状态,将计算并解释为,或第一个回复标记的概率分布。当回复标记被输入时,每个时间步骤 t中的softmax被解释为;考虑到上面的因数分解,这些softmax可以用来计算。

训练 考虑到大量的信息,训练目标是将观察到的回复的对数概率最大化,给出它们各自的原型:

我们用AdaGrad对这个目标进行随机梯度下降的训练。在一个消息语料库上运行10个轮次,这将在7.1节中描述。由于语料库的大小,使用TensorFlow库来进行分布式的训练。

我们的输入和输出词汇都是经过预处理后的训练数据中最常见的英语单词(第7.1节中描述步骤)。除了标准的LSTM公式外,我们还发现了一个循环投影层的增加,大大提高了收敛模型的质量和收敛时间。我们还发现梯度剪裁(用值1剪裁)对于稳定的训练是必不可少的。

推理 在推理时,我们可以在原始消息中进行输入,然后使用softmax的输出在每个时间步骤上获得词汇表上的概率分布。这些分布可以以多种方式使用:

1. 从回复分布中抽取随机样本;这可以通过在每个时间步骤中对一个标记进行取样并将其反馈到模型中来完成。

2. 给定原始的信息,近似最可能的回复。这可以通过在每次步骤中使用最有可能的标记并将其反馈回来来进行贪心的操作。一个不太贪心的策略是使用束搜索,即,取最上面的b个标记,并将它们填入,然后保留b个最好的回复前缀并重复。

表1: 生成的回复示例。

3. 确定某一特定候选回复的可能性。这可以通过输入候选的每个标记并使用softmax输出来获得下一个候选标记的可能性来实现。

表1显示了使用束搜索生成近似最可能的回复的一些例子。

3.2 挑战

到目前为止,给定一个传入的电子邮件消息,该模型可以生成连贯的、可信程度高的回复。然而,当将这个模型引入生产时,会出现几个关键的挑战。

回复质量 为了提供回复给用户,我们需要确保它们的风格、语气、措辞和内容都是高质量的。

考虑到模型是在真实信息的主体上进行训练的,我们必须考虑到最可能的回复不一定是高质量回复的可能性。即使是在我们的语料库中经常发生的回复,也可能不适合返回给用户。例如,它可能包含糟糕的语法、拼写或机制;在很多情况下,它可能会传达出一种不和谐或冒犯的感觉;它可能太不正式,与其他收件箱的智能功能相一致;它可能传达出一种政治上不正确、冒犯或不恰当的情绪。

虽然限制模型词汇表可能会处理一些简单的例子,比如脏话和拼写错误,但它不足以捕获广泛的变化性,例如,在政治上不正确的语句是可以实现的。相反,我们使用半监督学习(在第4节中详细描述)来构造一个目标回复空间R,它只包含高质量的回复。然后我们使用这里描述的模型来选择R中最好的回复,而不是词汇表中任何序列的最佳回复。

效率 我们的用户研究表明,当这些建议与原始信息高度相关并表达不同的意图时,建议是最有用的。然而,如表2中的第1列所示,模型的原始输出倾向于(1)支持普通但非特定的回复,(2)具有很少的多样性。

首先,为了提高回复的特异性,我们应用一些轻度的标准化,惩罚适用于广泛的传入消息的回复。这种标准化的结果可以在表2的第2栏中看到。例如,非常通用的“Yes!”已经从前十名中掉了出来。其次,为了增加向用户展示的选项的宽度,我们利用R的语义结构来执行多样性,我们将在第5节中讨论。结果也显示在表2的底部。

我们将通过一个触发模型(第6节中描述)来进一步改进建议的效率,从而决定是否应该生成建议。这降低了当它们不被使用的时候我们显示建议的可能性。

可扩展性 我们的模型需要在生产环境中进行部署,不能在邮件交付过程中引入延迟,因此可扩展性非常重要。

对每个候选回复进行详尽的评分,将需要 LSTM步骤,其中l是最长回复的长度。在以前的工作中,这是可以接受的,因为计算是在离线的批处理过程中执行的。然而,在邮件发送管道的上下文中,时间是一种更宝贵的资源。此外,考虑到人们交流的巨大差异以及我们希望覆盖的大量电子邮件场景,我们可以假设R非常大,而且只期望随着时间的推移而增长。例如,在一个1000万简短回复的统一样本中(比如,最多10个标记的回复),超过40%只出现了一次。因此,我们不会对每个候选进行详尽的评分,而是希望有效地搜索最佳回复,这样复杂性就不是的函数了。

我们的搜索工作如下。首先,R的元素被组织成一个trie。然后,我们进行从左至右的束搜索,但只保留在trie中出现的假设。这个搜索过程对于搜索大小b和最大回复长度l有复杂度O(bl), b和l通常在10-30的范围内,所以这种方法大大减少了查找顶部回复的时间,是使系统可部署的关键因素。就质量而言,我们发现,尽管这只搜索接近最好的

全文共13170字,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[14095],资料为PDF文档或Word文档,PDF文档可免费转换为Word