英语原文共 9 页,剩余内容已隐藏,支付完成后下载完整资料

单词和短语的分布式表示和他们的组合性

摘要

最近推出了连续Skip-gram模型是一种有效的学习的高质量分布向量表示的方法,高质量分布向量采集了大量精确的句法和语义的词的关系。在本文中,我们目前的几个扩展方向是提高向量的质量和训练速度。通过对高频词的第二次抽样 我们也获得显著的加速和学习更多的普通词表示。我们还设计了一个简单的可选择称为负采样的分层函数。

“词表示”的固有的局限性是其对词序和无法代表惯用短语的不关心。例如,“加拿大”和“空气”的含义不能轻易此获得“加拿大航空公司”。出于这个例子中,我们提出一个简单的方法寻找文本短语,并且展示学习良好的向量表示为数百万短语是可能的。

1 引言

向量空间中的单词分布式表现帮助了学习算法通过相似的单词组合更好的去实现,由自然语言处理的任务。最早用单词代表时间能追溯到1986年的Rumelhart, Hinton, 和 Williams【13】。这个想法已经应用到统计语言模型并取得巨大的成功【1】。之后的工作包括应用程序自动语音识别,机器翻译【14,7】和广泛NLP任务【2,20,15,3,18,19,9】

最近,Mikolov et al。[8]引入了Skip-gram模型,这是一种高效的手段来研究从大量的非结构化的文本数据得来的高质量文字向量。不像大多数前面使用用于学习词向量的神经网络结构,我们的方法使得训练非常的高效:在一台充分利用的机器上可以在一天内训练超过100亿个单词。

使用神经网络的“词表示”计算非常有趣,因为受训练的向量能准确的编码很多语言的规律和模式。有点令人吃惊的是,很多这样的模式可以表示成线性的翻译。举例来说,向量vec(“Madrid”) - vec(“Spain”) vec(“France”)的计算结果与向量vec(“Paris”)比其他向量更接近

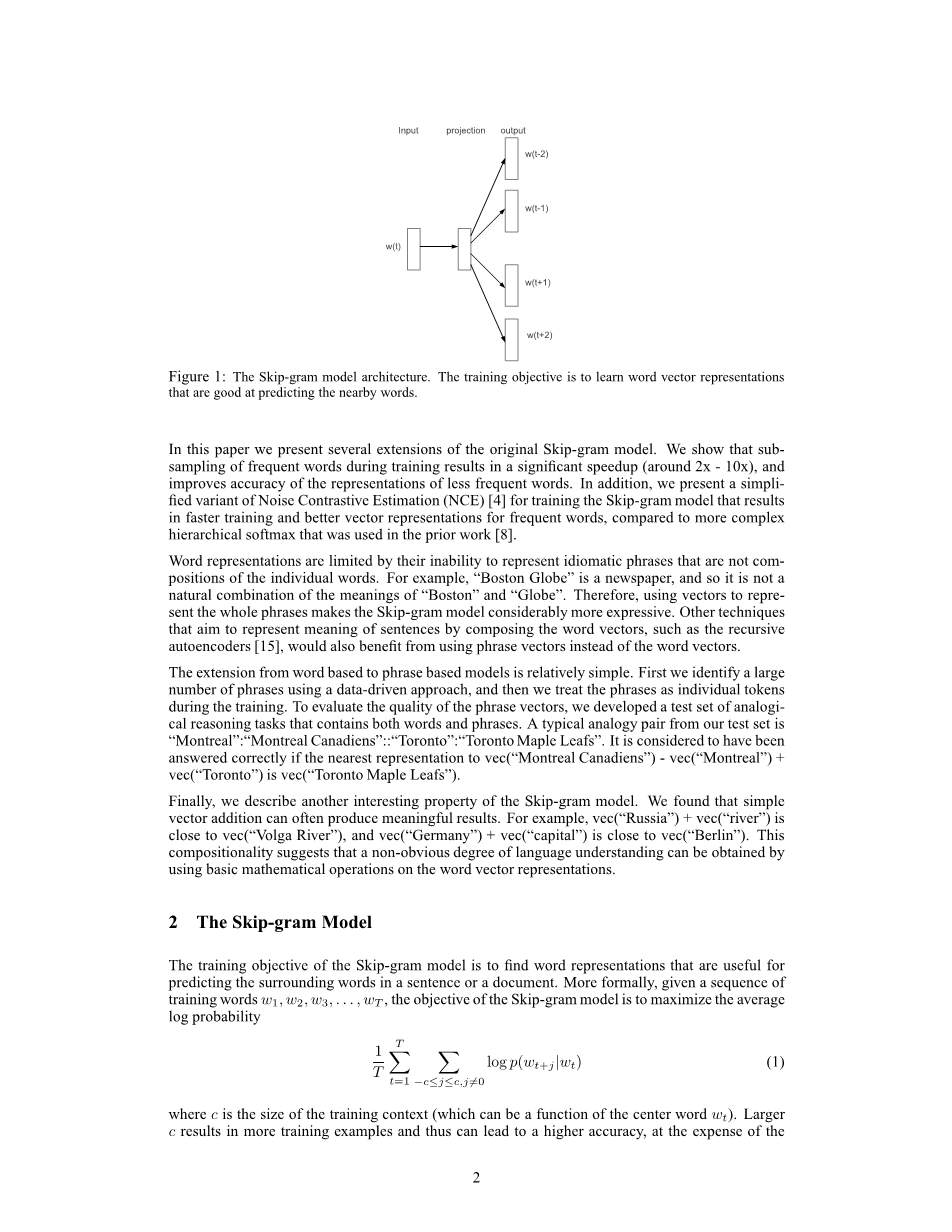

图像1:Skip-gram模型架构。这个训练模型是用来学习那种能很好预测临近单词的单词向量

在本论文中我们提出几个Skip-gram模型原型的扩展。我们给出在有效加速中(大约2X-10X)高频词的二次抽样,并且提高了不太高频词代表的准确性。另外,我们提出噪声对比评估(NEC)的简化,用于训练Skip-gram模型,这在快速训练和高频词优质向量表示上有效果。

“词表示”受限于它们无法表示不是单词组成的习语短语。 例如,“波士顿环球报”是一份报纸,因此它不是“波士顿”和“环球报”意义的自然组合。因此,使用向量来表示整个短语使得跳跃克模型显得更具表达力。 其他旨在通过合成单词向量来表示句子含义的技术,如递归自编码器[15],也可以使用短语向量而不是单词向量。

从基于词到基于短语的模型的扩展相对简单。 首先,我们使用数据驱动方法识别大量短语,然后在训练过程中将这些短语作为单个令牌处理。 为了评估短语向量的质量,我们开发了一个包含单词和短语的类比推理任务的测试集。 我们的测试集中的典型比喻是“蒙特利尔”:“蒙特利尔加拿大人”::“多伦多”:“多伦多枫叶队”。 如果对vec(“蒙特利尔加拿大人”) - vec(“蒙特利尔”) vec(“多伦多”)的vec(“多伦多枫叶队”)最近的表示法被认为已被正确回答。

最后,我们描述了Skip-gram模型的另一个有趣特性。 我们发现简单的向量添加通常可以产生有意义的结果。 例如,vec(“Russia”) vec(“river”)接近vec(“Volga River”),vec(“Germany”) vec(“capital”)接近vec(“Berlin”)。 这种组合性表明,通过对单词向量表示使用基本的数学运算,可以获得非显而易见的语言理解程度。

2 Skip-gram 模型

Skip-gram模型的训练目标是找出对于预测句子或文档中的周围词语有用的词语表示。 更正式地说,给定一系列训练词w1,w2,w3,...,wT,Skip-gram模型的目标是最大化平均对数概率

其中c是训练上下文的大小(可以是中心词wT的函数)。 较大的c会得到更多的训练示例,从而拥有更高的准确性,但会以训练时间为代价。 基本的Skip-gram公式使用softmax函数定义p(wt j| wt):

其中vw和vw#39;是w的“输入”和“输出”向量表示,并且W是词汇表中单词的数量。 这个公式是不切实际的,因为计算nabla;logp(wO | wI)的成本与W成正比,W通常很大(105-107个条件)。

2.1 分层Softmax

整个softmax的计算有效近似是分层softmax。 在神经网络语言模型的背景下,这个观点被Morin和Bengio首次提出[12]。 主要优点在于,不需要评估神经网络中的W输出节点来获得概率分布,而只需要评估log2(W)节点。

分层softmax使用W字作为叶子的输出层的二叉树表示,并且对于每个节点明确表示其子节点的相对概率。 这些定义了将概率分配给单词的随机游走。

更确切地说,每个单词w可以通过从树根开始的适当路径到达。 假设n(w,j)是从根到w的路径上的第j个节点,令L(w)为该路径的长度,所以n(w,1)= root和n(w,L (w))= w。 另外,对于任何内节点n,令ch(n)是n的任意固定子,如果x为真,则[[x]]为1,否则为-1。 然后,分层softmax将p(wO | wL)定义如下:

其中sigma;(x)= 1 /(1 exp(-x)),可以证实。 这意味着计算logp(wO | wL)和nabla;logp(wO | wL)的成本与L(wO)成正比,且平均不大于logW。 而且,不同于分配两个表示vw 和vw#39; 和每个词w的Skip-gram的标准softmax公式,分层softmax公式对于每个词w具有一个表示vw,对于二叉树的每个内部节点n具有一个表示vn#39;。

分层softmax使用的树的结构对性能有相当大的影响。 Mnih和Hinton探索了许多建立树结构的方法以及对训练时间和模型精度的影响[10]。 在我们的工作中,我们使用二元霍夫曼树,因为它将短码分配给频繁词汇进而导致快速训练。 之前已经观察到,通过它们的频率将单词分组在一起可以很好地用作基于神经网络的语言模型的非常简单的加速技术[5,8]。

2.2 负抽样

分层softmax的一个替代方法是噪声对比估计(NCE),它是由Gutmann和Hyvarinen [4]引入的,并应用于Mnih和Teh的语言建模[11]。 NCE认为,一个好的模型应该能够通过逻辑回归来区分数据和噪声。 这与Collobert和Weston [2]使用的枢纽损失类似,他们通过将数据排列在噪声之上来训练模型。

虽然NCE可以显示为近似最大化softmax的对数概率,但Skipgram模型只关心学习高质量向量表示,所以只要向量表示保持其质量,我们就可以自由地简化NCE。 我们根据目标定义负样本(NEG)

由PCA预测的国家和资本向量

图2:国家及其首府城市的1000维Skip-gram向量的二维PCA投影。 该图说明了该模型能够自动组织概念并隐含地了解它们之间的关系,因为在培训期间,我们没有提供关于首都城市意味着什么的任何监督信息。

它用于替换Skip-gram目标中的每个logP(wO | wL)项。 因此,任务是使用逻辑回归来区分目标单词WO与噪声分布Pn(w)的图,其中每个数据样本有k个负样本。 我们的实验表明,k值在5-20范围内对于小型训练数据集是有用的,而对于大型数据集,k可以小至2-5。 负采样和NCE的主要区别在于NCE需要样本和噪声分布的数字概率,而负采样只使用样本。 尽管NCE大约使softmax的对数概率最大化,但这个属性对于我们的应用并不重要。

NCE和NEG均具有作为自由参数的噪声分布Pn(w)。 我们研究了Pn(w)的一些选择,发现单调分布U(w)上升到3/4次幂(即U(w)3/4/Z)明显优于单调分布和均匀分布, 在我们尝试过的每个任务中都包括NCE和NEG,包括语言建模(这里没有报道)。

2.3 高频词的抽样

在非常大的语料库中,最常见的单词可能容易出现数亿次(例如“in”,“the”和“a”)。 这些单词通常比罕见单词提供更少的信息价值。 例如,虽然Skip-gram模型受益于观察“法国”和“巴黎”的共现,但从观察到“法国”和“该”的频繁共现并不能有所收获,因为在“the”的句子中频繁发生。 这个想法也可以用于相反的方向; 训练数百万个例子后,频繁词的向量表示没有显着变化。

为了对付罕见词和常用词之间的不平衡,我们使用了一种简单的子采样方法:训练集中的每个词wi被丢弃,概率由公式

|

Method |

Time [min] |

Syntactic [%] |

Semantic [%] |

Total accuracy [%] |

|

NEG-5 |

38 |

63 |

54 |

59 |

|

NEG-15 |

97 |

63 |

58 |

61 |

|

HS-Huffman |

41 |

53 |

40 |

47 |

|

NCE-5 |

38 |

60 |

45 |

53 |

|

The follo |

wing results use |

10minus;5 subsamplin |

g |

|

|

NEG-5 |

14 |

61 |

58 |

60 |

|

NEG-15 |

36 |

61 |

61 |

61 |

|

HS-Huffman |

21 |

52 |

59 |

55 |

表1:在[8]中定义的类比推理任务上的各种跳跃式300维模型的准确性。 NEG-k表示对每个正样本使用k个负样本的负样本; NCE代表噪声对比估计,HS-Huffman代表基于频率的霍夫曼编码的分层Softmax。

其中f(wi)是单词wi的频率,t是一个选定的阈值,一般在10-5左右。 我们选择这个子采样公式是因为它在保留频率排序的同时积极地抽样频率大于t的词。 虽然这个子采样公式是启发式选择的,但我们发现它在实践中运作良好。 它会加速学习,甚至可以显着提高罕见单词的学习向量的准确性,这将在以下各节中介绍。

3 实验结果

在本节中,我们评估分层Softmax(HS),噪声对比估计,负抽样和子样本。 我们使用Mikolov等人提出的类比推理任务。[8]。 该任务由类似于“德国”:“柏林”::“法国”的类比组成,通过找到一个向量x来解决vec(x)与vec(“Berlin”) - vec(“Germany “) vec(”法国“)根据余弦距离(我们丢弃搜索中的输入词)。 如果x是“Paris”,这个特定的例子被认为已经被正确回答。 该任务有两大类:句法类比(如“快速”:“快速”:“慢”:“缓慢”)和语义类比,如从国家到首都的关系。

为了训练Skip-gram模型,我们使用了一个由各种新闻文章组成的大型数据集(一个内部Google数据集,有十亿字)。 我们在训练数据中丢掉了所有出现少于5次的单词,结果产生了一个大小为692K的词

全文共13067字,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[9492],资料为PDF文档或Word文档,PDF文档可免费转换为Word