英语原文共 10 页,剩余内容已隐藏,支付完成后下载完整资料

利用三维卷积神经网络去噪回声器点云数据

1.摘要

据估计,世界上80%以上的海洋是未经探索和未经开发的,这限制了我们对海洋系统的理解。随着数据收集率的现代调查技术,如大片多波束回声测深仪(MBES)和海底2030等举措的利用,收集的海底数据量不断增加。 这些大数据量围绕质量保证和验证提出了严峻挑战,目前的方法往往需要人工输入。本研究的目的是检验将新的三维卷积神经网络模型应用于问题的有效性,从MBES点云数据中去除噪声,以期提高水深数据处理的自动化程度。从搁置测试集报告的结果显示有希望的性能与体素化点云数据的分类准确率为97%,kappa评分为0.94。在生产加工管道中部署经过充分训练的模型可能是变革性的,它减少了将原始MBES点云数据带到水深数据产品所需的人工干预。

水深测量是对水深的研究和测量,是航海、港口管理、近海石油和资源勘探及生境测绘等各个领域的基础 海洋保护。从历史上看,水深数据是用一条铅(或测深)线收集的;一条带重物的绳子,从船上垂下来,直到重物击中海底(Diersse和The-Berge,2016年)。现代调查通常使用安装在测量船上的多波束回声测深仪(MBES),每秒钟采集数千次深度测量,大大提高了测深率,获取深度数据以及空间覆盖。然而,现代MBES系统由于所收集的大量数据需要大量处理而带来了一些挑战。我们需要一些方法使数据能够有信心地使用(Calder和Mayer,2003年)。

MBES数据中的误差和噪声类型因下列因素而有很大差异:使用的MBES系统的类型、海况、MBES设置、校准和水柱条件 .此外,通过水柱中物体的存在(例如,鱼群)、船只空化产生的气泡、海底的类型、通过WA的声速的局部变化,噪声也会增加.(Arge等人,2010年)。

目前处理MBES点云数据所使用的技术包括应用统计过滤器和人工检查和清洗,其中可以包括对Soin的逐点检查 .目前的技术有许多缺点,包括加工时间长,缺乏重现性,往往需要对不同领域的参数进行调整,需要大量的技术支持,并提供有限的可伸缩性。特别是在处理用于导航产品的数据时,自动化处理工具往往不能提供一致的准确度和自然恢复到更多的半手性处理。

开发新的科学产品(如图表、地图、高程模型等)的费用因此,不仅对数据收集费用(实物调查和购买设备)敏感, 但也包括数据处理、处理和分析的费用;限制社会在缺乏直接经济必要性的领域(例如发展)产生感兴趣的测深数据产品的能力和国家)。

随着Seabed2030项目(日本财团-GEBCO,2018年)等数据量和举措的不断增加,旨在“到2030年绘制世界洋底最终地图”的新计算、处理和去噪MBES点云数据需要L技术。本文对深度学习卷积神经网络的应用进行了研究,对MBES点云数据进行去噪。机器学习(一门教计算机识别数据模式的科学),特别是深度学习(机器学习的一个分支 分层人工神经网络)在一些预测挑战中表现出优异的表现(Yann Le Cun等人,1997年;LeCun等人,2015年;Jain和Seung,2009年;Krizhevsky等人,2012年) .深度学习模型能够从大型预先标记的数据集中学习正确分类新的未见数据所需的复杂非线性函数(LeCun等人,2015年)。

受哺乳动物视觉系统研究的启发(Goodfello等人,2016年),卷积神经网络(CNNs)一直是机器学习和计算机视觉任务的最新进展的核心 从对象识别中ing(Krizhevsky等人,2012年),(Gondara,2016年;He等人,2015年),Semantic分割(Drozdzal等人,2016年;Ronneberger等人,2015年;Mao等人,2016年;Noh等人,2015年;洪 等人,2015年;Shel-hamer等人,2016年;Long等人,2014年)和图像去噪(Jain和Seung,2009年;Xie等人,2012年;Kim等人,2017年;Vincent等人,2010年;Mao等人,2016年)到超分辨率( 杨等人,2017年;毛等人,2016年);CNNs在应用于所有这些任务时表现良好。与其他人工神经网络结构一样,CNN由许多神经元组成 将输入转换为所需输出的ERS(例如,图像分类标签或分割的图像掩码)。CNNs包含在移动窗口ac中应用变换滤波器的卷积层 罗斯一个图像,并在这样做,学会选择与他们正在被训练执行的任务相关的功能。美国有线电视新闻网(CNN)根据标签上的数据进行训练,通过一个备份程序来学习 通过随机梯度下降的误差(LeCun等人,2015年)(或其变体)。

在光检测和测距(Lidar)数据中的目标检测和分类中,CNNs被应用于点云数据(Prokhorov,2010年;Xu等人,2018年),包括末端机动车两数量检测(Maturana和Scherer,2015b)。Matur-ana和Scherer(2015a)提出了一种三维CNN架构,用于快速、准确地对Lidar Poin进行分类 称为Vox-net的云数据,“体素”是一个像素的3D等价物,有几个原因,比如CNNs是一个很好的选择三维对象分类。最主要是模型的明确使用和数据的空间结构。由于数据是三维的,核滤波器是立方体,卷积是沿着输入特征图的宽度、高度和深度计算的。在训练数据中,三维CNN训练的误差与其二维等效值相同。

本文研究了三维卷积神经网络是否可以用于去噪MBES点云数据。据我们所知,这是第一次尝试使用CNNs 去噪三维MBES点云数据的问题。

在本文的背景下,我们没有区分不同类型的错误,并指的是所有不被认为表示海底为“噪音”的探测。很有可能是消息来源 噪声来自随机测量误差、系统偏差或严重误差/偏差(例如)的组合。鱼学校,泡泡)。

本文所解决的问题类似于图像的语义分割,其中模型被训练来进行像素级标签预测。我们扩展了二维图像段问题到三维,其中二进制接受/拒绝预测是在体素阵列上进行的。在二维图像上表现出良好性能的CNN模型体系结构是自适应的,并进行了测试。这些模型是使用MBES点云数据进行训练的,由Ba-Millistry分析人员使用标准分析技术和专家判断进行处理。评估模型对PRA的性能,然后使用模型预测对点云数据进行滤波,然后对点云数据进行栅格化,生成测深DEM(数字高程模型),以便与从经过专家处理的数据中得出的水深表面。

2.资料,材料

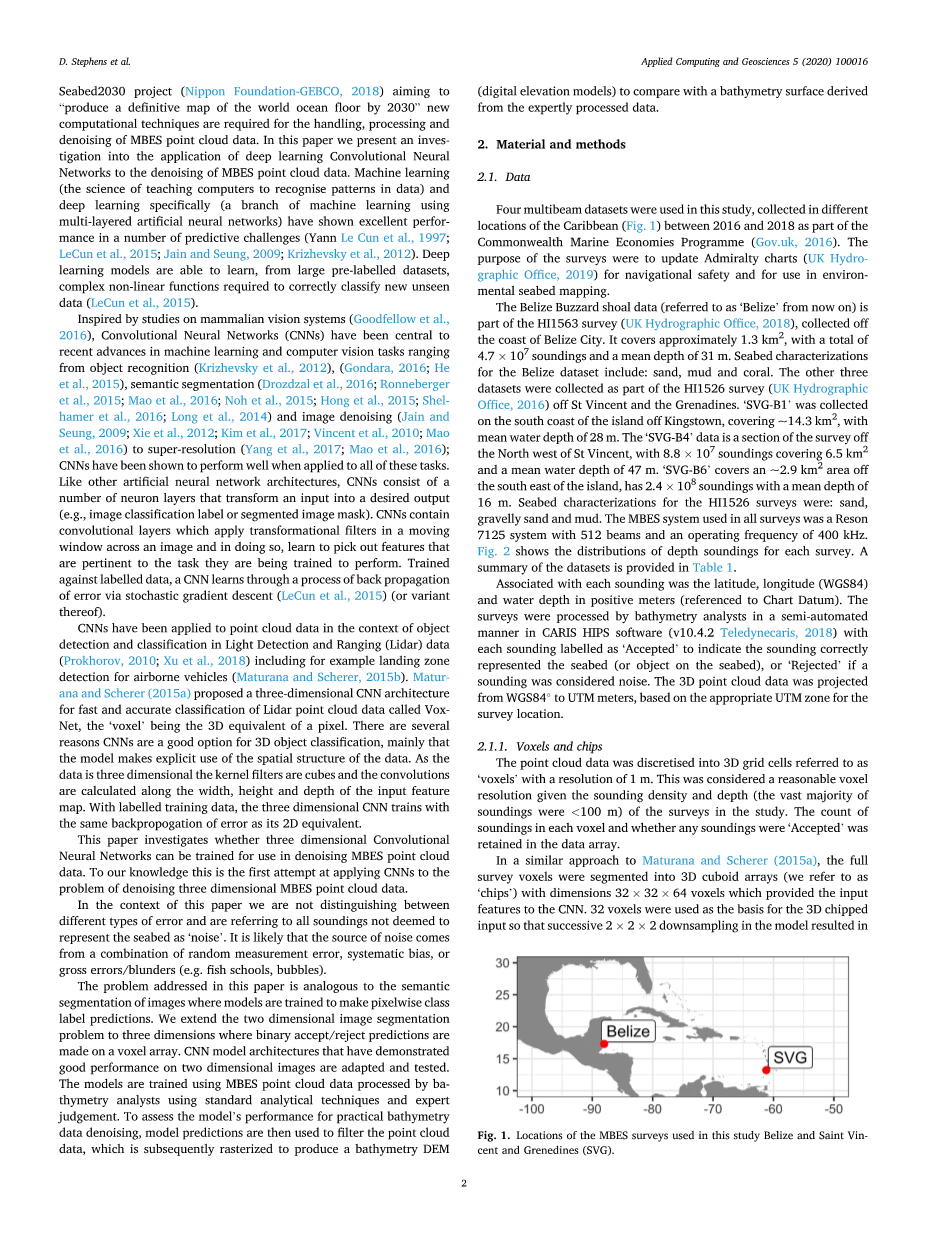

在本研究中使用了四个多波束数据集,都是从加勒比不同地区收集置(图。1)2016年至2018年期间,作为英联邦海洋经济方案的一部分(Gov.uk,2016年) 。调查的目的是更新金钟海图(英国水文制图办公室,2019年),以确保航行安全和用于环境-精神海底绘图。伯利兹Buzzard浅滩数据(从现在起称为“伯利兹”)是在伯利兹市沿海收集的HI1563调查(英国水文局,2018年)的一部分。面积约1.3平方公里 ,共计4.7*10^7次测深,平均深度31米。其他三个数据集是作为HI1526调查的一部分收集的。“SVG-B1”是在金斯敦附近岛屿的南岸收集的,面积约14.3平方公里,平均水深28米。 在圣文森特岛西北部的一段勘测中,8.8*10^7次测深面积为6.5平方公里,平均水深为47米。 2.4*10^8次探空,平均深度16m.HI1526调查的海底特征是:砂、砾石砂和泥。在所有调查中使用的MBES系统是一个Reson7125系统,有512根光束,工作频率为400K 赫兹。图2显示每次调查的深度测深分布情况。数据集的摘要见表1。

与每次测深有关的是纬度、经度(WGS84)和水深(以正米计)(参照海图基准)。这些调查是由测深分析员在半自动进行。在CARIS HIPS软件(v10.4.2Teledynecaris,2018)中,每个测深标记为“接受”,以表明测深正确地代表海底(或海底物体),或“拒绝” 以表明一个声音被认为是噪音的话。三维点云数据是根据适当的UTM区域为调查地点从WGS840米投影到UTM。

2.1体素和芯片

点云数据被离散成三维网格单元,称为“体素”,分辨率为1米。考虑到探测密度和深度(v),这被认为是一个合理的体素分辨率 大多数测深是lt;100米)的调查在研究中。每个体素中的测深计数以及是否有任何测深被“接受”保留在数据数组中。

在一种类似于Maturana和Scherer(2015a)的方法中,将完整的调查体素分割成三维长方体阵列(我们称之为“芯片”),其尺寸为32、32、64体素,提供了输入数据。以32个体素作为三维切屑输入的基础,使模型中连续的2times;2times;2下采样产生具有有效大小(均匀尺寸)的特征映射输出。

Fig. 1. Locations of the MBES surveys used in this study Belize and Saint Vin- cent and Grenedines (SVG).

正如CNNs训练中常见的那样,输入数据在0-1范围内被缩放。这是使用mineth;n=100;1SOH,其中n是每个体素内的探测次数,其值为100,而不是最大值。之所以被用来缩放,是因为每个体素的探测分布是高度倾斜的,一些体素的探测密度很大,约几千次探测。这会导致大多数体素的值为零,一旦缩放,将对训练模型产生不利影响。大多数体素的探测频率lt;100(第95百分位数) 每个体素的探测值为84,见图4.

垂直芯片尺寸(64体素)被选择为水平的两倍。这样做是为了试图捕捉深度数据的完全垂直传播。芯片是垂直中心的,围绕芯片内探测的平均值和扩展的水平芯片大小(即32米)高于和低于平均值。超出芯片范围的声音被丢弃,见图5。芯片平均深度在0米(用黄色方格表示),探测范围以外去掉了zlt;32m(其中z是平均芯片深度)。这意味着芯片并不总是能捕捉到数据的整个垂直传播,因为在某些地区,噪声出现在远高于或高于现的z值。虽然以这种方式丢弃的大多数数据在训练数据中被标记为“拒绝”,但在一些陡坡良好数据(“接受”探测)的地区,有时会丢失,但丢失数据的芯片百分比很小(~4%),这在讨论中得到了进一步的解决,并用于培训该模型的调查集中在沿海浅滩地区,其中大部分是索恩地区,末端深度小于100米(图1)。为了对模型进行合理的训练,只使用zlt;75m和Ngt;10测深的芯片来训练模型。

概括地说,CNN的投入和产出是:

输入数据:具有形状和深度数据的三维长方体阵列,如图所示,每个体素中只有一个输入通道对应于在0到1之间缩放的测深密度。列车员标签是每个体素的类标签的二进制表示,0个体素包含零个“接受”测深;1/4个体素包含gt;0个“接受”测深。

输出数据:训练后的模型将输出体素二进制类化,每个体素被分配一个概率,对应于它是否包含“接受”数据。然后将其分类为 使用0.5的阈值“接受”或“拒绝”。

2.2.实验

测试的CNN架构基于UNet的修改版本,该版本首先用于生物医学图像分割(Ronneberger等人,2015年)。它是通过使卷积得到的减少网络中卷积层的数量,以重新调整输入尺寸的较小尺寸。UNet是对称的。

具有收缩和扩展部分的体系结构,这有时被称为编码器解码CNN模型。收缩部分中的卷积层学习(“编码”)特征,这些特征是这个问题很有用。用于展开部分重建或解码图像或在这种情况下三维阵列,输出体素预测。在解决问题上有三个单元,每个单元有两个3D卷积,然后是直切线性激活函数和随后的最大池层。在每个下采样(最大池),fifilter核的数量流出(从而将特征通道的数量加倍到下一层)。扩展部分中的每个单元由3D上采样和三个卷积层组成..批量正常化是在每个卷积层之后,在激活函数之前(Ioffe和Szegedy,2015年)。模型的全部细节见补充材料部分。

对3、5和7的卷积核大小进行了测试,但由于计算机内存限制,不可能对所有模型进行较大的核大小。不同数量的卷积滤波器 也进行了测试(16、32和64)。在所有实验中,fifilters的步长为1是恒定的。为了使输出特性具有与输入相同的大小,对输入进行零位转换 应用了处理层和池层(在Keras中称为填充1/4lsquo;相同rsquo;模式),最后一层使激活函数进行体素化二值化。

对于所有的实验,批大小都是固定在16,这是由于GPU内存的限制。使用RMSprop优化器对模型进行了培训(Hinton等人,2018年),该优化器将二进制最小化损失函数。20%的训练集是随机抽样的,在训练时用作验证集 。训练开始时的学习率设置为0.001,如果没有观察到验证集损失的改善,则减少10倍。所有的模型都是 100个周期内训练完成。如果没有观察到验证集损失的改善,则使用早期停止(16个周期)。在训练模型时,数据得到了增强。已经证明增强可以有效地防止CNN模型过度拟合(Simard等人,2003年;Ciresan等人,2010年)。使用自定义数据生成器函数通过在z轴周围旋转每个芯片的随机量来增加上每个批次的训练数据。

该模型是使用“SVG-B4”、“SVG-B6”和“伯利兹”调查进行培训的。为了防止我们的模型过于适合某一特定的调查,从每个调查中抽取相同数量的芯片进行训练。 这等于调查的芯片数量最小化,其余的芯片将用作测试集(详见表2)。整个“SVG-B1”数据集被预留为传统的测试集,因为重要的是验证模型能够在一个全新的看不见的区域中表现良好。

该模型是使用“SVG-B4”、“SVG-B6”和“伯利兹”调查进行培训的。为了防止我们的模型过于适合某一特定的调查,训练中每一次调查都取了相同数量的筹码一套。这等于调查的芯片数量最少,其余的芯片将用作测试集(详见表2)。整个“SVG-B1”数据集被预留为传统的测试集,因为重要的是验证模型能够在一个全新的看不见的区域中表现良好。

通过计算了一系列统计数据,来评估模型对测试和验证集中每个体素的状态标签的预测程度。准确性统计量和Jaccard指数(Jaccard,1912年)(也称交叉路口)以及二元交叉熵度量进行了计算。同时,计算了多个统计数据,

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[239099],资料为PDF文档或Word文档,PDF文档可免费转换为Word