英语原文共 7 页,剩余内容已隐藏,支付完成后下载完整资料

CheXNet:基于深度学习的胸部x光专业疾病检测

摘要

胸部X线检查是许多肺部疾病筛查和诊断最常用的放射学检查方法之一。 许多现代医院的图像存档和通信系统(PACS)中存储了大量的X射线成像研究和放射学报告。 另一方面,如何将这种包含宝贵成像信息学(即松散标记)的医院规模知识数据库用于促进数据渴望的深度学习范式,以构建真正意义上的大型数据库高精度计算机辅助诊断(CAD)系统,这仍然是一个悬而未决的问题。

我们开发了一种算法,可以在超过放射科医师的水平上基于胸部X射线检测肺部疾病。我们的算法CheXNet是一个在ChestX-ray14上训练的121层卷积神经网络,ChestX-ray14是目前最大公开可用的胸部X射线数据集,包含超过100,000个14种疾病的正面X射线图像,四位执业学术放射学家对一套测试集进行了注释,我们将CheXNet与放射科医师的性能进行了比较。我们发现CheXNet在F1指标上的平均比例超过了平均水平。我们扩展了CheXNet以检测ChestX-ray14中的所有14种疾病,并获得所有14种疾病的最优结果。

- 概述

仅在美国,每年就有100多万成年人因肺炎住院治疗,每年约有50,000人死于该疾病(CDC,2017年)。胸部X光片是目前诊断肺炎的最佳方法(WHO,2001),在临床护理(Franquet,2001)和流行病学研究(Cherian,2005)中发挥着至关重要的作用。 但是,检测胸部X光片中的肺炎是一项具有挑战性的任务,它依赖于专家的放射科医师。在这项工作中,我们提出了一个模型,可以在超过放射科医师的水平上基于胸部X光片自动检测肺部疾病。

我们的模型ChexNet(如图1所示)是一个121层的卷积神经网络,输入胸部X射线图像并输出肺炎的概率以及局部区域关于肺炎可能性的热图。我们对最近发布的ChestX-ray14数据库(Wang,2017)通过CheXNet网络进行训练,该数据库包含112120个单独标注14种不同胸部疾病(包括肺炎)的正面胸部X射线图像。 我们使用密集连接(Huang et al,2016)和批量标准化(Ioffe&Szegedy,2015)来优化这种深度网络。

放射科医师检查胸部X光片中的肺炎是很困难的。X射线图像中肺炎的出现往往是模糊的,可以与其他诊断相重叠,并且可以模拟许多其他良性畸形。 这些差异在放射科医师诊断肺炎方面造成了相当大的变异性(Neuman,2012; Davies等,1996; Hopstaken等,2004)。为了综合评估放射科医师的表现,我们收集了四名执业学术放射科医师对来自ChestX-ray14的420张图像的一部分的注释。在这420幅图像中,我们测量比较了个体放射科医师和模型的表现。

我们发现我们提出的模型超出了肺炎检测任务的平均值。为了将CheXNet与之前使用ChestX-ray14的工作进行比较,我们对CheXNet进行了简单的修改,以检测ChestX-ray14中的所有14种疾病,并发现我们超过了所有14种疾病的最佳已存在结果。在专家级放射科医生的水平上自动检测胸部X光的疾病不仅在临床环境中具有巨大的优势,而且对于向诊断影像专家接触不足的人群提供医疗服务也是非常宝贵的。

图1. CheXNet是一个121层卷积神经网络,将胸部X射线图像作为输入,输出病理概率。 在这个例子中,CheXnet正确地检测出肺炎,并将图像中最能指示病理的区域局部化。

-

CheXNet模型

- 模型表述

肺炎检测任务是二元分类问题,其中输入是正视胸部X射线图像X并且输出是分别指示肺炎的存在或不存在的二元标签yisin;{0,1}。 对于训练集中的单个示例,我们优化加权二进制交叉熵损失:

其中p(Y = i|X) 是网络判别图片是否为第i种疾病的概率,w = |N|/(|P| |N|)和wminus; = |P |/(|P | |N |) 代表着训练集中有病和没有病种类的权重,用来加强收敛。

-

- 模型结构与训练

CheXNet是在ChestX-ray14数据集上训练的121层密集卷积网络(DenseNet)(Huang et al,2016)。 DenseNets通过网络改善信息流和梯度,使得对非常深的网络进行优化处理。 我们用一个具有单输出的完全连接层替换,然后我们应用S形非线性。

网络的权重通过在ImageNet上预训练的模型的权重进行初始化(Deng et al,2009)。 该网络使用Adam以标准参数(beta;1=0.9和beta;2=0.999)进行端对端训练(Kingma&Ba,2014)。 我们使用规模为16的最小批量训练模型。我们使用0.001的初始学习率,每次验证损失高原后,衰减10倍,并选择最低验证损失的模型。

-

数据处理

- 训练部分

我们使用Wang等人发布的ChestX-ray14数据集(2017),其中包含30805名独特患者的112120张正面X射线图像。Wang等人(2017)使用放射学报告中的自动提取方法为每幅图像注释多达14种不同的胸部病理标签。 我们将具有肺炎的图像标记为注释病理之一,并将所有其他图像标记为否定例子。 对于肺炎检测任务,我们将数据集随机分为训练(28744例患者,98637图像),验证(1672例患者,6351图像)和测试(389例患者,420例图像)。各组之间没有重复的图片。

在将图像输入网络之前,我们将图像缩小到224times;224,并基于ImageNet训练集中图像的平均值和标准偏差进行归一化。 我们还通过随机水平翻转来增强训练数据。

-

- 测试部分

我们收集了420个正面胸部X光片的测试集,其中有独立于斯坦福大学的四位放射科医师,他们被要求标注Wang等人的所有14种病理学(2017年)。 放射科医师拥有4年,7年,25年和28年的经验,其中一位放射科医师是经过胸部放射科医师培训的亚专科医师。 放射科医师无法获得任何患者信息或数据中疾病流行的知识。标签被输入一个标准化的数据输入程序。

-

CheXNet与放射专家的结果比较

- 两者比较

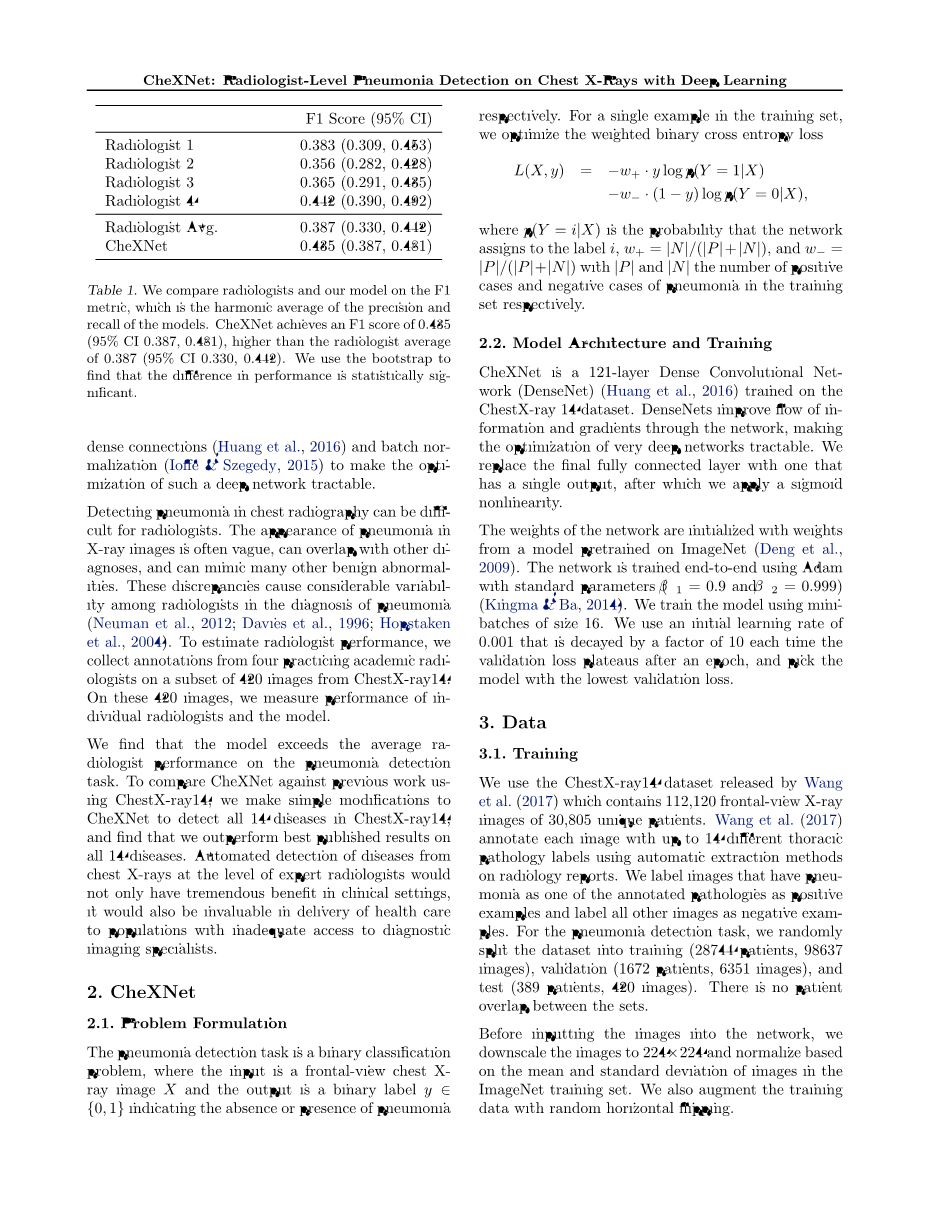

我们评估放射科医师和CheXNet在肺炎检测任务测试集上的表现。回想一下,对于测试集中的每个图像,我们都有来自四名执业放射科医生的4个标签和来自CheXNet的1个标签。我们计算每个放射科医师的F1分数和CheXNet对其他4个标签中的每一个的F1分数作为基础事实。我们报告了每个放射科医师和CheXNet的4个F1得分的平均值,以及放射科医师的平均F1值。我们使用bootstrap来构造95%的自举置信区间(CI),计算放射科医师和CheXNet在10,000个自举样本上的平均F1得分,并从测试集中进行替换。我们将F1分数的第2.5和第97.5百分位作为95%自举CI。我们发现CheXNet达到了0.435的F1得分(95%CI 0.387,0.481),高于放射科医师平均值0.387(95%CI 0.330,0.442)。表1总结了每位放射科医师和CheXNet的表现。

表1. 我们将放射科医师和我们的模型与F1度量进行比较,这是模型的精度和召回率的平均值。 CheXNet获得0.435的F1分数(95%CI 0.387,0.481),高于放射科医师平均值0.387(95%CI 0.330,0.442)。 我们使用bootstrap发现两者性能差异在统计学上是显着的。

为了确定CheXNet的表现是否明显高于放射科医师的表现,我们还计算了CheXNet的平均F1得分与放射科医师在相同自举样本上的平均F1得分之间的差异。 如果差异的95%CI不包括零,我们得出结论:CheXNet的F1得分与放射学家的F1得分之间存在显着差异。 我们发现F1评分的差异--0.05(95%CI 0.005,0.084) - 不包含0,因此认为CheXNet的表现在统计学上显着高于放射科医师的表现。

-

- 局限性

我们确定了这种比较的三个局限性。首先,在诊断过程中仅向放射科医生和模型提供了正面X光片,但已经表明,高达15%的准确诊断需要横向观察(Raoof等,2012)。 因此我们期望这个设置提供了一个保守的性能估计。 第三,模型和放射学家都不允许使用病史,这已被证明可以降低放射科医师在解释胸片方面的诊断性能(Berbaum et al,1985; Potchen et al,1979); 例如,鉴于肺部异常,有发热和咳嗽史,肺炎可能是适当的,而不是较不特定的术语,如浸润或巩固(Potchen等,1979)。

表2. CheXNet胜过了ChestX-ray14数据集中所有14种病变的最佳发表结果。 在检测肿块,结节,肺炎和肺气肿时,CheXNet与先前的技术水平相比具有gt; 0.05的AUROC余量。

- CheXNet与其他模型结果比较

我们通过做出三个改变来扩展算法以分类多个胸部病变。 首先,ChexNet不是输出一个二进制标签,而是输出一个二进制标签矢量,指示以下14个病理类别中每一个的存在或不存在:肺不张,心脏肿大,巩固,水肿,扩散,肺气肿,纤维化,疝气,浸润 ,肿块,结节,胸膜增厚,肺炎和气胸。 其次,我们将CheXNet中的最终完全连接层替换为一个产生14维输出的完全连接层,之后我们应用一个单向S形非线性。最终输出是每个病理学类别出现的预测概率。 第三,我们修改损失函数以优化未加权的二进制交叉熵损失的总和:

其中p(Yc = 1|X)指图片中包含疾病c的概率,相反p(Yc = 0|X)指图片中不包含疾病c的概率.

根据之前关于ChestX-ray14(Wang等人,2017; Yao等人,2017)的工作,我们将数据集随机分为训练(70%),验证(10%)和测试(20%。 我们确保分组之间没有患者重叠。 我们将该模型的每类AUROC与Yao等人所掌握的先前的艺术状态进行比较。我们发现CheXNet在所有14个病理学课程中取得了最先进的成果。 表2说明了测试集上的每类AUROC比较。 关于肿块,结节,肺炎和肺气肿,我们的表现优于先前的技术水平(AUROC增加gt; 0.05)。

- 模型热图说明

为了解释网络预测,我们还使用类激活映射(CAM)生成热图,以便可视化图像中与疾病最相关的区域(Zhou et al,2016)。为了生成CAM,我们将图像馈送到完全训练的网络中,并提取由最终卷积层输出的特征图。 假设fk是第k个特征映射,并且令wc,k是特征映射k导致病理学c的最终分类层中的权重。我们通过使用相关权重对特征映射进行加权求和得到一个最突出特征的地图Mc,用于将图像分类为病理c。从形式上看,

通过将地图Mc放大到图像的尺寸并覆盖图像,我们确定模型在预测病理学c时使用的最重要的特征。

图2显示了肺炎检测任务以及14类病理分类任务的CAM的几个例子。

- 相关工作

深度学习和大型数据集的最新进展使得算法能够在各种医学成像任务中超越医学专业人员的表现,包括糖尿病视网膜病变检测(Gulshan,2016),皮肤癌分类(Esteva et al,2017),心律失常检测(Rajpurkar,2017)和出血鉴定(Grewal,2017)。

利用肺结核分类算法(Lakhani&Sundaram,2017)和肺结节检测算法(Huang等,2017),自胸部X光片的自动诊断受到越来越多的关注。 伊斯兰教等人。 (2017)使用公开可用的OpenI数据集研究了各种卷积架构在不同异常情况下的性能(DemnerFushman et al,2015)。Wang等人 (2017年)发布了ChestXray14,比先前的同类数据集大一个数量级,并且还对在ImageNet上预先训练过的不同卷积神经网络架构进行了基准测试。最近yao等人(2017)利用标签之间的统计相关性来进行更准确的预测,优于Wang等人(2017)14个类中的13类。

- (b) (c)

(d) (e) (f)

图2. CheXNet使用类激活图将其识别的病理局部化,这些图激发了对于进行特定病理分类最重要的X射线区域。其中一名执业放射科医生提供每张图片的标题。(a)多焦社区获得性肺炎患者。该模型能够正确检测左下肺叶和右上肺叶的空气病变,以达到肺炎诊断。(b) 患有左肺结节的患者。 该模型识别左肺下叶结节并正确分类病理。(c) 患有原发性肺恶性肿瘤的患者和两个大肿块,一个在左下叶,一个在纵隔附近的右上叶。该模型可以正确识别X射线中的两个质量。(d) 患者右侧气胸和胸管。该模型检测异常肺,以正确预测气胸(塌陷肺)的存在。(e) 右胸大量积液(胸腔积液)。该模型正确标记积液,并专注于右下胸部。(f) 充血性心力衰竭和心脏扩大患者(心脏扩大)。该模型正确识别放大的心脏轮廓。

- 总结

肺炎占患者发病率和死亡率的很大一部分(GoncalcalPereira等,2013)。 早期诊断和治疗肺炎对预防包括死亡在内的并发症至关重要(Aydogdu et al,2010

全文共12312字,剩余内容已隐藏,支付完成后下载完整资料

资料编号:[12339],资料为PDF文档或Word文档,PDF文档可免费转换为Word