英语原文共 9 页

基于部分亲和度场的实时多人2D姿态估计

Zhe Cao , Tomas Simon, Shih-En Wei, Yaser Sheikh

卡内基梅隆大学机器人研究所

{zhecao,shihenw}@cmu.edu {tsimon,yaser}@cs.cmu.edu

翻译:by 刘宇昂

摘要:我们提出了一种高效识别图片中多人2D姿态的方法。该方法使用了非参数化的表示,定义为部分亲和度场(PAFs),来学习图片中身体部位与整体的关系。该架构对全局姿态进行编码,允许贪心的自下而上解析姿态,无论图像中的人有多少,都能达到高的精度,同时实现实时性能。另外,该架构通过相同的顺序预测过程的两个分支来共同学习部位的位置及其关联。该方法首先应用于COCO 2016姿态挑战库,实验结果显示其性能和效率都远远超过了此前MPII多人基准测试的结果。

介绍

人体2D姿态估计——定位解剖学关键点或者“部位”的问题——着眼于寻找个体的身体部位[8, 4, 3, 21, 33, 13, 25, 31, 6, 24]。推断图片中多人的姿态,尤其是识别活动场景下的个体,对我们提出了一系列独特的挑战。首先,每个图像可能包含出现在任何位置或任何比例的未知数量的人。第二,由于接触、遮挡和肢体关节、人与人之间的相互作用引起复杂的空间干扰,导致得部位之间的关联变得困难。第三,随着图像中人数的增加,运行时间复杂度增加,使得实时性能成为一项挑战。

常见的方法[23,9,27,12,19]是采用人体检测器对每次检测的结果进行单人姿势估计。这些自上而下的方法直接借助于现有的单人姿态估计的技术[17, 31, 18, 28, 29, 7, 30, 5, 6, 20],但受着前期结果的影响:如果人体检测器检测失败——当人与人靠的近时很容易造成检测失败——就不能继续进行姿态估计。此外,这些自顶向下的方法的运行时间与图像中的人数成正比:对于每次检测后运行单人姿势估计,如果人越多,计算成本就越高。相比之下,自下而上的方法很值得关注,因为它们使前一阶段的结果具备了稳健性,并且有可能使运行复杂度不受图像中人数的影响。然而,自下而上的方法并不直接使用来自其他身体部位和其他人的全局姿态关系。在实践中,之前的自下而上的方法[22,11]并不能保证效率的提高,因为最终的解析需要大量的的全局推理。例如,Pishchulin等人的开创性工作[22]提出了一种自下而上的方法,标记候选检测部位并将其与个体联系起来。然而,在全连通图上求解整数线性规划问题是NP难问题,平均处理时间是数小时。Insafutdinov等[11]建立了在[22]基于ResNet [10]和依赖于图像成对关联分数的强大部位检测器,并大大改善了运行时间,但该方法由于部位处理数量的限制,处理一张图像仍然需要几分钟。[11]中使用的成对表示难以精确回归,因此需要独立的逻辑回归。

在本文中,我们提出了一种有效的多人姿态估计方法,在多个公共基准测试中具有最高的精度。我们通过部分亲和度场(PAF)呈现关联分数的第一个自下而上的表示,PAF是一组2D矢量场,其编码肢体在图像区域上的位置和方向。我们证明,同时推断这些自下而上的检测和关联表示足以很好地编码全局姿态关系,使得贪心的解析能够以很小的计算成本获得高质量的结果。我们公开发布了完全可复用的代码,为多人2D姿态检测提供了第一个实时系统。

图1.上:多人姿态估计。身体部位属于同一个人是相连的。左下:部分亲和度场(PAF)对应于连接右肘和右腕的肢体。颜色编码方向。右下图:预测PAF的放大视图。在场中的每个像素处,2D矢量编码肢体的位置和方向。

方法

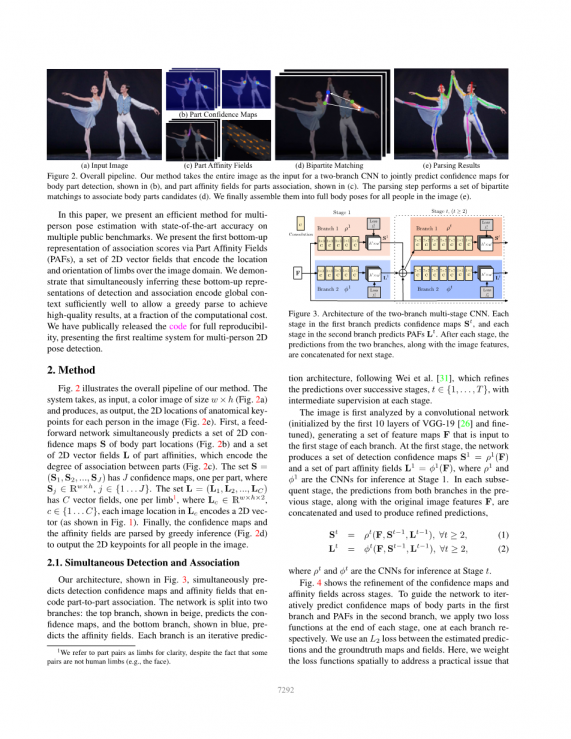

图2.整体过程。在部位(b)中,和部位关联的部分亲和度场,如(c)所示。解析步骤执行一组二分匹配以关联身体候选部位(d)。我们最终将它们组装成图像中所有人的全身姿态。

图2说明了我们方法的整个过程。该系统采用尺寸为wtimes;h的彩色图像作为输入(图2a),并且产生图像中每个人的解剖学关键点的2D位置作为输出(图2e)。首先,前馈网络同时预测一组身体部位位置的2D置信图S(图2b)和一组部分亲和度的2D矢量场L,它们编码部位之间的关联程度(图2b)。集合S =(S1,S2,...,SJ)具有J个置信图,每个部位一个,其中Sjisin;Rwtimes;h,jisin;{1...J}。集合L =(L1,L2,...,LC)具有C个矢量场,每个肢体一个,其中Lcisin;Rwtimes;htimes;2,cisin;{1...C},Lc中的每个图像位置编码一个2D矢量(如图1所示)。最后,通过贪心推理(图2d)分析置信度图和亲和度场,以输出图像中所有人的2D关键点。

同时检测和关联

图3.双分支多级CNN的体系结构。第一分支中的每个阶段预测置信图St,并且第二分支中的每个阶段预测PAF Lt。在每个阶段之后,来自两个分支的预测以及图像特征被连接用于下一阶段。

我们的架构,如图3所示,同时预先确定了编码部位间关联程度的检测置信度图和亲和度场。网络分为两个分支:顶部分支(以米色显示)预测置信图,底部分支(以蓝色显示)预先确定亲和度场。根据Wei等人的方法[31],每个分支是一个迭代的预测结构,它改进了连续阶段的预测,tisin;{1,...,T},每个阶段都有中间监督。

首先通过卷积网络分析图像(由VGG-19 [26]前10层初始化并进行微调),生成一组特征图F,输入到每个分支的第一级。在第一阶段,网络产生一组检测置信度图S1 =rho;1(F)和一组部分亲和度场L1 =phi;1(F),其中rho;1和phi;1是阶段1用于推断的CNN。在每个后续阶段,来自前一阶段的两个分支的预测以及原始图像特征F一起串联并用于产生精确的预测,

|

(1) |

||

|

(2) |

其中rho;1和phi;1是阶段1用于推断的CNN。

图4.右前臂的右手腕(第一排)和PAF(第二排)的各个阶段的置信度图。虽然在前期阶段左右身体部位和肢体之间存在混淆,通过后期的全局推理,估计逐渐准确,如突出区域所示。

图4显示了各阶段的置信图和亲和度场的细节。为了引导网络以第一分支中的身体部位和第二分支中的PAF的置信图进行预测,我们在每个阶段的末尾应用两个损失函数,分别在每个分支处应用一个。我们在预测估计与真实的图和场之间使用L2损失。这里,我们在空间上权衡损失函数以解决实际中一些数据集没有完全标记出所有人的问题。

具体而言,阶段t的两个分支处的损失函数是:

|

, |

(3) |

|

|

, |

(4) |

其中是真实部位的置信度图,是真实部位的亲和度矢量场,W是当在图像位置p处缺少注释时W(p)= 0的二元掩模。掩模用于避免在训练期间惩罚真阳性的预测。每个阶段的中间监督通过定期补充梯度来解决梯度消失的问题[31]。总体的目标是:

|

. |

(5) |

部位检测的置信度图

为了在训练期间评估方程(5)中的fS,我们从带注释的2D关键点生成真实的置信度图S*。每个置信度图是对特定身体部位出现在每个像素位置的置信度的2D表示。理想情况下,如果图像中出现单个人,如果相应部分可见,则每个置信度图中应存在单个峰; 如果出现多个人,则每个人k应该存在对应于每个可见部位j的峰值。

我们首先为每个人k生成个体置信图。 令xj, kisin;R2为图像中人k的身体部位j的真实位置。 中位置pisin;R2处的值定义为,

|

|

(6) |

其中sigma;控制峰值的发散程度。网络预测的真实置信图是通过max运算符对各个置信度图的整合,

|

. |

(7) |

我们采用了置信度图的最大值而不是平均值,所以峰值附近的精度有所差异,如右图所示。在测试时,我们预测置信图(如图4的第一行所示),并通过执行非极大值抑制来获得身体部位的候选。

部位关联的部分亲和度场

图5.部位关联策略。(a)两个身体部位类型的检测候选对象(红色和蓝色点)和所有连接候选对象(灰线)。(b)连接结果使用中点(黄点)表示:正确的连接(黑线)和不正确的连接(绿线),它们与入射约束相同。(c)使用PAF的结果(黄色箭头)。通过在肢体骨架上编码位置和方向,PAF消除了错误的关联。

给定一组检测到的身体部位(如图5a中的红色和蓝色点所示),如何组合它们以形成未知数量的人的全身姿态?我们需要对每对身体部位检测的关联度即它们属于同一个人的置信度进行度量。测量关联的一种可能方式是检测肢体上每对部位之间的附加中点,并检查其在候选部位之间的发生率,如图5b所示。然而,人们很容易聚集在一起,这时,这些中点可能造成错误的关联(如图5b中的绿线所示)。这种错误的关联是由于表示中的两个限制而引起的:(1)它只编码每个肢体的位置,而没有方向; (2)它将肢体支撑的区域缩减到一个点。为了打破这些局限性,我们提出了一种新的特征表示,称为部分亲和度场,它保留了肢体支撑区域的位置和方向信息(如图5c所示)。部份亲和度是每个肢体的2D矢量场,也如图1d所示:对于属于特定肢体区域中的每个像素,一个2D矢量编码从肢体的一部位指向另一部位的方向。每种类型的肢体都有一个相应的亲和力场,连接两个相关的身体部位。

考虑右图所示的单肢。令xj1, k和xj2, k为图像中人k的肢体c的身体部位j1和j2的真实位置。如果点p 位于肢体上,则(p)处的值是从j1指向j2的单位矢量; 对于所有其他点,向量是零值的。

为了评估等式中的fL,在训练期间,我们在图像点p处定义真实部分亲和度矢量场为:

|

|

|

(8) |

这里, 是肢体方向上的单位矢量。肢体上的点集被定义为线段长度范围内的那些点,即

0 le; v·() le; 和 |vperp;· ()| le; sigma;l,

其中肢体宽度sigma;l是以像素为单位的长度,肢体长度是

资料编号:[5950]