英语原文共 6 页,剩余内容已隐藏,支付完成后下载完整资料

通过随机突触传递强化的脉冲神经网络学习

摘要:

众所周知的,化学突触传递是一个不可靠的过程,但这种不可靠性的功能尚不清楚。在这里,我提出假设,突触传递的随机性由大脑记录并学习,类似于达尔文的进化论是利用了遗传变异的方式。如果突触是“享乐的”,他们通过增加自身囊泡释放或失败的概率来回应一个全球的奖励信号,那么这个假设就是可能的,这取决于哪一个动作是刚刚好在奖励之前发生的。享乐突触的学习是通过计算一个随机的平均报酬的梯度的近似值来计算的。他们和像短期化便利化和抑制化的突触的动态、树突整合的复杂性、动作电位的产生是相互兼容的。一个由享乐突触构成的网络能够通过监管适当的报酬来训练,通过训练来表现出一个需要的计算,就像显示的那样,通过整合和火灾模型神经元的数值模拟来完成。

介绍:

许多类型的学习能够被视为优化。例如,操作性条件理论可以被视为动物适应他们的行为来获取最大报酬的过程。格言”熟能生巧”指的就是像弹钢琴或打网球这样的复杂运动的迭代改进。人们普遍认为,学习至少有一部分基于大脑中突触结构的可塑性。因此,有可能有一些类型的突触的可塑性被定制出来专门用于优化神经回路的功能。

这样的突触可塑性能够采用什么样的具体形式呢?为了刺激想象力,从进化中汲取灵感是有帮助的,进化是生物学中的优化过程的重要案例。进化的一个有趣的方面就是要依赖于不完善的基因复制。这种不可靠性有可能是不被希望得到的,但是随机的突变和重组对于产生变异是很重要的,这允许进化去搜索改进的基因型。

一个不可靠的方法还在于在神经计算的核心:突触传递。当由动作电位去极化后,在突触前末梢可释放的神经递质或失败(Stevens, 1993)。乍一看,这样的不可靠性可能会感到惊奇,并可能损害大脑功能。但是另一种可能性就是突触的不可靠性被大脑用作学习的目的(Minsky, 1954 ; Hinton, 1989),这与不可靠的基因复制被用作进化的方式相类似。

现在我提出这一观点的一个具体的实现。根据该提议,享乐的突触通过增加他们释放和失败的概率的可能性来响应一个全球的报酬信号,这取决于动作是正好优先于报酬的。值得注意的是,如果一个网络中的说有的突触的行为都是享乐的,也就是说自私的寻求报酬,那么这个网络的整体就会表现出享乐,通过学习产生相应的集体动作,以增加它们的平均奖励。这个陈述能够被证明是数学上合理的,并且定义了享乐突触通过服务优化功能的概念。

享乐主义突触的概念可能和任何增强或监督信号广播的脑区域是相关的。例如,有证据表明,神经调节章鱼胺被用作蘑菇体内的一种奖励信号,嗅觉学习在昆虫脑中的一个位置( Menzel,2001)。章鱼胺是通过VUM神经元交付的,这种神经元弥漫在蘑菇体内。同样地,脊椎动物的纹状体从黑质中的多巴胺神经元中获取浓密突起,看起来就像是携带了一个全球的奖励信号(Montague et al., 1996; Schultz, 2002)。攀爬纤维输入到小脑中可能会提供一个凝视稳定行为的适应的误差信号,就像是庭前眼反射一样(Ito, 2001)。

在接受这样的全球的增强信号脑区域中,通过全球的信号和其它突触本地的信号的相互作用来驱动突触的可塑性是可能发生的。找到控制这些相互相互作用的具体的规则是一个非常重要的挑战。像享乐主义的突触这样的假说可能证明在脑中结合全球信号和本地信号的学习规则的查找方面是有用的。

应当注意的是,优化模型神经的突触连接的许多方法已在机器学习领域已探索。一个著名的案例就是反向传播算法,这种算法用于计算的目标函数相对于网络的突触强度的梯度(Rumelhart et al., 1986)。许多反向传播算法的替代品也不断的被提出(Barto et al., 1983;Narendra and Thathachar, 1989; Mazzoni et al., 1991; Williams, 1992; Jabri and Flower, 1992; Cauwenberghs, 1993; Unnikrishnan and Venugopal, 1994)。

然而,所有的针对神经网络的模型都被制定完成,但是没能够包含两个基本的神经生物学事实。首先生物突触被突触前的动作电位驱动,调节突触后膜的电导。其次,突触传递的有效性随着时间脉冲动态的变化,由于短期的便利化和抑制(Thomson, 2000)。这篇文章所研究的学习规则同时兼容上面提到的两点生物突触特征。

从本质上来说,目前的工作是投机性的。这种假设的可塑性的具体形式可能会证明在大脑中是存在的。即使它是不存在的,依赖于以优化为目的的微观随机性的生物突触的一般概念仍然可能是正确的。我们可以想出很多可能实现的概念,享乐的突触只是其中的一个而已。本文更广泛的目标在于刺激理论家去假想这些可能并用实验来探索它们。

结果:

在操作性条件理论中,奖励一只动物趋向于增加在奖励之前马上表现处理的动作的可能性。根据一种解释,这种现象的发生是因为动物是享乐主义的,或者说是寻找奖励的。

为什么突触和动物类似是享乐主义的呢?为了阐述类比,假定一个突触可能的“动作”只用两个数字表示。当突触前脉冲刺激,突触释放一个囊泡的神经递质,或无法释放。一个享乐主义的突触遵守下面的学习法则。

(规则1)如果奖励紧随释放之后,那么释放的概率就会增加。如果奖励紧随失败之后,那么释放的概率就会降低。

(规则2)如果惩罚紧跟释放之后,那么释放的概率就会降低。如果惩罚紧随失败之后,那么释放的概率就会增加。

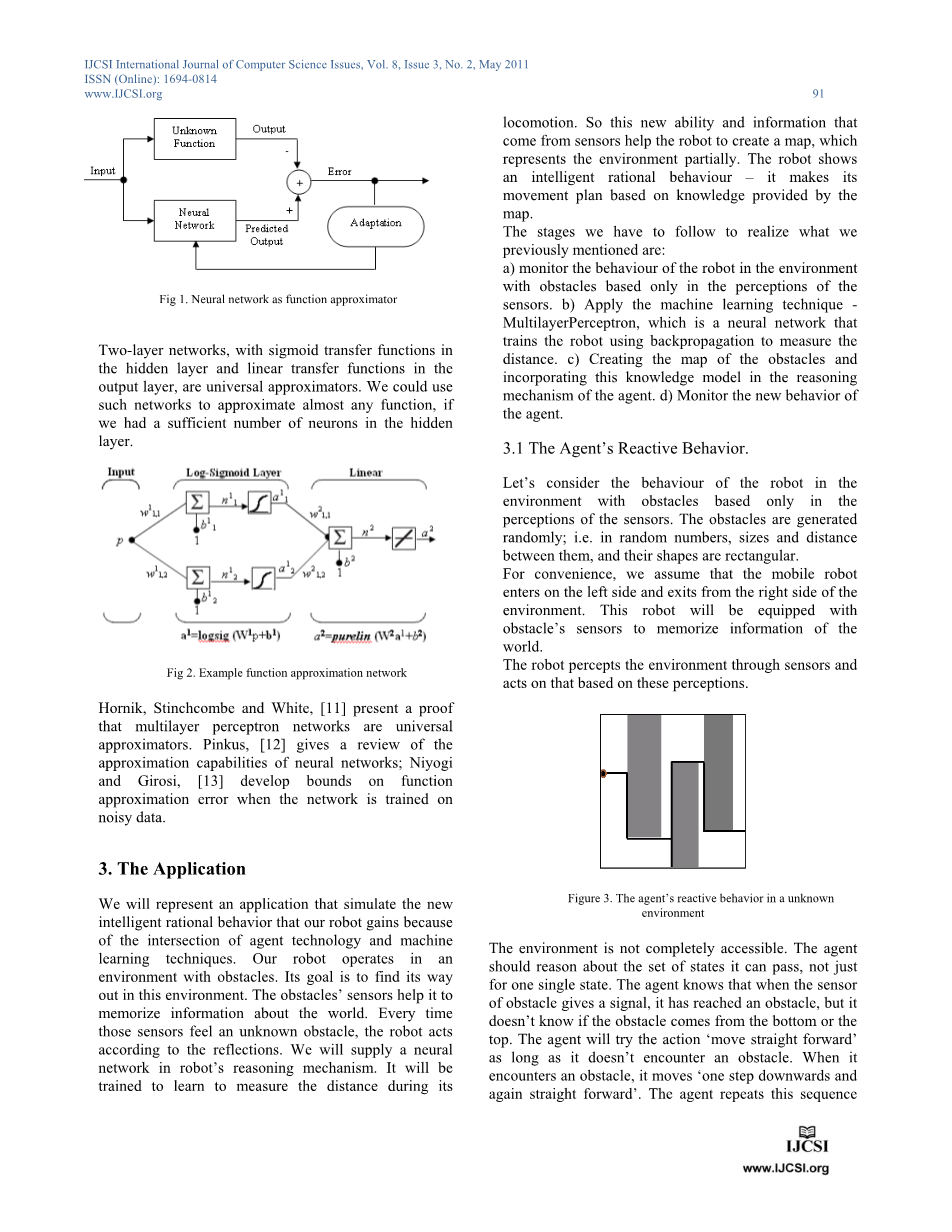

为了从强化中学习,一个享乐主义的突触必须要保存它最近一次的释放和失败的记录。这需要通过一个被称为合格跟踪的动态变量提供(Klopf, 1982)。每一个突触的学习是由带有全球增强信号的本地合格变量的结果驱动的(图1)。

享乐主义的突触模型的全部描述是通过实验过程给出的,它要比图1中的描述要复杂一些因为它是由像短期的便利化和抑制化的效果来组成的。这些效果被在图1-4中的简化体中被忽略了,但是包含在最后图5中的案例中。

训练多层网络

现在思考一个享乐突触构成的神经网络。这个网络能够通过奖励被希望的行为和惩罚不希望的行为来训练。图2解释了一个拥有多层感知结构的特殊的案例。60个输入神经元是泊松脉冲训练,60个隐藏神经元和一个输出神经元是整合和火灾模型(见实验过程)。这个网络训练之后表现出二进制变量的异或运算。每个二进制变量被编码为半数输入神经元的点燃率(图2A)。异或运算是神经网络训练的经典标杆,因为一个简单的单层感知器是不能代表它的;必需要有一个多层的感知器。

呈现输入,然后根据输出神经元的活动来奖励或者惩罚突触,这样训练就完成了。进一步来说,当输入为“01”或者“10”的时候,突触会在每一个输出脉冲得到奖励。当输入为“00”或者“11”的时候,突触会在每一个输出脉冲受到惩罚。换句话来说,强化信号是输出神经元的脉冲训练或者是它的否定。在训练之前,网络回应“11”脉冲的平均值要多于回应“01”或者“10”。通过每个输入模式的200次循环之后,网络学会了对“01”和“10”作出了回应,并且会压制所有的“11”脉冲(图2B)。

重要的是,要注意一个单一随着时间变化的奖励信号能够满足整个网络的训练,不仅仅包括直接反馈给输出神经元的突触,还有从输入神经元到隐藏神经元的突触。非本地化的监督信号的传播让人想起反向传播学习,但是他们有一个重要的区别。反向传播的误差信号是通过一种以一种具体的方式依赖网络的结构和它的突触强度的精确值的计算来传播的。相比之下,对一组享乐的突触的奖励信号的广播需要交流而完全不需要计算。

释放失败对抗

在图2中,训练的最后结果是,突触通过改变它们释放的概率以增加在网络中获取的奖励,从而提高它在异或运算上的性能。突触是如何确定释放概率的改变以适应增加的奖励。简短的说就是一个享乐主义的神经元通过两个交叉相关性来学习,其中一个是释放与奖励之间的相关性,一个是失败与奖励之间的相关性。这两个相关性的区别告诉突触它如何行动与奖励是有因果关系的。

为了证明这一点,用图3中的回路模型是进行模拟。这个回路保留了图2中训练的更大的网络的基本元素。输入神经元产生了一个泊松脉冲分布,其它的神经元都是整合和火灾模型。输出神经元的脉冲训练被视为奖励信号。每一个神经元的释放奖励相关性和失败奖励相关性函数都是用图来表示的。他们之间的区别显示了为了最大化奖励是要增加释放概率还是要降低释放概率。因为这个回路是这样简单,所以我们直接每个突触进行验证。

特别地,一个突触特别惊人的展示出学习信号主驻留在两种相关性之间的区别,而不是单独的某一个相关性。这是从输入神经元到中间神经元的突触。因为实现和奖励是正相关的,人们可以错误地推断出释放的概率可能会增加。然而,正相关是是因为从输入神经元到输出神经元的其他的途径。它证明了失败也与奖励是正相关的,这种相关性甚至如此强烈。因此,释放概率应该降低以最大化报酬。这个实例说明在可塑性上的对抗效果对释放和失败是重要的。而两个相关性的不同提供了一个合适的学习信号,应该注意的是,信号被学习噪音所遮蔽,随机的波动会损坏基于一个有限时间间隔的相关性估计。这就意味着学习的动态执行一个在参数空间上偏好增加平均奖励的方向的随机游走。这种行为的独特的术语被称为“爬山”,这源自于可视化的平均奖励作为参数空间上的艺术高度。正式的术语在实验过程中解释为“随机梯度上升”。

匹配法则

在图2的模拟中,强化是网络行为的确定性函数,但是享乐的学习对概率强化的内容也是适用的。这种上下文一直在心理学家关于匹配法则的报告中被广泛的研究(Davison and McCarthy, 1988; Gallistel, 1994)。当动物们在具有竞争性的替代品中反复选择的时候,它们会散布它们的选择,从而来自替代品的返回值大约上是相等的。返回值被定义为被选择的次数除以一个替代品的所有奖励。图4说明了一个包含享乐突触的神经回路能够在重复的在两个概率上以奖励为诱饵的目标上选择时学习匹配的行为。就像是实验过程所解释的那样,一个并发可变间隔的奖励表的离散时间版本被使用。每当图4A的决策回路选择一个诱饵目标,他就会手收获奖励,奖励会促进决策回路中享乐突触的可塑性。选择决策回路选择两个目标的概率,根据它的前馈突触的随机性。起初,它根据大致相同的规律选择,但是随着时间的推移,它学会了一个基本上满足匹配规则的偏好(图4C)。

动态突触

对于任何在生物上合理的突触学习规则,它一定要能够解决生物突触的效果不是静态的,而是从一个脉冲到下一个脉冲不断变化着的事实(Tsodyks et al., 1998)。虽然突触传递的特征在上一个简化的例子中是被忽略的,但是它和享乐突触模型是相互兼容的。短期的可塑性的实现在实验过程中被解释,图5A说明了它的行为,它描述了突触后对突触前脉冲平均响应的模拟。两条曲线的比较表明在训练的过程中对第一个囊泡释放的概率影响后来脉冲的响应。如果起初释放的概率是高的,成功的响应就会被抑制。如果起初释放的概率是低的,在抑制之后就会表现出便利化。这与生物突触的测量在定性上是一致的(Markram and Tsodyks, 1996)。

如果这些动态的行为是可利用的,享乐突触能够学习并将它们用于计算,就像是图5其它部分表达的那样。整合和火灾模型的神经元的突触被分为两组。在训练的过程中,两组的突触会以一定的顺序依次的激活。一个顺序的响应脉冲是奖励的,另一个顺序的脉冲是惩罚的。在训练之后,一个时间顺序的模型神经元平均脉冲响应比另一个大。响应的选择性被实现,因为两组突触学习不同的动态行为。一组学会了快速抑制,所以它的尖峰响应是即时的。另一组学会了便利化,有效地介绍了时间延迟到其峰值响应。这样的一个时间延迟是已知足以提供选择性排序的上升的(Chance et al. , 1998; Buchs and Senn, 2002)。

突触后电压依赖性

在某些突触中,长期可塑性的感知需要突触后神经元的去极化,另外还需要突触前脉冲(Malenka and Nicoll, 1999)。这个属性通常被视为海扁学习的特点,但是实际上它也与享乐学习是兼容的。虽然基本的学习规则R1和R2不依赖突触后神经元的状态(除非是在突触后脉冲是奖励信号这样的特殊的情况下),但是这样的依赖是一种自然的修饰。为了要理解为什么,回想一个享乐神经元通过比较释放与奖励的相关性和失败与奖励的相关性来决定它的动作如何与奖励产生因果关系。突触前神经元远小于阈值的期间,释放和失败对网络的其他部分没有作用,因此对奖励没有作用。一个享乐突触最好是空闲的,可以无视这样的时间段,因为他们只是对学习噪声有贡献,对学习信号没有贡献。

因此,修改规则R1和规则R2是有优势的,以致如果突触后电压值远低于突触前脉冲环境下的时间窗口的阈值,他们就不实用了。一个警告应该注意,根据这个修改,享乐突触的可塑性依赖于突触后的去极化而不需要突触后的脉冲。根据一些实验,更强的条件对长期的强化是必需的(Magee and Johns-ton, 1997)。

突触后可塑性的轨迹

众所周知的是,生物突触的长期可塑性能够通过改变囊泡释放的概率发生(Dale et al., 1988; Stevens and Wang,1994; Bolshakov and Siegelbaum, 1995)。这样一个突触后可塑性的轨迹与一个享乐突触的基本模型是一致的。然而,长期的可塑性也会通过囊泡释放诱导的突触后电导振幅的改变发生(Malenka and Nicoll, 1999)。这表明了下面

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[154238],资料为PDF文档或Word文档,PDF文档可免费转换为Word